主要内容

RL代理

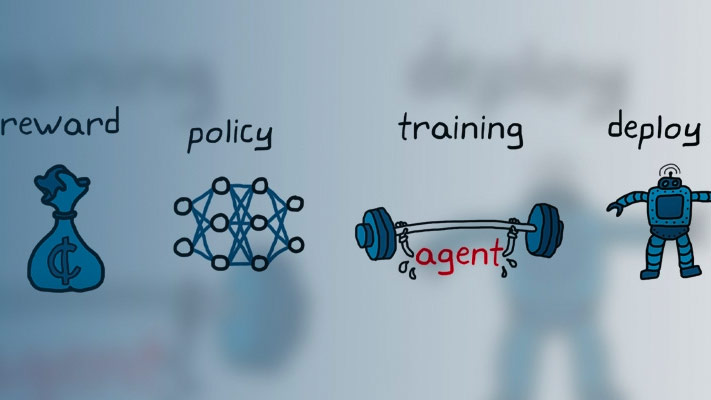

强化学习代理

- 库:

强化学习工具箱

描述

使用RL代理块来模拟和训练强化学习代理模型万博1manbetx®。你把块与一个代理存储在MATLAB中®工作区或一个数据字典作为一个代理对象,如一个rlACAgent或rlDDPGAgent对象。你连接块,它接收一个观察和计算奖励。例如,考虑下面的框图rlSimplePendulumModel模型。

的观察输入端口的RL代理块接收信号来源于瞬时摆角和角速度。的奖励端口接收来自相同的两个值奖励计算和应用行动。配置合适的观察和奖励计算您的系统。

块使用代理来生成一个基于您提供的观察和奖励的行动。连接行动输出端口到适当的输入系统。例如,在rlSimplePendulumModel,行动港口是一个扭矩应用于摆系统。关于这个模型的更多信息,参见火车DQN代理和平衡摆摆动。

在模型训练强化学习代理,你从模型生成一个环境模型。万博1manbetx然后您创建和配置代理对环境培训。有关更多信息,请参见创建模型强化学万博1manbetx习环境。当你打电话火车使用环境,火车模拟模型和更新相关的代理。

港口

输入

输出

参数

模型的例子

介绍了R2019a