深度学习导入、导出和定制

从TensorFlow™-Keras、Caffe和ONNX™(开放神经网络交换)模型格式中导入网络和网络架构。您还可以将经过培训的深度学习工具箱™网络导出为ONNX模型格式。

您可以为您的问题定义自己的自定义深度学习层。您可以使用自定义输出层指定自定义丢失函数,并定义带有或不带有可学习参数的自定义层。例如,对于类分布不平衡的分类问题,可以使用带加权交叉熵损失的自定义加权分类层。定义自定义层后,可以检查该层是否有效,GPU是否兼容,以及输出是否定义了正确的梯度。

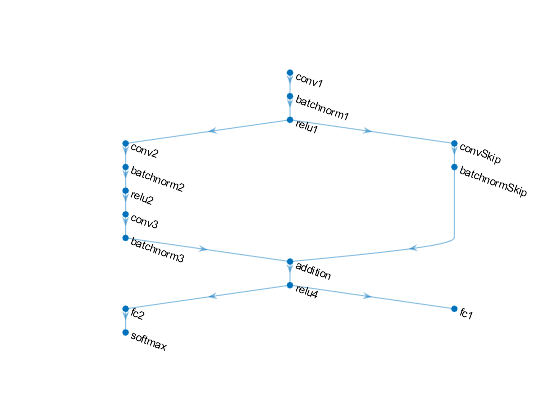

如果trainingOptions函数不提供任务所需的训练选项,或自定义输出层不支持所需的丢失函数,则可以定义自定义训练循环。万博1manbetx对于不能使用层图创建的网络,可以将自定义网络定义为函数。想了解更多,请看定义自定义的训练循环、损失函数和网络.

功能

主题

自定义图层

学习如何定义自定义深度学习层。

学习如何检查自定义深度学习层的有效性。

这个例子展示了如何定义一个PReLU层,并在卷积神经网络中使用它。

本例演示了如何定义自定义加权加法层,并将其用于卷积神经网络。

这个例子展示了如何定义一个带有平方和误差(SSE)损失的自定义分类输出层,并将其用于卷积神经网络。

这个例子展示了如何定义和创建一个带有加权交叉熵损失的自定义加权分类输出层。

这个例子展示了如何定义一个具有平均绝对误差损失的自定义回归输出层,并将其用于卷积神经网络。

这个例子展示了如何定义PReLU层并指定一个自定义的向后函数。

这个例子展示了如何定义一个加权的分类层和指定一个自定义的向后丢失函数。

网络培训与装配

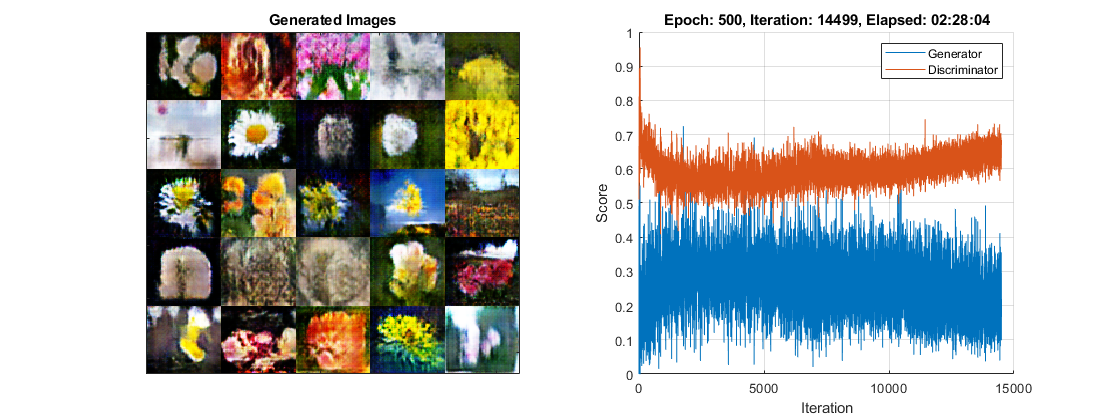

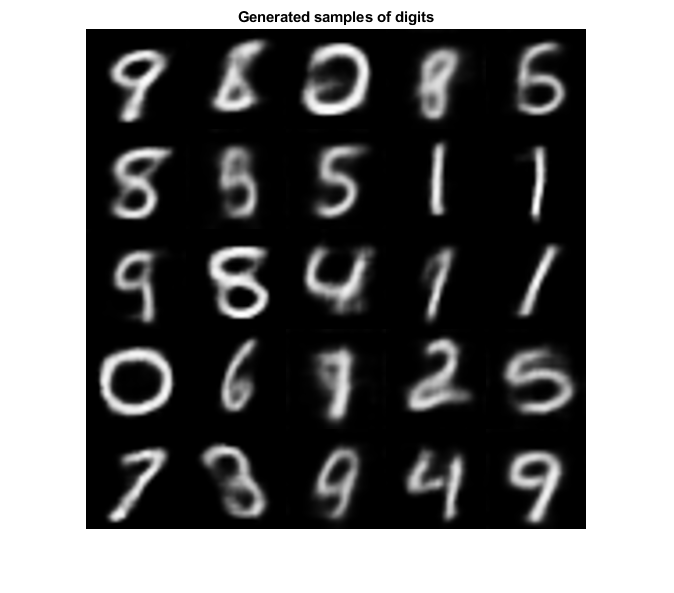

这个例子展示了如何训练一个生成式对抗网络(GAN)来生成图像。

这个例子展示了如何训练一个条件生成对抗网络(CGAN)来生成图像。

这个例子展示了如何训练一个暹罗网络使用降维来比较手写数字。

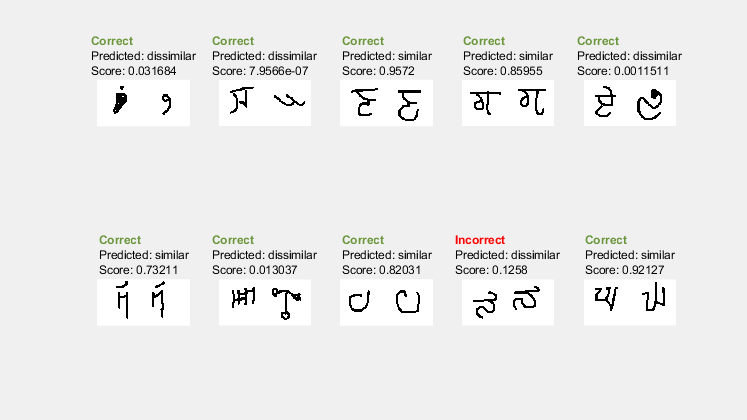

这个例子展示了如何训练一个暹罗网络来识别手写字符的相似图像。

学习如何定义和自定义深度学习训练循环、损失函数和使用自动区分的网络。

学习如何在自定义培训循环中指定公共培训选项。

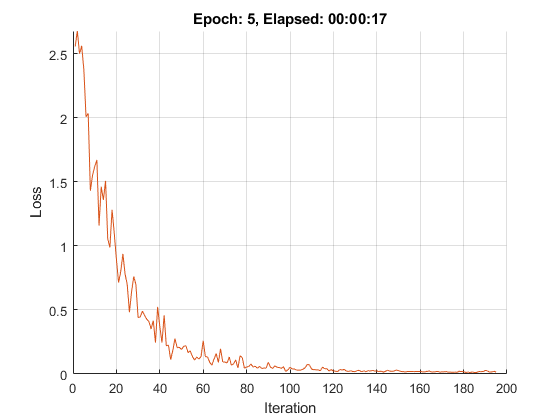

这个例子展示了如何训练一个网络,用一个自定义的学习速率表来对手写数字进行分类。

这个示例展示了如何在自定义训练循环中更新网络状态。

此示例演示如何使用a进行预测dlnetwork通过将数据拆分成小批来创建对象。

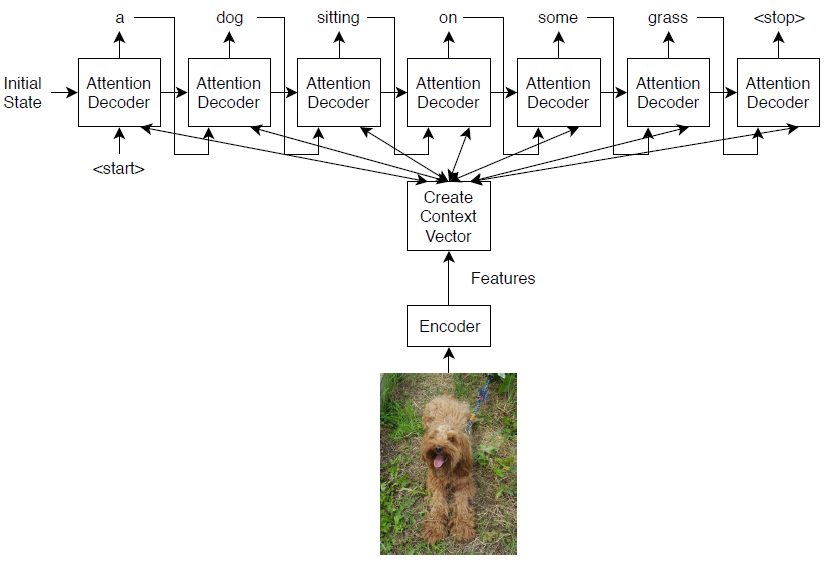

这个例子展示了如何使用函数而不是层图或a来创建和训练深度学习网络dlnetwork.

这个例子展示了如何在一个定义为函数的网络中更新网络状态。

这个例子展示了如何通过将数据分割成小批量来使用模型函数进行预测。

这个例子展示了如何使用不同的权值初始化器来训练深度学习网络。

这个例子展示了如何为卷积层和有漏洞的ReLU层创建一个自定义的加权初始化函数。

这个例子展示了如何从一个预先训练好的Keras网络中导入这些层,用定制层替换不支持的层,并将这些层组装到一个网络中,以便进行预测。万博1manbetx

多输入多输出网络

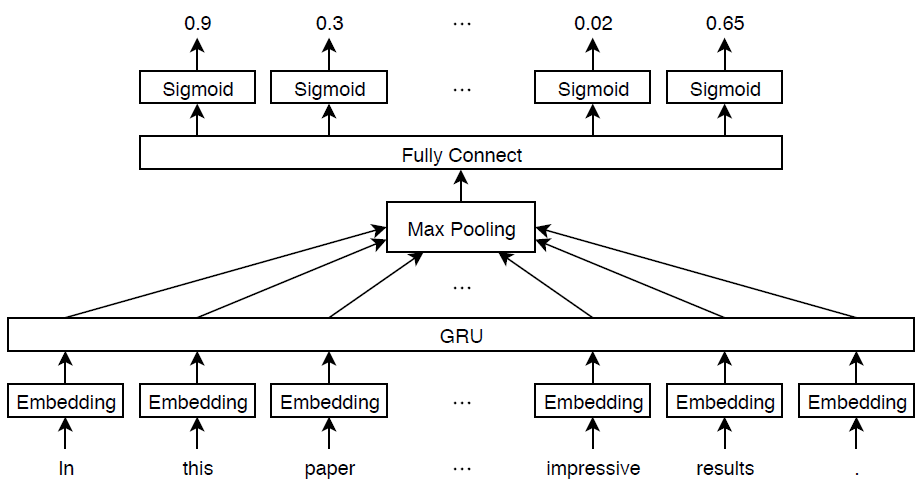

学习如何定义和训练具有多个输入或输出的深度学习网络。

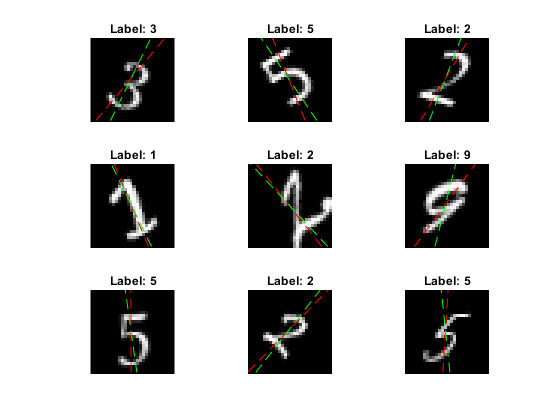

这个例子展示了如何训练一个具有多个输出的深度学习网络来预测手写数字的标签和旋转角度。

不使用模型函数进行预测,您可以将网络组装成一个DAGNetwork为预测做好准备functionToLayerGraph和assembleNetwork功能。

自动分化

学习自动区分是如何工作的。

如何在深度学习中使用自动区分。

查看支持的函数列表万博1manbetxdlarray对象。

这个例子展示了如何使用梯度加权类激活映射(Grad-CAM)技术来理解为什么一个深度学习网络会做出分类决策。