MATLAB的GPU计算支持万博1manbetx

英伟达人gpu

在支持NVIDIA cuda的gpu上执行MATLAB计算

MATLAB®使您能够使用英伟达®加速人工智能、深度学习和其他计算密集型分析的gpu,而不必成为CUDA®程序员。使用MATLAB和并行计算工具箱™,您可以:

- 使用NVIDIA gpu直接从MATLAB与超过500内置函数。

- 使用MATLAB workers和MATLAB并行服务器™访问桌面、计算集群和云上的多个gpu。

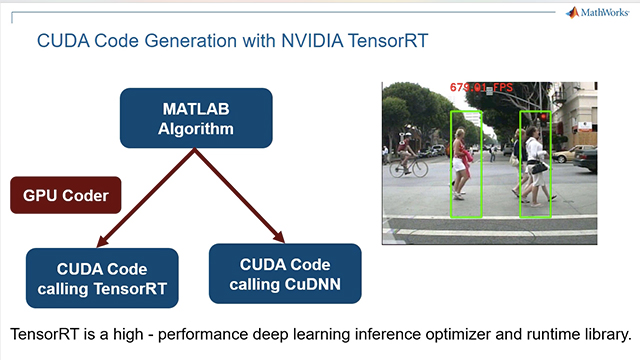

- 直接从MATLAB生成CUDA代码,使用GPU编码器™部署到数据中心、云和嵌入式设备。

- 从MATLAB中生成NVIDIA TensorRT™代码,使用GPU编码器实现低延迟和高吞吐量推理。

- 将MATLAB AI应用程序部署到支持nvidia的数据中心,使用MATLAB Production Server™与企业系统集成。

“我们的遗留代码花了40分钟来分析单个风洞测试;通过使用MATLAB和GPU,计算时间现在不到一分钟。我们花了30分钟让我们的MATLAB算法在gpu上工作——不需要底层的CUDA编程。”

克里斯托弗·巴尔,NASA

使用MATLAB进行GPU计算

利用MATLAB开发、扩展和部署深度学习模型

MATLAB允许单个用户使用deep learning Toolbox™实现端到端工作流,从而开发和培训深度学习模型。然后,您可以使用并行计算工具箱和MATLAB并行服务器使用云和集群资源扩展培训,并使用GPU编码器部署到数据中心或嵌入式设备。

使用gpu开发深度学习和其他计算密集型分析

MATLAB是一个用于人工智能和深度学习开发的端到端的工作流平台。MATLAB提供了用于导入训练数据集、可视化和调试、扩展训练CNNs以及部署的工具和应用程序。

用一行代码扩展到桌面、云和集群上的额外计算和GPU资源。

测试你自己的CPU和GPU硬件使用gpuBench。

用最小的代码变化在gpu上缩放MATLAB

使用500多个cuda支持的MATLAB函数在NVIDIA gpu上运行MATLAB代码。在工具箱中使用启用了gpu的功能,用于诸如深度学习、机器学习、计算机视觉和信号处理等应用程序。并行计算工具箱提供gpuArray这是一种特殊的数组类型,具有相关的函数,可以让您直接从MATLAB中在支持cuda的NVIDIA GPU上执行计算,而不必学习底层的GPU计算库。

工程师可以使用GPU资源,而不需要编写任何额外的代码,因此他们可以专注于他们的应用程序,而不是性能调优。

使用并行语言结构,例如parfor和spmd您可以在多个gpu上执行计算。在多个gpu上训练一个模型很简单,只需改变一个训练选项。

MATLAB还允许您将现有的CUDA内核集成到MATLAB应用程序中,而不需要任何额外的C编程。

使用TensorRT部署从MATLAB生成的用于推理部署的CUDA代码

使用GPU编码器从MATLAB代码中生成优化的CUDA代码,用于深度学习、嵌入式视觉和自主系统。生成的代码自动调用优化的NVIDIA CUDA库,包括TensorRT、cuDNN和cuBLAS,以运行在NVIDIA gpu上,具有低延迟和高吞吐量。将生成的代码作为源代码、静态库或动态库集成到项目中,并将其部署到运行在NVIDIA Volta之类的gpu上®,NVIDIA Tesla®,英伟达杰森®,NVIDIA驱动®。

探索产品s manbetx 845