火车

在指定的环境中训练强化学习代理

描述

例子

输入参数

输出参数

提示

火车随着培训的进行,更新代理。为了保存原始的代理参数供以后使用,请将代理保存到一个mat文件中。默认情况下,调用

火车打开Reinforcement Learning Episode Manager,它让您可视化培训的进度。《Episode Manager》情节显示了每一集的奖励、运行的平均奖励价值和评论家的估计问0(适用于有批评者的代理)。情节管理器还显示各种情节和培训统计信息。要关闭强化学习情节管理器,请设置情节选择trainOpts来“没有”.如果使用具有可视化的预定义环境,则可以使用

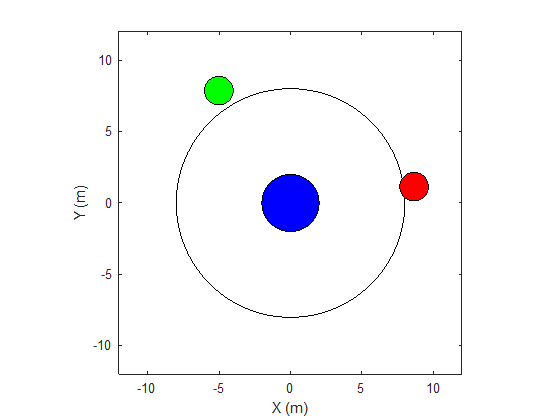

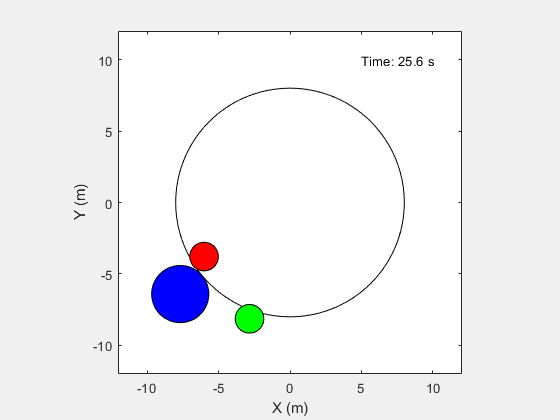

情节(env)可视化环境。如果你打电话情节(env)在训练前,然后在训练中可视化更新,让你可视化每一集的进展。(对于自定义环境,您必须实现自己的环境情节方法。)中规定的条件终止培训

trainOpts感到满意。若要终止正在进行的培训,请在“强化学习集管理器”中单击停止训练.因为火车每集更新代理,您可以通过呼叫恢复培训列车(代理人、环境、列车员)同样,在不丢失第一次调用火车.在培训期间,您可以保存满足指定条件的候选代理

trainOpts.例如,您可以保存任何集奖励超过一定值的代理,即使还未满足终止训练的总体条件。火车将保存的代理存储在指定文件夹中的MAT文件中trainOpts.保存的代理可能很有用,例如,它允许您测试在长时间运行的培训过程中生成的候选代理。保存条件和保存位置请参见RL培训选项.

算法

一般来说火车执行以下迭代步骤:

初始化

代理.每集:

重置环境。

得到最初的观察结果年代0来自环境。

计算初始动作一个0=μ(年代0).

将当前操作设置为初始操作(一个←一个0),并将当前观测值设置为初始观测值(年代←年代0).

本集尚未结束或终止:

用行动来改善环境一个以获得下一个观察年代”“报酬呢r.

从经验中学习(年代,一个,r,年代”)。

计算下一个动作一个' =μ(年代”)。

使用下一个操作更新当前操作(一个←一个'),并将当前的观测值更新为下一个观测值(年代←年代”)。

如果满足环境中定义的事件终止条件,则中断。

如果训练终止条件定义为

trainOpts如果满足,终止训练。否则,开始下一集。

具体如何操作火车执行这些计算取决于代理和环境的配置。例如,在每一集的开始重置环境可以包括随机初始状态值,如果您配置您的环境这样做。