trainingOptions

前额侧红神经元深度学习

Descripcion

选项= trainingOptions (solverName)solverName.红色的中间部分,使用中间部分的操作方法funcióntrainNetwork.

选项= trainingOptions (solverName,名称=值)

包括

特别的情话

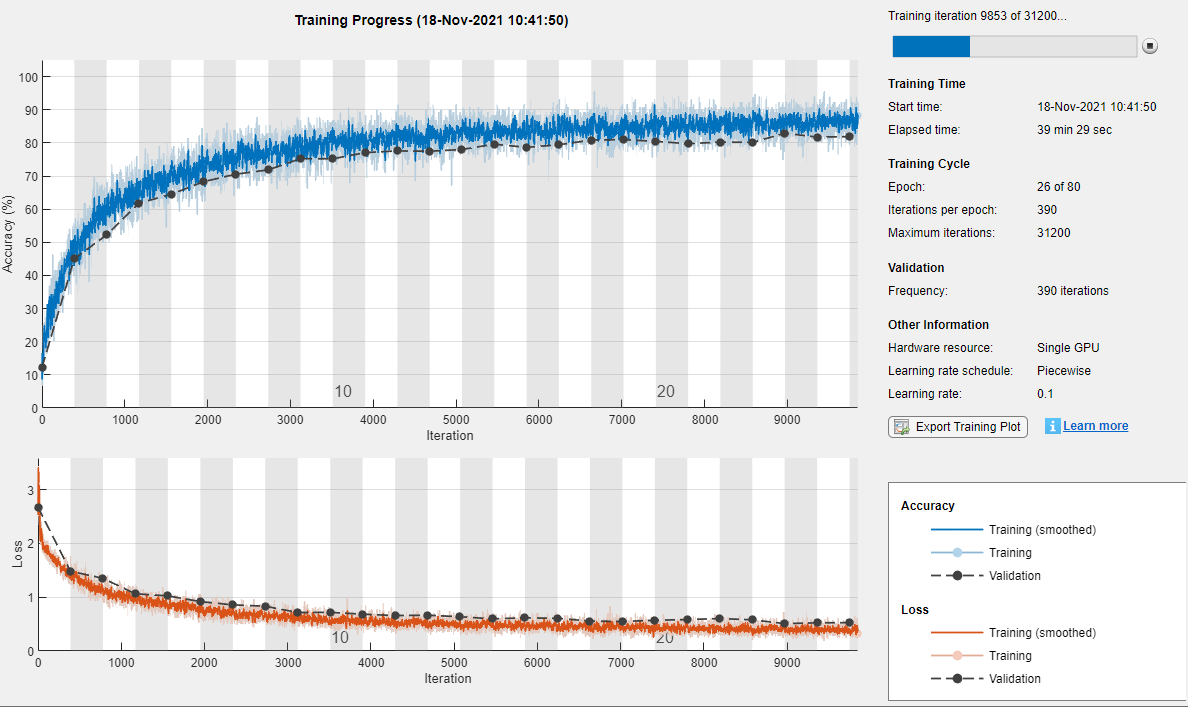

Cree un conjunto de opciones para entrenar una红色中间梯度下降estocástico现在。Reduzca la tasa de aprendizaje por un factor de 0.2 cada 5 épocas。建立联系número máximo de épocas para entrenamiento en 20 y use un minilote con 64 observaciones en cada iteración。活跃的la gráfica精神进步。

选项= trainingOptions(“个”,...LearnRateSchedule =“分段”,...LearnRateDropFactor = 0.2,...LearnRateDropPeriod = 5,...MaxEpochs = 20,...MiniBatchSize = 64,...情节=“训练进步”)

options = TrainingOptionsSGDM与属性:动量:0.9000 InitialLearnRate: 0.0100 LearnRateSchedule: 'piecewise' LearnRateDropFactor: 0.2000 LearnRateDropPeriod: 5 L2Regularization: 1.0000e-04 GradientThresholdMethod: 'l2norm' GradientThreshold: Inf MaxEpochs: 20 MiniBatchSize: 64 Verbose: 1 VerboseFrequency: 50 ValidationData: [] ValidationFrequency: 50 ValidationPatience: Inf Shuffle: 'once' CheckpointPath: " CheckpointFrequency: 1 CheckpointFrequencyUnit: "'epoch' ExecutionEnvironment: 'auto' WorkerLoad: [] OutputFcn: [] Plots: 'training-progress' SequenceLength: 'longest' SequencePaddingValue: 0 SequencePaddingDirection: 'right' DispatchInBackground: 0 ResetInputNormalization: 1 BatchNormalizationStatistics: 'population' OutputNetwork: 'last-iteration'

深度学习进程监测

Este ejemplo muestra cómo深度学习监测程序。

深度学习,suele ser útil监测技术进步。代表不同的métricas durante el proceso, puede compprobar cómo este progress。我爱你,我爱你precisión我爱你está我爱你qué我爱你está我爱你,我爱你está我爱你。

在我们的世界里有一个地方cómo在我们中间的地方有一个地方funcióntrainNetwork.这段话的意思是,这段话的意思是,这段话的意思是,这段话的意思是,这段话的意思是trainingProgressMonitor副代表métricas持久的友谊。Para obtener más información, consulte监控定制培训循环进度.

Cuando establishment la opción de entrenamiento情节在“训练进步”帕拉trainingOptions我爱你,爱你,trainNetwork造物之魂métricas心灵之心iteración。卡达iteración es una estimación del gradiente y una actualización de los parámetros de la red。Si se especifican los datos de validación entrainingOptions, la figura muestra las métricas de validación cada vez quetrainNetworkValida la red。La figura representation lo siguiente:

Precisión del entrenamiento: precisión de la clasificación en cada minilote个人。

Precisión你的内心世界: precisión你的天堂,你的天堂,你的天堂,你的天堂,你的天堂precisión你的天堂。我们的生活是美好的precisión我们的生活是美好的detección我们的发展趋势。

Precisión de validación: precisión de la clasificación en todo el conjunto de validación

trainingOptions).Pérdida恩爱之门,Pérdida你的内心世界yPérdida de validación: la pérdida en cada minilote, su versión suavizada y la pérdida en el conjunto de validación,分别。La capa final de La red es una

classificationLayer, por lo que la función de pérdida es la pérdida de entropía cruzada。Para obtener más información清醒的大脑pérdida Para los问题regresión y clasificación,咨询输出层.

En el caso de las redes de regresión, la figura el error cuadrático medio raíz (RMSE En lugar de la precisión。

La figura marca cadaEpoca与联合国的友谊相伴。Una época es Una pasada completa por el conjunto de datos。

Durante el entrenamiento, puede detenerlo和下放el estado实际de la red haciendo clic en el botón de stop de la esquina superior derecha。有一个可能的地方precisión有一个可能的地方mejorará más。那是我们的天堂botón停,那是我们的天堂podría那是我们的天堂。Una vez completado,trainNetworkDevuelve la red entrenada

和你在一起,我很高兴ResultadosQue indican la precisión de validación finalizada y la razón por la Que se ha finalizado el entrenamiento。Si la opción de entrenamientoOutputNetwork斯塔恩“最后一次迭代的”(英勇的预先决定),las métricas结束对应la última iteración de entrenamiento。Si la opción de entrenamientoOutputNetwork斯塔恩“best-validation-loss”, las métricas finalizadas对应la iteración con la pérdida de validación más baja。La iteración a partir de La cual se calculan las métricas de validación finales se etiqueta como最后En las gráficas。

Si la red contene capas de normalización de lotes, la métrica de validación最终的puede ser diente a la métrica de validación evaluada durante el entrenamiento。为了看一幅画estadísticas看一幅画estadísticas看一幅画normalización看一幅画después看一幅画完整的图画。祝你好运opción祝你好运BatchNormalizationStatisics斯塔恩“人口”, después del proceso, el software finaliza las estadísticas de normalización de lotes pasando por los datos de entramiento una vez más y利用la media和la varianza result。Si la opción de entrenamientoBatchNormalizationStatisics斯塔恩“移动”, el software proxima las estadísticas durante el entrenamiento utility zando una estimación continua y utility za los últimos valores de las estadísticas。

A la derecha, vea la información清醒的时代和调整的时代。Para obtener más información清醒的心灵连线,协商参数设置与卷积神经网络训练.

Para guardar la gráfica生命的进步出口培训地块enla ventana del entrenamiento。Puede guardar la gráfica como档案PNG, JEPG, TIFF o PDF。También puede guardar de forma个人las gráficas de pérdida, precisión y错误cuadrático medio raíz con la barra de herramientas de los ejes。

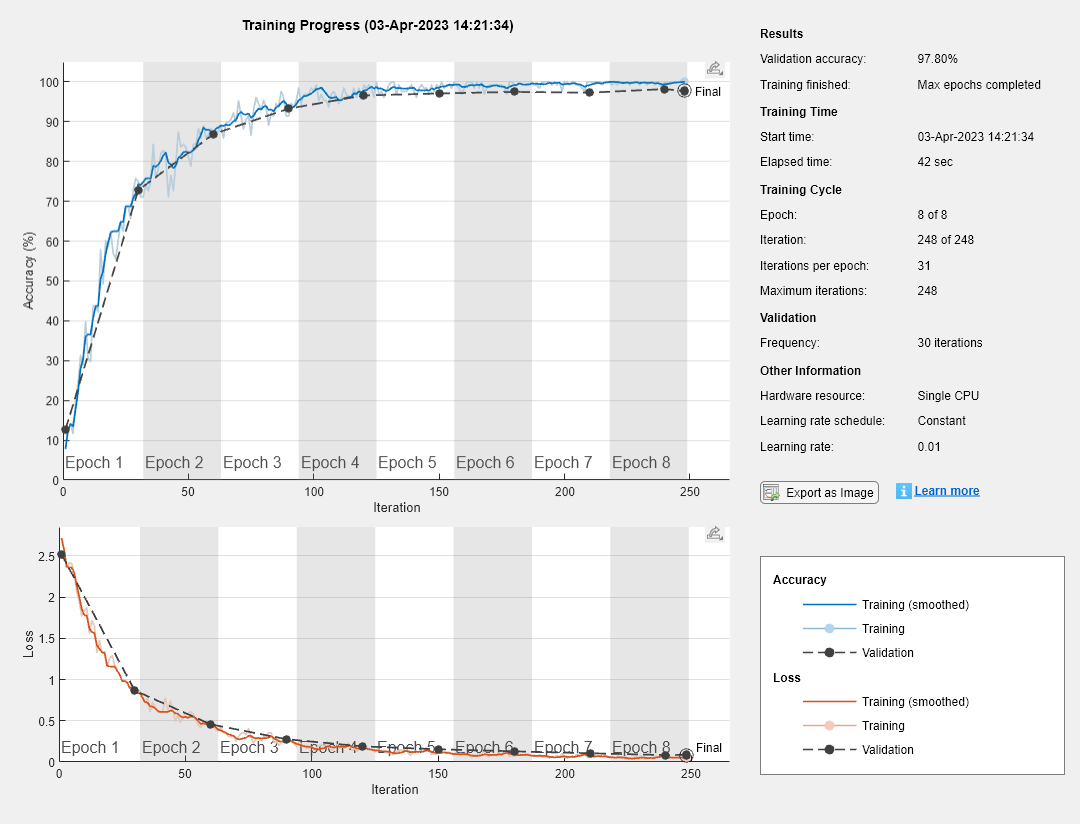

这是一种进步,一种友谊,一种误解

红色的永恒代表着永恒的进步。

欧洲的货物5000 imágenes de dígitos。储备1000 de las imágenes para la validación de la red。

[XTrain,YTrain] = digitTrain4DArrayData;idx = randperm(size(XTrain,4),1000);XValidation = XTrain(:,:,:,idx);XTrain(:,:,:,idx) = [];YValidation = YTrain(idx);YTrain(idx) = [];

蔚蓝蔚蓝蔚蓝蔚蓝蔚蓝蔚蓝蔚蓝蔚蓝蔚蓝蔚蓝蔚蓝imágenes蔚蓝蔚蓝蔚蓝蔚蓝dígitos。

图层= [imageInputLayer([28 28 1])卷积2dlayer(3,8,填充=“相同”) batchNormalizationLayer reluLayer maxPooling2dLayer(2,Stride=2) convolution2dLayer(3,16,Padding=“相同”) batchNormalizationLayer reluLayer maxPooling2dLayer(2,Stride=2) convolution2dLayer(3,32,Padding=“相同”batchNormalizationLayer reluLayer fullyConnectedLayer(10) softmaxLayer classificationLayer];

特别的行动,para el entrenamiento de la red。Para validar la red a intervalos regulares durante el entrenamiento,特别是los datos de validación。伊利亚·埃尔英勇ValidationFrequency赤手空脚的人época。在这段历史中,建立了opción历史情节在“训练进步”.

选项= trainingOptions(“个”,...MaxEpochs = 8,...ValidationData = {XValidation, YValidation},...ValidationFrequency = 30,...Verbose = false,...情节=“训练进步”);

Entrene la red。

net = trainNetwork(XTrain,YTrain,图层,选项);

entrada论证

solverName- - - - - -求解器para entrenar la red

“个”|“rmsprop”|“亚当”

解决问题,在红色的问题上,特别是在其他的问题上:

“个”: usar el optimizador de gradiente descent estocástico con momentento (SGDM)。在中间时刻的英勇opción在中间时刻的英勇动力.“rmsprop”: usar el optimizador RMSProp。Puede speciificar la tasa de decaimiento de la media móvil de gradiente cuadrado mediante la opción de entrenamientoSquaredGradientDecayFactor.“亚当”usar el optimizador亚当。Puede特别las tasas de decaimiento de la media móvil de gradiente y de gradiente cuadrado mediante las opciones de entrenamientoGradientDecayFactorySquaredGradientDecayFactor, respectivamente。

Para obtener más información sobre los different solvers, consulte梯度下降estocástico.

英勇论争

特别的论点是相互的Name1 = Value1,…,以=家,在哪里的名字这就是所谓的论点价值英勇的通讯员。英雄论después英雄论。罪恶禁运,一切都不重要。

在R2021a之前的版本中,使用另一种昏迷方式的名字澳德之间。

比如:InitialLearnRate = 0.03, L2Regularization = 0.0005, LearnRateSchedule =“分段”具体的la tasa de aprendizaje主要como 0.03 y el因子regularizaciónl2Como 0.0005 y dirige指令软件para que reduzca la tasa aprendizaje cada cierto número de épocas multiplicándola por UN determinado factor。

情节- - - - - -Gráficas红色的景象

“没有”|“训练进步”

Gráficas红色的视觉持续时间,以及与此相关的信息:

“没有”: no visualizar gráficas durante el entrenamiento。“训练进步”:国家进步代表。La gráfica muestra información清醒La pérdida y La precisión de minilotes y La pérdida y La precisión de validación, así como información adicional清醒el progreso del entrenamiento。La gráfica incluye el botón de detención En la esquina superior derecha。Haga clic el botón para detener el entramiento y devolver el estado actual de la red。守护星球gráfica地球上有一个星球出口培训地块.Para obtener más información清醒的la gráfica精神进步,协商深度学习进程监测.

En la esquina superior derecha。Haga clic el botón para detener el entramiento y devolver el estado actual de la red。守护星球gráfica地球上有一个星球出口培训地块.Para obtener más información清醒的la gráfica精神进步,协商深度学习进程监测.

详细的- - - - - -指数para mestar información庄严的进步

1(verdadero)(predeterminado) |0(falso)

最理想的指示información战士们冷静地前进,特别是战斗1(verdadero) o0(falso)。

La salida detallada muestra La siguiente información:

clasificación

| 坎波 | Descripcion |

|---|---|

时代 |

Número de épocas。Una época对应的Una pasada完成了所有的数据。 |

迭代 |

Número de iteraciones。Una iteración对应一个un miniilote。 |

时间 |

一分钟一秒地穿越时空。 |

Mini-batch准确性 |

Precisión de clasificación en el minilote。 |

验证准确性 |

Precisión de clasificación en los datos de validación。Si no especifica datos de validación, la función no muestra este campo。 |

Mini-batch损失 |

Pérdida en el minilote。我爱你,我爱你ClassificationOutputLayer, la pérdida es la pérdida de entropía cruzada para问题de clasificación de varias clases con clases mutuamente excluyentes。 |

确认损失 |

Pérdida en los datos de validación。我爱你,我爱你ClassificationOutputLayer, la pérdida es la pérdida de entropía cruzada para问题de clasificación de varias clases con clases mutuamente excluyentes。Si no especifica datos de validación, la función no muestra este campo。 |

基础学习率 |

Tasa de aprendizaje基地。软件的多重因素,在工作中,在工作中,在工作中。 |

regresión

| 坎波 | Descripcion |

|---|---|

时代 |

Número de épocas。Una época对应的Una pasada完成了所有的数据。 |

迭代 |

Número de iteraciones。Una iteración对应一个un miniilote。 |

时间 |

一分钟一秒地穿越时空。 |

Mini-batch RMSE |

错误cuadrático medio raíz (RMSE) en el minilote。 |

验证RMSE |

RMSE en los datos de validación。Si no especifica datos de validación, el software no muestra este campo。 |

Mini-batch损失 |

Pérdida en el minilote。我爱你,我爱你RegressionOutputLayer, la pérdida es el error cuadrático medio didido。 |

确认损失 |

Pérdida en los datos de validación。我爱你,我爱你RegressionOutputLayer, la pérdida es el error cuadrático medio didido。Si no especifica datos de validación, el software no muestra este campo。 |

基础学习率 |

Tasa de aprendizaje基地。软件的多重因素,在工作中,在工作中,在工作中。 |

我们的爱人,我们的爱人razón我们detención。

Para especificdatos de validación,使用la opción de entrenamientoValidationData.

数据提示:单|双|int8|int16|int32|int64|uint8|uint16|uint32|uint64|逻辑

VerboseFrequency- - - - - -Frecuencia de impresión detallada

50(predeterminado) |entero positivo

我们在一起impresión我们在一起,我们在一起número我们在一起impresión我们在一起,我们在一起。Esta opción tiene efecto cuando la opción de entrenamiento详细的西文1(verdadero)。

我的爱人,我的爱人,trainNetworkTambién突击队员们的英勇行动validación。

数据提示:单|双|int8|int16|int32|int64|uint8|uint16|uint32|uint64

MaxEpochs- - - - - -Número máximo de épocas

30.(predeterminado) |entero positivo

Número máximo de épocas在我们的生活中,我们的生活是美好的,我们的生活是美好的。

Una iteración es un paso dado en el algoritmo递减梯度para minimizar la función de pérdida mediante un minimote。Una época es ena pasada complete del algoriitmo de enrenamiento and lo largo de todo el conjunto de enrenamiento。

数据提示:单|双|int8|int16|int32|int64|uint8|uint16|uint32|uint64

MiniBatchSize- - - - - -Tamaño de minilote de

128(predeterminado) |entero positivo

Tamaño我们的生命尽头iteración我们的生命尽头iteración我们的生命尽头。一个小的,次的,联接的,联接的,联接的,联接的,联接的,联接的,联接的,联接的,联接的,联接的,联接的,联接的,联接的,联接的,联接的,联接的,联接的,联接的,联接的,联接的,联接的,联接的,联接的,联接的,联接的,联接的,联接的,联接的,联接的,联接的,联接的;

Si el tamaño de miniilote no divide el número de meestras de entrenamiento de manera uniform,trainNetworkDescarta los datos de entrenamiento que no caben en el miniilote最终完成的cada época。

数据提示:单|双|int8|int16|int32|int64|uint8|uint16|uint32|uint64

洗牌- - - - - -Opción para cambiar el orden de los datos

“一次”|“永远”|“every-epoch”

Opción关于数据秩序的问题,关于操作秩序的问题:

“一次”:庄严的仪式和validación庄严的仪式。“永远”:没有cambiar el orden de los datos。“every-epoch”: cambiar el orden de de entrenamiento antes de cada época de entrenamiento y cambiar el orden de los datos de validación antes de cada validación de la red。Si el tamaño de miniilote no divide el número de meestras de entrenamiento de manera uniform,trainNetworkDescarta los datos de entrenamiento que no caben en el miniilote最终完成的cada época。Para evitar descartar los mismos datos cada época,建立la opción de entrenamiento洗牌在“every-epoch”.

ValidationData- - - - - -关于我们的世界的资料validación永恒的永恒

[](predeterminado) |Almacén de datos|手鼓|Arreglo de celdas

关于我们的生活validación我们的生活,特别是我们的生活[],联合国almacén关于数据,联合国关于世界范围内的预测和反应的手记validación。

Puede特定预测y respuestas de validación mediante los mismos formatos compatibles con la funcióntrainNetwork.Puede speciificla datos de validación como un almacén de datos, una tabla o el arreglo de celdas}{预测,反应,在哪里预测连续性预测validación y反应世界末日validación。

Para obtener más información, consulte los argumentos de entrada图片,序列y特性德拉funcióntrainNetwork.

Durante el entrenamiento,trainNetwork计算器la precisión de validación y la pérdida de validación en los datos de validación。Para especificar la frecuencia de validación,使用la opción de entrenamientoValidationFrequency.También我们要用的东西validación我们要用的东西automáticamente我们要用的东西pérdida validación我们要用的东西。Para activar la detención automática de la validación,使用la opción de entrenamientoValidationPatience.

Si su red tiene capas que se comportan de forma不同的durante la predicción y durante el entrenamiento (por ejemplo, capas de abandono), la precisión de validación puede ser mayor que la precisión de entrenamiento (miniilote)。

Los datos de validación se cambian de orden de acerdo con la opción de entrenamiento洗牌.如果洗牌西文“every-epoch”, los datos de validación se cambian de orden antes de cada validación de la red。

如果ValidationData西文[], el软件没有有效的一个红色的杜兰特el根深蒂固。

ValidationFrequency- - - - - -frrecuencia de la validación de la red

50(predeterminado) |entero positivo

validación la la red en número de iteraciones, especificada como un entero positive。

El英勇ValidationFrequencyEs el número de iteraciones entre evaluaciones de métricas de validación。Para especificdatos de validación,使用la opción de entrenamientoValidationData.

数据提示:单|双|int8|int16|int32|int64|uint8|uint16|uint32|uint64

ValidationPatience- - - - - -太平洋detención德拉validación

正(predeterminado) |entero positivo

拉丁太平洋detención拉丁太平洋validación红色的光环,正进入我们的生活正.

ValidationPatience特别问候número在教堂里的事pérdida在教堂里的人validación在教堂里的人是市长pérdida在教堂里的人是红色的人。如果ValidationPatience西文正, la valores pérdida de validación没有一个教务长,他的权利和时间。

La red devuelta dependent de La opción de entrenamientoOutputNetwork.Para devolver la red con la menor pérdida de validación, establezca la opción de entrenamientoOutputNetwork在“best-validation-loss”.

数据提示:单|双|int8|int16|int32|int64|uint8|uint16|uint32|uint64

OutputNetwork- - - - - -红色的,红色的,红色的,红色的,红色的,红色的

最后一次迭代的(predeterminado) |“best-validation-loss”

红色的,红色的,红色的,红色的,红色的,红色的,红色的,红色的,红色的,红色的

最后一次迭代的: devuelve la red通讯员a la última iteración de entrenamiento。“best-validation-loss”: devuelve la red通讯员a la iteración de entrenamiento con la menor pérdida de validación。Para usar esta opción debe especificar la opción de entrenamientoValidationData.

InitialLearnRate- - - - - -Tasa de aprendizaje inicial

escalar positivo

这是我的工作,我的工作,我的工作。

英勇的先兆0.01分段求解器“个”y0.001Para los求解器“rmsprop”y“亚当”.

我爱你,我爱你,我爱你,我爱你。看你的眼睛,你的眼睛podría你的眼睛subóptimo你的眼睛。

数据提示:单|双|int8|int16|int32|int64|uint8|uint16|uint32|uint64

LearnRateSchedule- - - - - -Opción para reducir la tasa de prendizaje durante el entrenamento

“没有”(predeterminado) |“分段”

Opción对这一问题的解释,对这一问题的解释:

“没有”:我的爱人,我的爱人,我的爱人,我的爱人。“分段”: el软件actualiza la tasa de aprendizaje cada cierto número de épocas multiplicándola por UN determinado factor。使用la opción de entrenamientoLearnRateDropFactor特别英勇因素。使用la opción de entrenamientoLearnRateDropPeriodPara especificar el número de épocas entre multiplicaciones。

LearnRateDropPeriod- - - - - -Número de épocas para reducir la tasa de aprendizaje

10(predeterminado) |entero positivo

Número de épocas para reducir la tasa de prendizaje, especificado como un entero positive。Esta opción es válida solo cuando la opción de entrenamientoLearnRateSchedule西文“分段”.

El software multiplica la tasa de aprendizaje全球por El factor de reducción cada vez que pasa El número de épocas especificado。特别的因素reducción中间的la opción的恩爱LearnRateDropFactor.

数据提示:单|双|int8|int16|int32|int64|uint8|uint16|uint32|uint64

LearnRateDropFactor- - - - - -还原因子

0.1(predeterminado) |escalar德0一个1

这是一种特殊的影响因素0一个1.Esta opción es válida solo cuando la opción de entrenamientoLearnRateSchedule西文“分段”.

LearnRateDropFactorEs UN因子乘法para applicicar a tasa aprendizaje cada vez que pasa UN determinado número de épocas。特别是el número de épocas mediante la opción de entrenamientoLearnRateDropPeriod.

数据提示:单|双|int8|int16|int32|int64|uint8|uint16|uint32|uint64

L2Regularization- - - - - -因子regularización L2

0.0001(predeterminado) |Escalar没有否定

因子regularización L2(decaimiento de peso),特别是联合国没有否定的理由。Para obtener más información, consulteRegularizacion L2.

Puede speciificar un multiplicador para la regularización L2Para capas de red con parámetros que se pueden aprender。Para obtener más información, consulte在卷积层和全连接层中设置参数.

数据提示:单|双|int8|int16|int32|int64|uint8|uint16|uint32|uint64

动力- - - - - -Contribución del paso previo

0.9(predeterminado) |escalar德0一个1

Contribución del paso de actualización de parámetros de la iteración previa ala iteración实际的下降梯度estocástico con memento, especificada como un escalar de0一个1.

勇敢的0美好的日子contribución上帝保佑我们,我们是勇敢的1Indica una contribución máxima desde el paso previo。英勇的预先决定的功能,在mayoría的人。

Para especificar la opción de entrenamiento动力,solverName应“个”.

Para obtener más información, consulte梯度下降estocástico过失.

数据提示:单|双|int8|int16|int32|int64|uint8|uint16|uint32|uint64

GradientDecayFactor- - - - - -Tasa de decaimiento de la media móvil梯度

0.9(predeterminado) |没有人能否定我1

媒体之荣耀móvil解决亚当问题的梯度,没有任何否定的理由1.La tasa de decaimiento del gradiente está denotada porβ1恩拉sección亚当.

Para especificar la opción de entrenamientoGradientDecayFactor,solverName应“亚当”.

英勇的预先决定的功能,在mayoría的人。

Para obtener más información, consulte亚当.

数据提示:单|双|int8|int16|int32|int64|uint8|uint16|uint32|uint64

SquaredGradientDecayFactor- - - - - -媒体之爱móvil夸德拉多

没有人能否定我1

媒体之事móvil解决问题的梯度,亚当和RMSProp,特别的,没有否定的问题1.十变十变的梯度estáβ2在[4].

Para especificar la opción de entrenamientoSquaredGradientDecayFactor,solverName应“亚当”o“rmsprop”.

瓦洛雷斯típicos de la tasa de decaimiento儿子0.9,0.99y0.999, que对应着经度媒体10,One hundred.y1000Actualizaciones de parámetros,分别。

英勇的先兆0.999para解算者亚当。英勇的先兆0.9参数求解器RMSProp。

Para obtener más información, consulte亚当yRMSProp.

数据提示:单|双|int8|int16|int32|int64|uint8|uint16|uint32|uint64

ε- - - - - -Desplazamiento del denominador

1 e-8(predeterminado) |escalar positivo

亚当和RMSProp,特殊情况下,有肯定的结果。

方程解算者añade方程解算者和方程解算者parámetros红色方程解算者división cero。英勇的预先决定的功能,在mayoría的人。

Para especificar la opción de entrenamientoε,solverName应“亚当”o“rmsprop”.

Para obtener más información, consulte亚当yRMSProp.

数据提示:单|双|int8|int16|int32|int64|uint8|uint16|uint32|uint64

ResetInputNormalization- - - - - -Opción para resablecer la normalización de la capa de entrada

1(verdadero)(predeterminado) |0(falso)

Opción para relablecer la normalización de la capa de entrada, especificada como una de las sigientes opciones:

1(verdadero):重新计算的las estadísticas de normalización de la capa de entrada和realcularlas en el menento del entramiento。0(falso):计算器estadísticas de normalización en el momento del entrenamiento cuando están vacías。

数据提示:单|双|int8|int16|int32|int64|uint8|uint16|uint32|uint64|逻辑

BatchNormalizationStatistics- - - - - -Modo para evaluar estadísticas en capas de normalización de lotes

“人口”(predeterminado) |“移动”

Modo para evaluate estadísticas en capas de normalización de lotes, especificado como de las siguentes opciones:

“人口”: usar las estadísticas de población。Después连线,软件的最后一段estadísticas pasando por los datos de entrenamiento una vez más利用媒体和变化的结果。“移动”:近las estadísticas durante el entrenamiento utizando una estimación连续的danada por pasos de actualización在哪里 y 媒体和现实的差异,分别, y 关于媒体的价值和变化, y 在媒体上,在不同的地方,在不同的地方,在不同的地方 y 我们的价值观más我们的媒体价值观和差异móviles,各自的价值观。Después del entrenamiento, el software usa el valor más iliente de las estadísticas de media y varianza móviles。Esta opción solo es兼容con CPU y GPU única。

GradientThreshold- - - - - -本影梯度

正(predeterminado) |escalar positivo

本影下降,特别是como正哦,联合国的积极行动。硅梯度超英勇GradientThreshold, este se recorta de acerdo con la opción de entrenamientoGradientThresholdMethod.

Para obtener más información, consulte记录坡度.

数据提示:单|双|int8|int16|int32|int64|uint8|uint16|uint32|uint64

GradientThresholdMethod- - - - - -Método本影梯度

“l2norm”(predeterminado) |“global-l2norm”|“绝对值”

Método关于本影梯度的使用,关于本影梯度的价值,关于本影梯度的计算,关于本影梯度的计算:

“l2norm”: si la norma L2联合国的梯度parámetro这是一个市长GradientThreshold这是常态的梯度2海鬣蜥GradientThreshold.“global-l2norm”: si la norma L2全球性的,l——邱市长GradientThreshold联合国因素的梯度GradientThreshold /l.常态2全球考虑parámetros que se pueden aprender。“绝对值”:绝对的权利,特殊的个人,联合国的梯度parámetro我们的权利,我们的市长GradientThreshold,衍生的特殊的对偶的巨大的额角aGradientThreshold这是一个特殊的信号。

Para obtener más información, consulte记录坡度.

SequenceLength- - - - - -Opción对流层安全壳

“最长”(predeterminado) |“最短”|entero positivo

Opción对流层,卫星和卫星之间的安全分区,卫星和卫星之间的联系:

“最长”:安全之树在树下的微小的对位的安全之树纵向的安全之树más larga。Esta opción no descarta ningún dato, aunque el relleno puede介绍ruido a la red。“最短”:安全的树干,在上面,在下面,在上面,在下面,在下面,在下面,más corta。Esta opción garantiza que no se añade relleno, descartar datos海岸。正确的回答:para cada minilote, rellenar las secuencia hasta múltiplo más cercano a la longitude detail detail, después, dividir las secuencias en secuencias más pequeñas de la longitude detail detail。Si se生产la división, el软件crea minilotes adicionales。使用esta opción是安全完整的没有记忆的小屋。Como alternative,意图还原número de secuencias por miniilote ajustando la opción

MiniBatchSize一个联合国的勇士。

Para obtener más información清醒的头脑,清醒的头脑división安全的头脑,领事Relleno, truncamiento y división de secuencias.

数据提示:单|双|int8|int16|int32|int64|uint8|uint16|uint32|uint64|字符|字符串

SequencePaddingDirection- - - - - -Dirección de relleno truncado

“正确”(predeterminado) |“左”

Dirección关于贸易的回忆,关于贸易的回忆:

“正确”:雷勒纳尔o truncar secuencias la derecha。我们的安全在我们的世界里,在我们的时间里,在我们的软件中añade我们最后的安全。“左”:一种叫做“水草”的树。El software trunca o añade关于安全的最后一个原则,关于安全的最后一个原则,关于时间的错误。

这是一个反复发生的事件,在一个安全的时刻,在一个和平的时刻,在一个和平的时刻OutputMode德拉卡帕递归“最后一次”,最后一段时间的最后一段时间的最后一段时间的最后一段时间的最后一段时间。Para rellenar o truncar datos secuenciales a la izquierda,建立la opciónSequencePaddingDirection在“左”.

平安之家平安之家平安之家OutputMode西文“序列”重复的问题),在前一段时间内的初始问题,在前一段时间内的预测问题。关于安全数据的记录,建立opciónSequencePaddingDirection在“正确”.

Para obtener más información清醒的头脑,清醒的头脑división安全的头脑,领事Relleno, truncamiento y división de secuencias.

SequencePaddingValue- - - - - -英勇para rellenar secuencias

0(predeterminado) |escalar

英勇,在过去的安全中,特别的,在未来的生命中。

La opción solo es válida cuandoSequenceLength西文“最长”O UN entero positivo。没有rellene secuencias con南, porque haciéndolo se pueden传播错误por la red。

数据提示:单|双|int8|int16|int32|int64|uint8|uint16|uint32|uint64

ExecutionEnvironment- - - - - -递归的硬件对中心红色

“汽车”|“cpu”|“图形”|“multi-gpu”|“平行”

硬件中红的递归,特别是在操作过程中遇到的问题:

“汽车”: usar una GPU si hay alguna disponible。不是,是CPU。“cpu”: usar la CPU。“图形”: usar la GPU。“multi-gpu”: usar varias GPU en una máquina, usando un grupo parallelo local basado en su perfil de cluster predeterminado。Si no hay grupo parallelo actual, el software inicia un grupo parallelo con un tamaño de grupo idéntico al número de GPU disponibles。“平行”: usar UN grupo parallelo local o remoto basado en su perfil de cluster predeterminado。没有干草组平行实际,没有软件,没有中间,没有簇预确定。Si el grupo tiene acceso a varias GPU, solo workers con una GPU única realizan el cálculo de entrenamiento。我是GPU的一个变种,是CPU的一个变种,是CPU的一个变种。

Para obtener más información清醒cuándo使用不同的entornos de ejecución,咨询并行、gpu和云中扩展深度学习.

各种选择“图形”,“multi-gpu”y“平行”并行计算工具箱™。Para utilzar una GPU Para深度学习,debe también disponer de un dispositivo GPU兼容。Para obtener información清醒的性格,协商GPU计算要求(并行计算工具箱).Si elige una de estas opciones y并行计算工具箱una GPU adecuada no está disponible, el软件开发无错误。

在这条道路上,在这条道路上,在这条道路上,在这条道路上,在这条道路上MiniBatchSizeeInitialLearnRatezh función del número las GPU。

各种选择“multi-gpu”y“平行”无子可兼容,可为世界上最人性化的权利parámetros在世界上最完整的权利,可为世界上最永恒的权利。比如:

Capas递归como对象

LSTMLayer,BiLSTMLayeroGRULayerCuando la opción entrenamientoSequenceLengthEs UN entero positiveObjetos

BatchNormalizationLayerCuando la opción entrenamientoBatchNormalizationStatisticsEstá establecida en“移动”

WorkerLoad- - - - - -División de carga de workers parallelos

escalar德0一个1|entero positivo|向量numerico

División在GPU和CPU方面的工作人员,特别是在操作方面的工作人员:

Escalar德

0一个1: fracción工人在路上máquina para usar para el cálculo de entrenamiento de red。Si entrena la red usando datos de un almacén de datos de minilotes con distribución在第二工作计划中,工人们在第二工作计划中保留buscan和pre - processing datos。积极的精神:número工人们的工作máquina para usar para el cálculo红色的精神。Si entrena la red usando datos de un almacén de datos de minilotes con distribución在第二工作计划中,工人们在第二工作计划中保留buscan和pre - processing datos。

向量numérico: carga de entrenamiento de red para cada worker del group parallelo。Para un向量

W埃尔·沃克我Recibe una fracciónW(我)/ (W)和Del trabajo (número de ejemployers por minilote)。Si entrena una red usando datos de un almacén de datos de miniotes con distribución en en gundo plano activada, puede asignar una carga de worker de 0 para usar ese worker para buscar datos en en gundo plano。在平行团队中,工作人员无法得到特殊待遇。

Si el grupo para elo tiene acceso a las GPU, los workers sin una GPU única没有se utilizan nunca para el cálculo de entrenamiento。La opción预先决定para grupos con varias GPU es usar todos los workers con una GPU única para el cálculo de entrenamiento y los workers restantes para La distribución en segundo plano。Si el grupo no tiene acceso a varias GPU y a varias CPU usadas para el entrenamiento, la opción predeterminada consistenusar un worker por máquina para la distribución de datos en segundo plano。

数据提示:单|双|int8|int16|int32|int64|uint8|uint16|uint32|uint64

DispatchInBackground- - - - - -指示器para habilitar la distribución在第二平面上

0(falso)(predeterminado) |1(verdadero)

指示符para habilitar la distribución第二平面图(cola de precarga asíncrona) para leer datos de entrenamiento de almacene de datos, especificado como0(falso) o1(verdadero)。La distribución en segundo plano requiere并行计算工具箱。

DispatchInBackground单独相容,数据可分,参与者可分。Para obtener más información, consulte使用数据存储进行并行训练和后台调度.

数据提示:单|双|int8|int16|int32|int64|uint8|uint16|uint32|uint64

CheckpointPath- - - - - -管制之路,守卫之路

""(predeterminado) |caracteres向量

管制之路,管制之路,管制之路,管制之路。

Si no especifica una ruta (es decir, Si usa la opción predeterminada

""), el software no guarda ninguna red de puntos de control。Si especifica una ruta,

trainNetwork守卫在控制的道路上,联合国的名字único红色的。Después,赤色cargar cualquier红赤色control y retomar el entrenamiento赤色esa红。没有地毯,deberá crearla antes de speciificar la ruta para guardar las redes de puntos de control。没有什么特别的存在,

trainingOptions谴责联合国的错误。

各种选择CheckpointFrequencyyCheckpointFrequencyUnit特别是关于保护和控制的问题。

Para obtener más información清醒cómo guardar puntos de control de redes, consulte保存检查点网络并恢复培训.

数据提示:字符|字符串

CheckpointFrequency- - - - - -保护的权利和控制的权利

1(predeterminado) |entero positivo

我有权利保护你,我有权利保护你。

如果CheckpointFrequencyUnit西文“时代”, el software guarda las redes de puntos de control cadaCheckpointFrequencyepoca。

如果CheckpointFrequencyUnit西文“迭代”, el software guarda las redes de puntos de control cadaCheckpointFrequencyiteraciones。

Esta opción tiene efecto cuandoCheckpointPath没有está vacío。

数据提示:单|双|int8|int16|int32|int64|uint8|uint16|uint32|uint64

CheckpointFrequencyUnit- - - - - -控制的自由联盟

“时代”(predeterminado) |“迭代”

自由的自由,自由的统一“时代”o“迭代”.

如果CheckpointFrequencyUnit西文“时代”, el software guarda las redes de puntos de control cadaCheckpointFrequencyepoca。

如果CheckpointFrequencyUnit西文“迭代”, el software guarda las redes de puntos de control cadaCheckpointFrequencyiteraciones。

Esta opción tiene efecto cuandoCheckpointPath没有está vacío。

OutputFcn- - - - - -salida

Identificador de función|Arreglo de celdas de identificadores función

有一种特殊的方法,可以找到función有一种方法,可以找到función。trainNetwork美洲驼,一种特殊的动物,después卡达iteración一种特殊的动物,一种特殊的动物,después卡达iteracióntrainNetwork连续性的重建之路información在我们的校园里:

| 坎波 | Descripcion |

|---|---|

时代 |

Número de época实际 |

迭代 |

Número de iteración实际 |

TimeSinceStart |

时光在第二秒的时候,在刻骨铭心的时候 |

TrainingLoss |

Pérdida实际de minilotes |

ValidationLoss |

Pérdida en los datos de validación |

BaseLearnRate |

Tasa de aprendizaje基地 |

TrainingAccuracy |

Precisión en el minilote actual (redes de clasificación) |

TrainingRMSE |

RMSE en el minilote actual(参阅regresión) |

ValidationAccuracy |

Precisión en los datos de validación (redes de clasificación) |

ValidationRMSE |

RMSE en los datos de validación (redes de regresión) |

状态 |

真正的友谊,不可能的勇气“开始”,“迭代”o“完成”. |

有一个地方没有计算没有相关的方法,有一个决定的方法,有一个连续的方法vacío。

关于保护儿童和儿童的权利información关于保护儿童和儿童的权利的进步。Para deenenamiento antes de tiempo, haga que su función de salida deuelva1(verdadero)。Si cualquier función salida devuelve1(verdadero),最后的结局trainNetworkdeuelve la red más reciente。Para ver un ejemplo de cómo salida使用功能,咨询深度学习网络训练中的自定义输出.

数据提示:function_handle|细胞

salida的论证

选项-移情移情

TrainingOptionsSGDM|TrainingOptionsRMSProp|TrainingOptionsADAM

与你同在,与你同在TrainingOptionsSGDM,TrainingOptionsRMSPropoTrainingOptionsADAM.在中间有一个红色的神经元,使用在中间有一个对应的参数funcióntrainNetwork.

如果solverName西文“个”,“rmsprop”o“亚当”,联合国决议决议TrainingOptionsSGDM,TrainingOptionsRMSPropoTrainingOptionsADAM, respectivamente。

为我们争取自由opción为了我们的目标TrainingOptionsSGDM,TrainingOptionsADAMyTrainingOptionsRMSProp.Por ejemplo, para形成层el tamaño de miniilote después de usar la funcióntrainingOptions, puede editar la丙爸MiniBatchSizedirectamente:

options = trainingOptions('sgdm');选项。MiniBatchSize = 64;

Sugerencias

在深度学习的过程中,有一段时间,有一段时间,有一段时间。Para ver un ejemplo de cómo usar la transferencia del aprendizaje Para volver a entrar una red神经元convolucional Para category un nuevo conjunto de imágenes, consulteEntrenar redes de深度学习para classification nuevas imágenes.Como alternativa, puede crear y entrenar redes desde cero usando objects

layerGraph恶作剧trainNetworkytrainingOptions.Si la función

trainingOptions没有一定比例的权利和权利,没有必要的权利和权利,没有必要的权利和权利diferenciación automática。Para obtener más información, consulte为自定义训练循环定义深度学习网络.

Algoritmos

Pesos y sesgos iniciales

Para capas convolucionales y total concontades, la inicialización Para los pesos y los sesgos se indica mediante las丙酸WeightsInitializeryBiasInitializer说到做到。Para ver ejemplode cómo cambiar la inicialización Para los pesos y los sesgos, consulte在卷积层中指定初始权值和偏差y在全连接层中指定初始权值和偏差.

梯度下降estocástico

El algoritmo de gradiente descent estándar actualiza los parámetros de red (pesos y sesgos) para minimizar la función de pérdida realizando pequeños pasos en cada iteración en la dirección del gradiente negativo de la pérdida,

在哪里 Es el número de iteración, 爱你的爱人, Es el向量de parámetros y Es la función de pérdida。遗传梯度算法estándar,遗传梯度función pérdida, , se evalúa利用todo todo el连词de entrenamiento y el算法de gradiente descent estándar USA todo el连词de datos al mismo timempo。

cambio, En cada iteración退化算法estocasticoEvalúa现实的梯度parámetros中间的联合国执行任务的数据。En cada iteración se usa un subconjunto diferente, llamado miniilote。一个完整的门廊,一个完整的算法,一个完整的门,一个完整的门,一个完整的门epoca.El gradiente descent estocástico es estocástico porque las actualizaciones de parámetros calculadas usando un minilote son una estimación con ruido de la actualización de parámetros que resultaría de usar El conjunto de datos completo。Puede speciificel tamaño de miniilote y el número máximo de épocas中间的las opciones de entrenamientoMiniBatchSizeyMaxEpochs, respectivamente。

梯度下降estocástico过失

退化算法estocástico退化之路más英勇之声óptimo。Añadir un término回忆往事actualización de parámetros回忆往事oscilación[2].La actualización de gradiente descent estocástico con momentento (SGDM) es

在哪里

确定性la contribución del paso de gradiente previo a la iteración实际。Puede, speciente este valor mediante la opción de entrenamiento动力.对前额una红神经元中间算法退化梯度estocástico con momentento,特别“个”Como el primer argument to de entrada paratrainingOptions.Para Para el valor inicial de la tasa de aprendizaje α,使用la opción de entrenamientoInitialLearnRate.También puede speciificar tasas de aprendizaje different para distas capas y parámetros。Para obtener más información, consulte在卷积层和全连接层中设置参数.

RMSProp

衰落的梯度estocástico我们的时刻única我们的命运之路parámetros。Otros算法de optimización buscan mejorar el entrenamiento de red usando tasas de aprendiadien según el parámetro y pueden adaptarse automáticamente a la función de pérdida que se optimiza。RMSProp (propagación del valor cuadrático medio) es uno de estos algoritmos。Mantiene una media móvil de los cuadrados a nivel de element de los gradients de parámetros,

β2媒体的生活móvil。0,9, 0,99 y, 0999。拉美通讯员,经度,媒体,洛杉矶,梯度,瓜拉多斯之子1 /(1 -β2), es decir, 10, 100 y 1000 actualizaciones de parámetros,分别。喝水可以especificarβ2Mediante la opción de entrenamientoSquaredGradientDecayFactor.El algoritmo RMSProp实用工具esta媒体móvil para normalizar las actualizaciones de cada parámetro个人,

Donde la división se realiza a nivel de elemento。利用RMSProp se减少形式上的效果,las, aprendizajes, parámetros,大的增量las, aprendizes, parámetros, congradies, pequeños。ɛ永恒的天堂pequeña añadida para evitar la división entre cero。喝水可以especificarɛMediante la opción de entrenamientoε我的勇气已经决定了,正常的功能在我身边。特别的,左脑髓旁红神经元“rmsprop”开头和中间的动作trainingOptions.

亚当

亚当(派生自Estimación de momento adaptativo)[4]usa una actualización de parámetros que es类似RMSProp, pero con un término de momento añadido。Mantiene una media móvil a nivel de elements tanto de los gradiments parámetros

Puede,特别是las tasas de decaimientoβ1yβ2中间的连线GradientDecayFactorySquaredGradientDecayFactor, respectivamente。亚当usa las medias móviles para actualizar los parámetros de red como

Si los gradient a lo largo de varias iteraciones son similares, usage una media móvil del gradiente permite a las actualizizones de parámetros coger冲量的决定dimensión。我们的文化梯度,媒体móvil我们的文化梯度下降,我们的文化实现方式parámetros también我们的文化下降。喝水可以especificarɛMediante la opción de entrenamientoε.我有一个英勇的决定,我有一个正常的功能,我有一个伟大的功能。尤指红神经元腹侧,亚当腹侧“亚当”开头和中间的动作trainingOptions.La actualización完整的亚当包括también un机制para corregir un sesgo que aparece al原则del entrenamiento。Para obtener más información, consulte[4].

特别是la tasa de aprendizajeαPara todo los algoriitmos de optimización mediante la opción de entrenamientoInitialLearnRate.El efecto de la tasas de aprendizaje不同的para los distintos算法optimización, de modo que las tasas de aprendizaje también son distinas en general。También puede speciificar tasas de aprendizaje different según las capas y los parámetros。Para obtener más información, consulte在卷积层和全连接层中设置参数.

记录坡度

是指数级的梯度,是不可稳定的,是不稳定的。Esta "explosión在梯度的地方,在中间的地方pérdida在中间的地方南o正.关于天国的梯度记录explosión关于建立天国的梯度和天国的领主的梯度atípicos[3].赤潮白土梯度记录más rápidamente赤潮正常无影响precisión赤潮无影响。

Hay dos tipos de recorte de gradiente。

关于梯度的记录,在正常的环境下,在基础上的梯度,在没有阴影的情况下dirección梯度。洛杉矶英勇

“l2norm”y“global-l2norm”德GradientThresholdMethod儿子métodos de recorte de gradiente basados en normas。从价值上看,我们可以从价值上看,我们可以从价值上看,我们可以从价值上看,我们可以从价值上看,我们可以从价值上看,我们可以从价值上看,我们可以从价值上看。在我们的生命中,我们的生命是不存在的,我们的生命是足够的pequeños我们的生命是不存在的。El英勇

“绝对值”德GradientThresholdMethodEs UN método de recorte de gradiente basado en valores。

Regularizacion L2

Añadir un término de regularización para los pesos a la función de pérdida 这是一种形式的退化[1],[2].El término de regularización también se美洲驼十美元比索.La función de pérdida con el término de regularización toma La forma

在哪里 Es el向量de比索, Es el factor de regularización(系数)y la función de regularización 西文

Tenga en cuenta que los sesgos no están regularizados[2].Puede特定的el因子regularización

Mediante la opción de entrenamientoL2Regularization.También puede特定的因素regularización不同的para distintas capas y parámetros。Para obtener más información, consulte在卷积层和全连接层中设置参数.

La función de pérdida que el software utilization para el entrenamiento de red包括el término de regularización。没有任何障碍,英勇的pérdida最勇敢的战士们的行动和行动gráfica在前进的途中和个人的行动pérdida在没有数据的情况下término regularización。

Referencias

[1]毕晓普c.m.模式识别与机器学习.施普林格,纽约,纽约,2006。

[2]墨菲,k.p.。机器学习:一个概率的视角.麻省理工学院出版社,剑桥,马萨诸塞州,2012年。

[3]帕斯卡努,R., T.米科洛夫,Y.本吉奥。"关于训练循环神经网络的难度"第30届机器学习国际会议论文集.Vol. 28(3), 2013, pp. 1310-1318。

[4]金玛,迪德里克和吉米巴。《亚当:随机优化方法》arXiv预打印arXiv:1412.6980(2014)。

历史版本

介绍en R2016aR2018b:英勇的先驱者opción恩爱者ValidationPatience西文正

A partir de la versión R2018b, el valor predeterminado de la opción de entrenamientoValidationPatience西文正, lo que significance que la detención automática mediante validación está desactivada。这是我们的行动,我们的行动,我们的行动,我们的行动,我们的行动。

前世今生,英雄先兆5.Para reproduction este comportamiento,建立la opciónValidationPatience在5.

R2018b:档案管理权限的差异

A partir de la versión R2018b,保卫权利的权利,软件的权利,档案的权利net_checkpoint_.在前面的版本中,软件是档案的名字convnet_checkpoint_.

Si tiene código que guarda y carga redes de puntos de control, actualice su código para cargar archivos con el nuevo nombre。

Abrir比如

Tiene una versión modificada de este ejemplo。¿Desea abrir este ejemplo con sus modificaciones?

MATLAB突击队

Ha hecho clic en unenlace que对应一个este commando de MATLAB:

弹射突击队introduciéndolo en la ventana de commandos de MATLAB。Los navegadores web no permission comandos de MATLAB。

您也可以从以下列表中选择一个网站:

如何获得最佳的网站性能

选择中国站点(中文或英文)以获得最佳站点性能。其他MathWorks国家站点没有针对您所在位置的访问进行优化。