detectSpeech

语法

描述

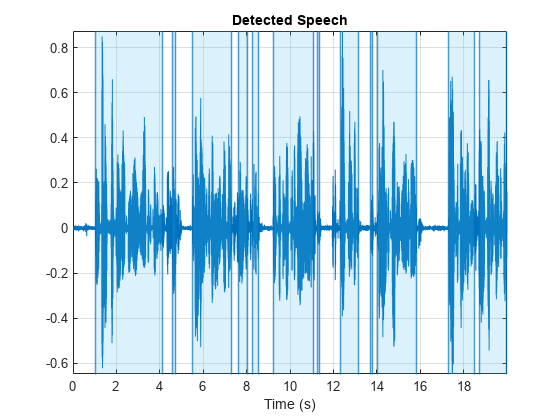

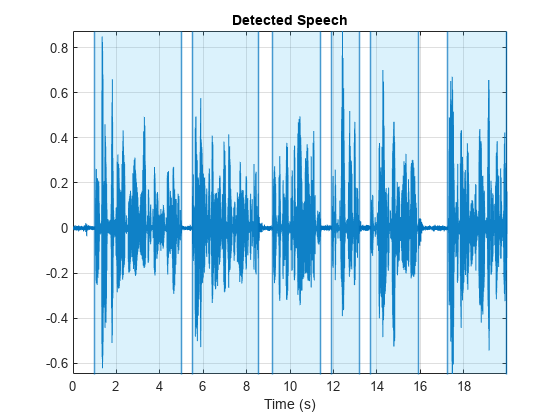

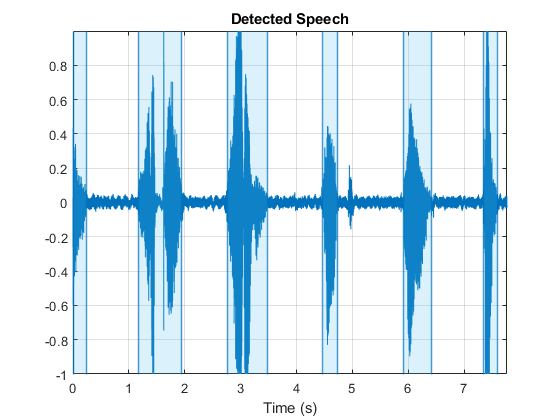

detectSpeech (___)没有输出参数显示检测到的情节演讲地区输入信号。

例子

输入参数

输出参数

算法

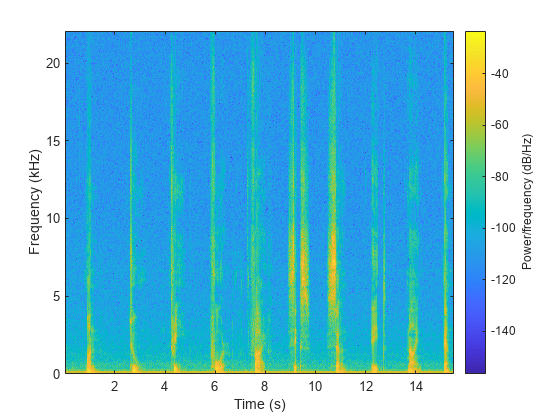

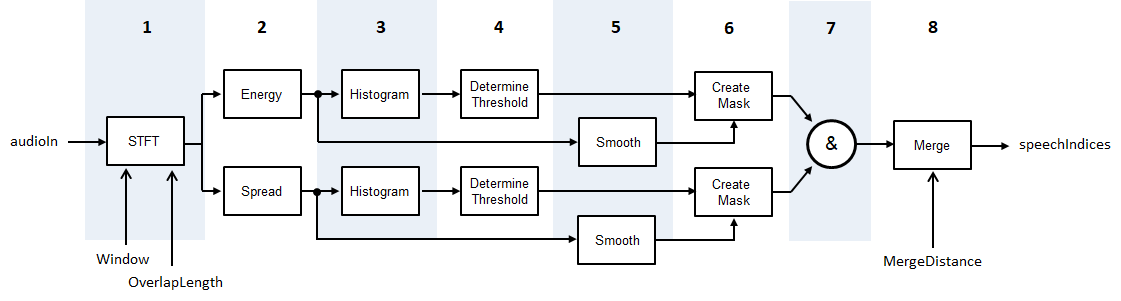

的detectSpeech算法是基于[1],尽管修改,以便统计阈值是短期能源和光谱扩散,而不是短期的能量和频谱质心。图和步骤提供一个算法的高级概述。有关详细信息,请参见[1]。

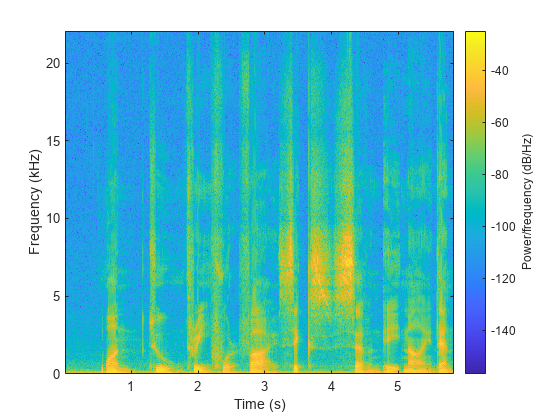

音频信号转换为使用指定的时频表示

窗口和OverlapLength。短期能源和光谱分布计算出每一帧。光谱计算根据传播

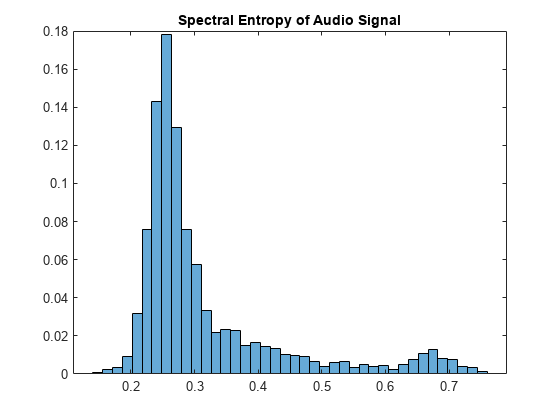

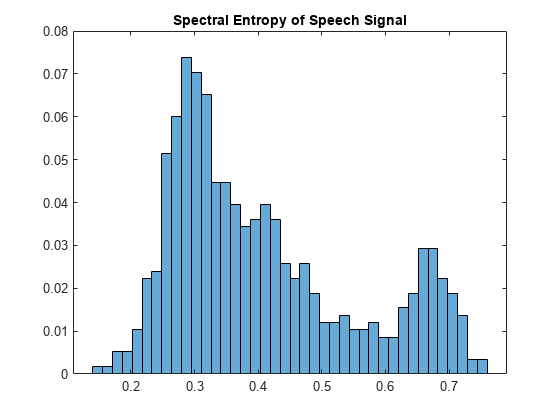

spectralSpread。直方图的创建短期能源和光谱扩散分布。

对于每一个柱状图,一个阈值是根据确定的 ,在那里米1和米2分别是第一和第二局部极大值。W被设置为

5。光谱扩散和短期能源被连续通过五行移动平滑跨越时间中位数过滤器。

面具是由比较短期能源和光谱分布和各自的阈值。声明一个框架包含演讲,必须超出阈值特性。

面具的总和。为一个框架声明为演讲,短期能源和光谱传播必须高于各自的阈值。

区域声明为演讲是如果它们之间的距离小于合并

MergeDistance。

引用

[1]Giannakopoulos,塞奥佐罗斯•。“沉默的方法去除语音信号分割,在MATLAB中实现”,(2009年雅典,雅典大学)。

扩展功能

版本历史

介绍了R2020a