比较层重量初始化器

此示例显示如何使用不同的权重初始化器培训深度学习网络。

在培训深度学习网络时,层权重和偏差的初始化可能对网络列车的程度产生了很大影响。初始化器的选择对没有批量归一化层的网络影响更大。

根据图层的类型,您可以使用该类型的权重和偏置初始化'掌控itializer'那'inputweightsinitializer'那'经常性重量初始化器', 和'偏见的人'选项。

此示例显示在培训LSTM网络时使用这三种不同权重初始化器的效果:

Glorot Initializer.- 使用Glorot Initializer初始化输入权重。[1]

他初始化- 使用HE Initializer初始化输入权重。[2]

窄正常初始化器- 通过使用零平均值和标准偏差的正常分布独立采样来初始化输入权重和0.01。

加载数据

加载日语元音数据集。XTrain.是包含270个变化长度的细胞阵列,其特征尺寸为12。y是标签1,2,...,9的分类矢量。参赛作品XTrain.是具有12行的矩阵(每个特征的一行)和不同数量的列(每次步骤一列)。

[Xtrain,Ytrain] = JapanesevowelstrainData;[xvalidation,yvalidation] =日本人vowelstestdata;

指定网络架构

指定网络架构。对于每个初始化器,使用相同的网络架构。

指定输入大小为12(输入数据的功能数)。使用100个隐藏单元指定LSTM层,并输出序列的最后一个元素。最后,通过包括一个完全连接的大小9层来指定九类,然后是Softmax层和分类层。

numfeatures = 12;numhidendunits = 100;numclasses = 9;层= [......sequenceInputlayer(numfeatures)lstmlayer(numhidentunits,'OutputMode'那'最后的')全连接列(numclasses)softmaxlayer类层]

图层= 5x1层阵列带有图层:1''序列输入序列输入,带12尺寸2''LSTM LSTM,具有100个隐藏单元3'完全连接的9完全连接的第4层''Softmax SoftMax 5''分类输出CrossentRopyex

培训选择

指定培训选项。对于每个初始化程序,使用相同的培训选项来培训网络。

maxepochs = 30;minibatchsize = 27;numobservations = numel(xtrain);numiterationsperepoch = bloor(numobservations / minibatchsize);选项=培训选项('亚当'那......'executionenvironment'那'中央处理器'那......'maxepochs',maxepochs,......'minibatchsize',小匹马,......'gradientthreshold'2,......'vightationdata',{xvalidation,yvalidation},......'验证职业',numiterationsperepoch,......'verbose',错误的,......'plots'那'培训 - 进步');

Glorot Initializer.

指定在示例中的前面列出的网络架构,并设置LSTM层的输入权重初始化程序和完全连接的图层的权重初始化程序'glorot'。

层= [......sequenceInputlayer(numfeatures)lstmlayer(numhidentunits,'OutputMode'那'最后的'那'inputweightsinitializer'那'glorot')全连接列(numcrasses,'掌控itializer'那'glorot')softmaxlayer分类层];

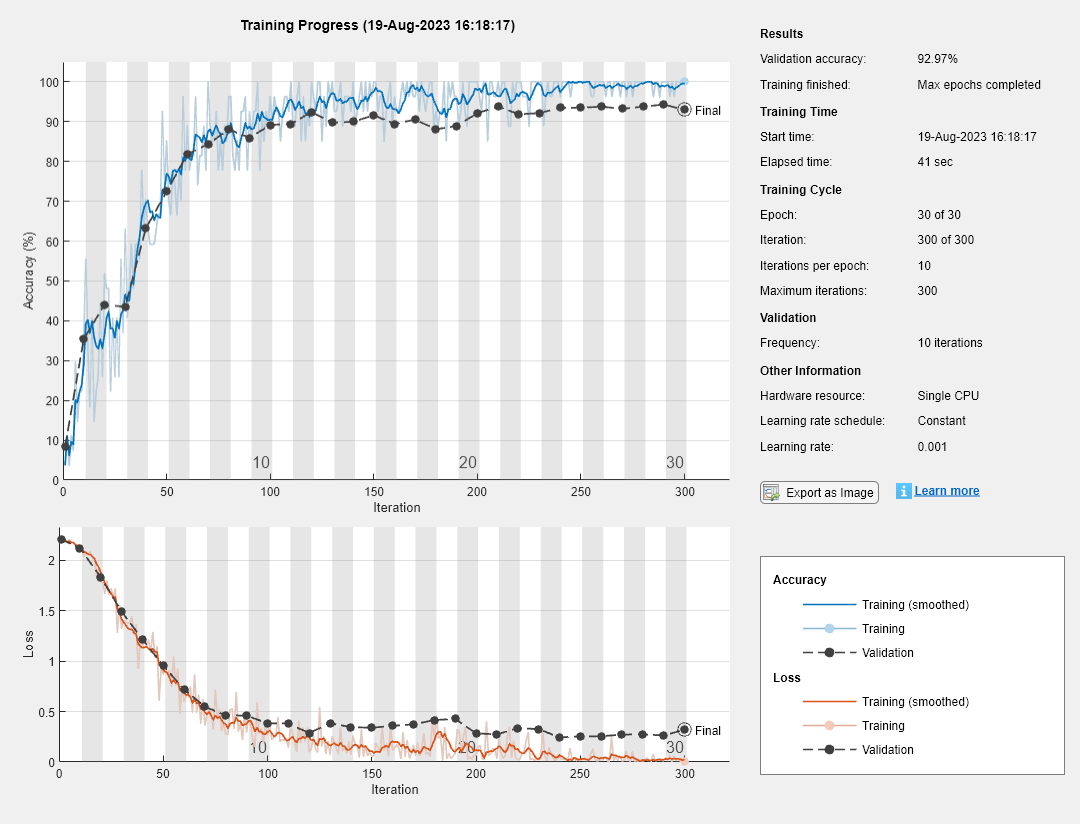

使用带有Glorot权重初始化器的图层训练网络。

[Netglorot,Infoglorot] = Trainnetwork(Xtrain,Ytrain,图层,选项);

他初始化

指定在示例中的前面列出的网络架构,并设置LSTM层的输入权重初始化程序和完全连接的图层的权重初始化程序'他'。

层= [......sequenceInputlayer(numfeatures)lstmlayer(numhidentunits,'OutputMode'那'最后的'那'inputweightsinitializer'那'他')全连接列(numcrasses,'掌控itializer'那'他')softmaxlayer分类层];

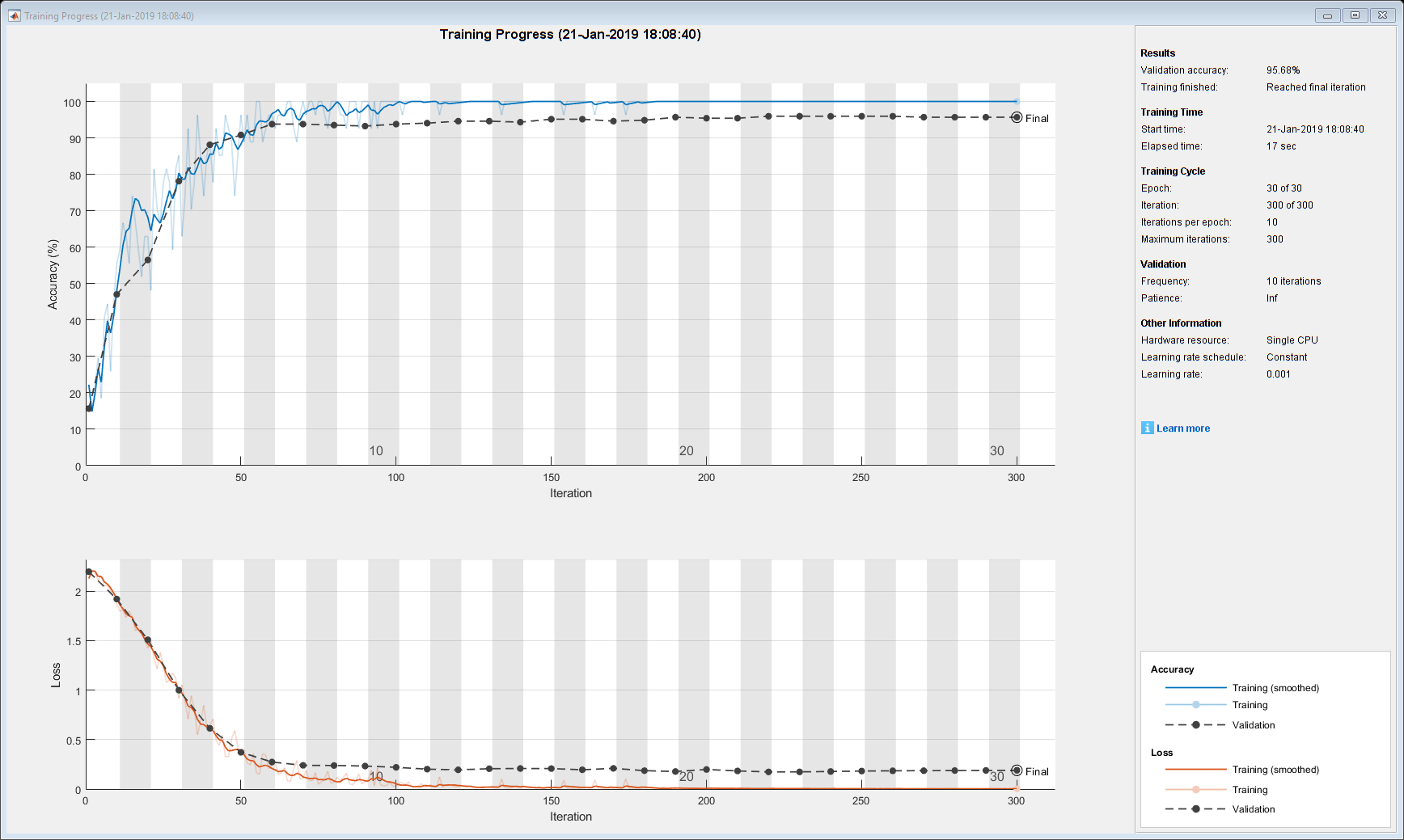

使用具有他重量初始化器的图层训练网络。

[Nethe,Infohe] = Trainnetwork(Xtrain,Ytrain,图层,选项);

窄正常初始化器

指定在示例中的前面列出的网络架构,并设置LSTM层的输入权重初始化程序和完全连接的图层的权重初始化程序'窄正常'。

层= [......sequenceInputlayer(numfeatures)lstmlayer(numhidentunits,'OutputMode'那'最后的'那'inputweightsinitializer'那'窄正常')全连接列(numcrasses,'掌控itializer'那'窄正常')softmaxlayer分类层];

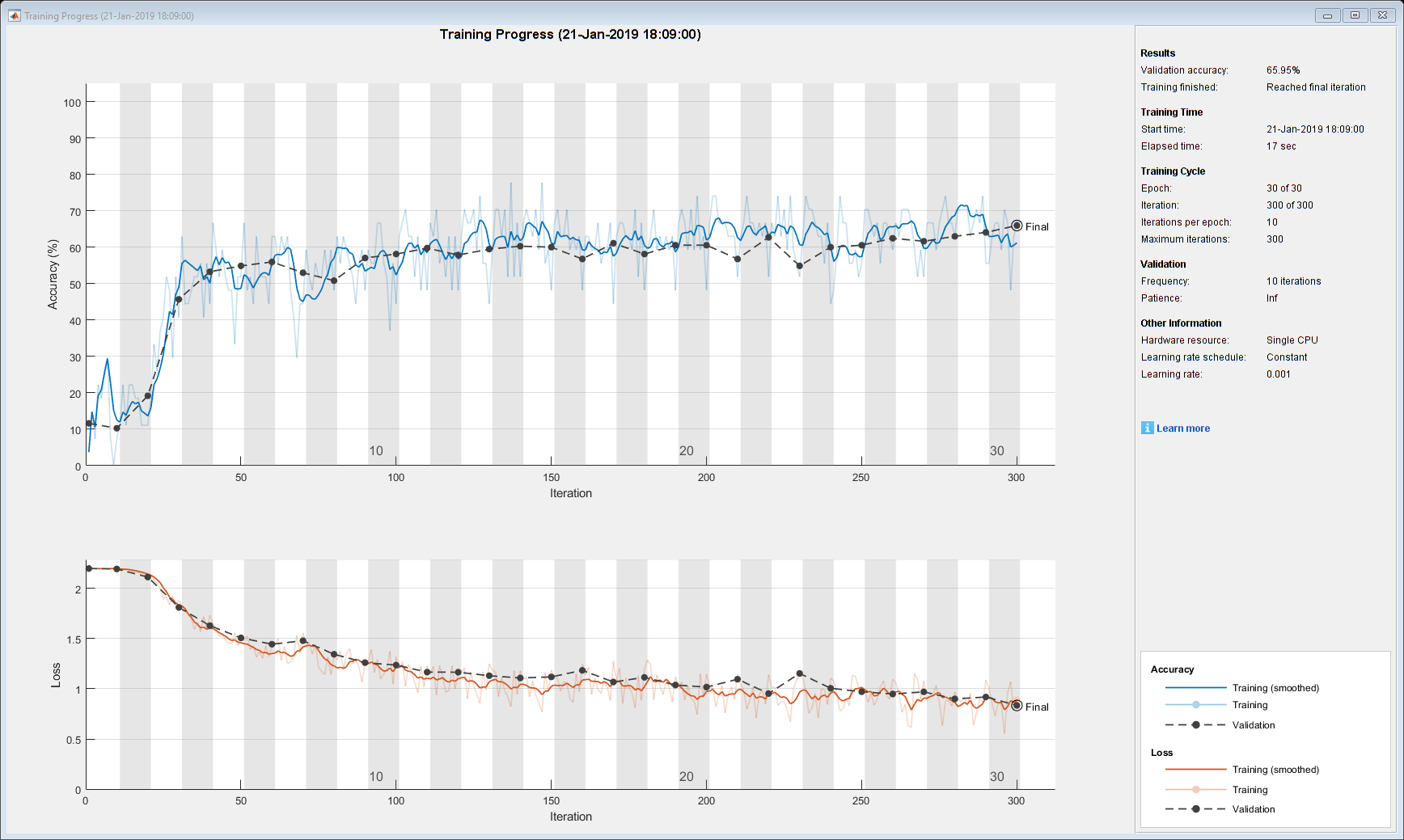

使用带有窄正常重量初始化器的图层培训网络。

[NetnArrownormal,InfonArrownalal] = Trainnetwork(XTrain,Ytrain,图层,选项);

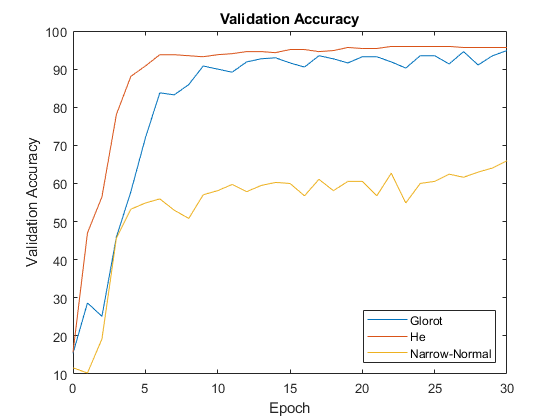

绘图结果

从来自信息结构的输出中提取验证精度Trainnetwork.功能。

ValidationAccuracy = [Infoglorot.ValidationAccuracy;Infohe.ValidationAccuracy;InfonArrownormal.ValidationAccuracy];

验证精度的载体包含南对于未计算验证准确性的迭代。去除那个南价值观。

idx =全部(ISNAN(验证成数));ValidationAccuracy(:,IDX)= [];

对于每个初始化器,请绘制验证准确性的时代数。

图epochs = 0:maxepochs;绘图(时代,验证成本)标题(“验证准确性”)xlabel(“时代”)ylabel(“验证准确性”) 传奇([“glorot”“他”“窄正常”],'地点'那'东南')

此图显示了不同初始化器的整体效果以及培训对每个初始频率的效果。

参考书目

Glorot,Xavier和Yoshua Bengio。“了解训练深馈神经网络的难度。”在第十三国际人工智能和统计国际会议的诉讼程序,pp。249-256。2010年。

他,Kaiming,湘雅张,邵庆仁,剑孙。“深入研究整流器:超越了在想象集分类上的人力水平表现。”在IEEE计算机愿景国际会议的诉讼程序,pp。1026-1034。2015年。