主要内容

强化学习在控制系统中的应用

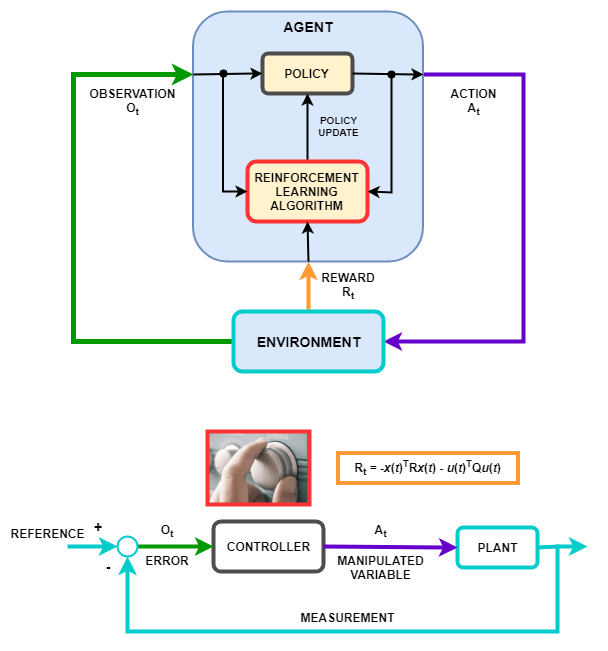

强化学习策略的行为(即策略如何观察环境并生成操作以最优方式完成任务)类似于控制系统中控制器的操作。强化学习可以使用以下映射转换为控制系统表示。

| 强化学习 | 控制系统 |

|---|---|

| 政策 | 控制器 |

| 环境 | 非控制器的一切——在上图中,环境包括设备、参考信号和误差计算。一般来说,环境还可以包括其他元素,例如:

|

| 观察 | 代理可见的环境中的任何可测量值-在上图中,控制器可以看到环境中的错误信号。您还可以创建观察参考信号、测量信号和测量信号变化率的代理。 |

| 行动 | 操纵变量或控制动作 |

| 奖励 | 测量、误差信号或其他性能指标的功能-例如,您可以实现奖励功能,在最小化控制工作量的同时最小化稳态误差。当控制规范(如成本和约束函数)可用时,您可以使用生成函数从MPC对象或模型验证块生成奖励函数。然后,您可以使用生成的奖励函数作为奖励设计的起点,例如通过更改权重或惩罚函数。 |

| 学习算法 | 自适应控制器的适应机制 |

在机器人技术和自动驾驶等领域遇到的许多控制问题都需要复杂的非线性控制架构。诸如增益调度、鲁棒控制和非线性模型预测控制(MPC)等技术可以用于解决这些问题,但通常需要控制工程师具有重要的领域专业知识。例如,增益和参数很难调优。由此产生的控制器可能会给实现带来挑战,如非线性MPC的计算强度。

您可以使用经过强化学习训练的深度神经网络来实现这种复杂的控制器。这些系统可以在没有专家控制工程师干预的情况下自学。此外,一旦系统经过培训,您可以以计算效率高的方式部署强化学习策略。

您还可以使用强化学习创建端到端控制器,直接从原始数据(如图像)生成操作。这种方法对于视频密集型应用(如自动驾驶)很有吸引力,因为您不必手动定义和选择图像特征。