主要内容

rlrepresentationOptions.

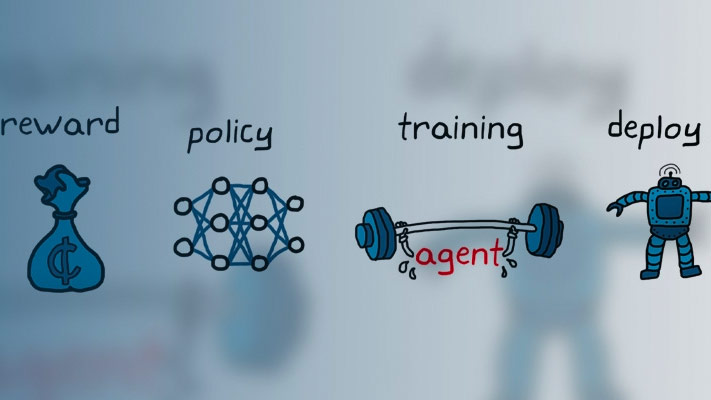

为强化学习代理表示(批评者和参与者)设置的选项

描述

创建

特性

对象功能

rlvalueerepresentation |

增强学习代理的价值函数批评者表示 |

rlqvalueerepresentation |

Q-Value Function评论家强化学习代理的代表 |

RLDETerminyActorRepresentation |

强化学习主体的确定性行为体表示 |

rlStochasticActorRepresentation |

强化学习智能体的随机角色表示 |

例子

也可以看看

话题

在R2019A介绍