基于并行计算的车道保持辅助DQN Agent训练

这个例子展示了如何使用并行训练在Simulink®中训练一个深度q学习网络(DQN)代理保持车道辅助(LKA)。万博1manbetx有关如何在不使用并行训练的情况下训练代理的示例,请参见对DQN代理进行车道保持协助培训.

有关DQN代理的更多信息,请参阅深Q-Network代理.在MATLAB®中训练DQN代理的示例,请参见培训DQN员工平衡车杆系统.

DQN并行培训概述

在DQN代理中,每个工作人员从代理和环境的副本生成新的体验。毕竟N步骤,工作者向客户端代理发送经验(与启动培训的Matlab®进程关联的代理)。客户端代理如下更新其参数。

对于异步培训,客户代理从收到的经验中学习,而无需等待所有工人发送经验,并将更新的参数发送回提供经验的工作人员。然后,工人继续使用更新的参数从其环境生成经验。

对于同步培训,客户机代理等待从所有工人那里获得经验,并从这些经验中学习。然后,客户机将更新的参数同时发送给所有工人。然后,所有工作人员继续使用更新的参数生成体验。

有关同步与异步并行化的更多信息,请参阅使用并行计算和gpu的列车代理.

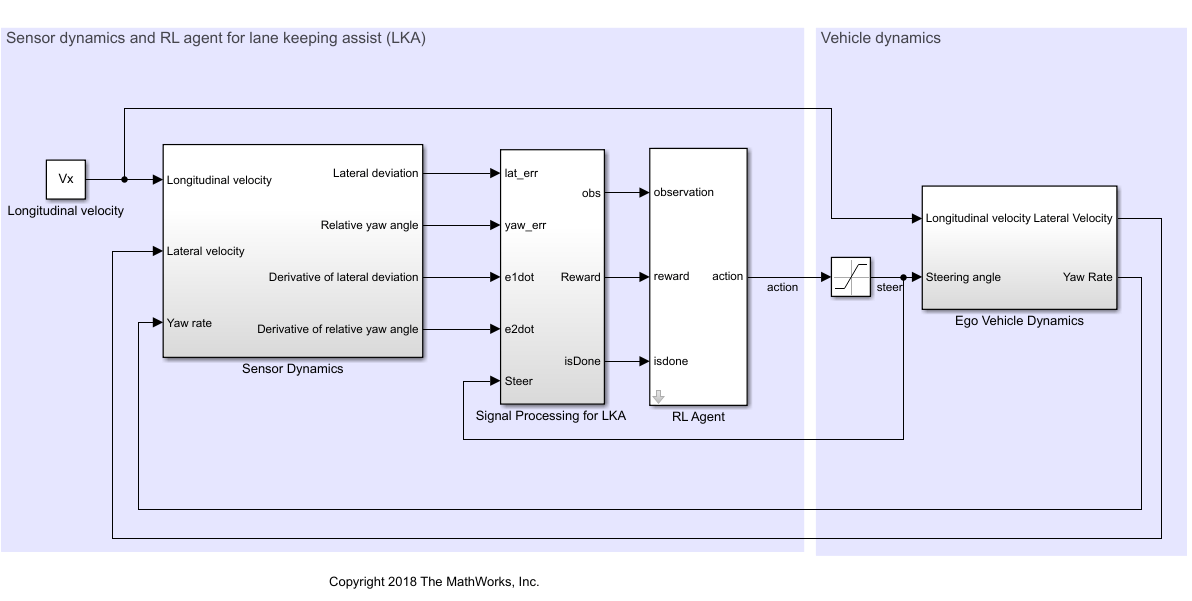

万博1manbetx汽车的Simulink模型

本例中的强化学习环境是一个用于自我车辆动力学的简单自行车模型。培训目标是通过调整前转向角,使ego车辆沿车道中心线行驶。此示例使用与相同的车型对DQN代理进行车道保持协助培训.

m=1575;%车辆总质量(kg)工业区= 2875;%惯性矩(MNS ^ 2)lf=1.2;重心到前胎纵向距离百分比(m)lr = 1.6;%重心到后胎纵向距离(m)Cf=19000;前轮转弯刚度百分比(N/rad)CR = 33000;后轮转弯刚度百分比(N/rad)Vx = 15;%纵向速度(m/s)

定义样本时间Ts和仿真持续时间T.片刻之间。

Ts=0.1;T=15;

LKA系统的输出是ego汽车的前转向角。要模拟ego汽车的物理转向限制,请将转向角限制在范围内[–0.5,0.5]rad。

u_min=-0.5;u_max=0.5;

道路的曲率定义为常数0.001 (

).横向偏差的初始值为0.2m和相对偏航角的初始值是–0.1rad。

ρ= 0.001;e1_initial = 0.2;e2_initial = -0.1;

打开模型。

mdl =“rlLKAMdl”;Open_system (mdl) agentblk = [mdl . Open_system (mdl)'/ rl代理'];

对于这个模型:

从agent到环境的转向角动作信号为–15度到15度。

来自环境的观察是横向偏差 ,相对偏航角 ,他们的衍生品 和 ,他们的积分 和 .

横向偏差时终止模拟

奖励 ,提供在每个时间步骤 ,是

在哪里 是前一步的控制输入 .

创建环境接口

为自我车辆创建一个强化学习环境界面。

定义观察信息。

observationInfo = rlNumericSpec([6 1],“LowerLimit”,负无穷* (6,1),'上限',INF * of(6,1));观察info.name =“观察”;观察invfo.description =.“横向偏差和相对偏航角信息”;

定义动作信息。

actionInfo = rlFiniteSetSpec((15:15) *π/ 180);actionInfo。Name ='操舵';

创建环境界面。

env=rlSi万博1manbetxmulinkEnv(mdl、agentblk、observationInfo、actionInfo);

该界面有一个离散的动作空间,在该空间中,代理可以应用-15度到15度之间的31个可能转向角中的一个。观测是包含横向偏差、相对偏航角及其对时间的导数和积分的六维向量。

若要定义横向偏差和相对偏航角的初始条件,请使用匿名函数句柄指定环境复位函数。localResetFcn,在该示例结束时定义,随机化初始横向偏差和相对偏航角。

env.resetfcn = @(in)localresetfcn(in);

修复随机生成器种子以获得再现性。

rng (0)

创建DQN Agent.

DQN代理可以使用多输出q值批判逼近器,这通常更有效。多输出近似器将观察值作为输入,状态行为值作为输出。每个输出元素表示从观察输入所指示的状态中采取相应离散行动的预期累积长期回报。

为了创建评论家,首先创建一个具有一个输入(六维观察状态)的深神经网络(六维观察状态)和31个元件的一个输出矢量(从-15到15度均匀间隔的转向角)。有关创建深度神经网络值函数表示的更多信息,请参阅创建策略和价值功能表示.

ni =观察invimo.dimension(1);%输入数量(6)nl = 120;神经元百分数没有=元素个数(actionInfo.Elements);%输出数(31)dnn = [featureinputlayer(ni,“归一化”那'没有任何'那'姓名'那“状态”) fullyConnectedLayer(问,'姓名'那“fc1”)剥离('姓名'那“relu1”) fullyConnectedLayer(问,'姓名'那“取得”)剥离('姓名'那“relu2”)全康连接层(不,'姓名'那“一个fc3”文件));

查看网络配置。

图绘图(层图(DNN))

指定使用批评者的选项rlrepresentationOptions..

criticOptions = rlRepresentationOptions ('学习'1的军医,'gradientthreshold'1.“L2调节因子”,1E-4);

使用指定的深度神经网络和选项创建批评家表示。您还必须为评论家指定操作和观察信息,这些信息是从环境接口获得的。有关更多信息,请参阅rlQValueRepresentation.

评论家= rlqvaluerepresentation(dnn,devalidationinfo,afticeinfo,“观察”, {“状态”},批评);

要创建DQN代理,首先使用rlDQNAgentOptions.

Agentopts = RLDQNAGENTOPTIONS(...“采样时间”Ts,...'unmorblebledqn',真的,...“TargetSmoothFactor”1 e - 3,...'贴花因子',0.99,...'经验BufferLength',1e6,...“MiniBatchSize”,256);Adjeropts.epsilongredyexpliation.epsilondecay = 1e-4;

然后使用指定的批评表示和代理选项创建DQN代理。有关更多信息,请参阅rldqnagent..

代理= rldqnagent(批评者,代理商);

培训选择

要培训代理,请首先指定培训选项。对于本例,请使用以下选项。

每次训练最多进行一次

10000每集最多持续一集ceil(T/Ts)时间步骤。仅显示Episode Manager对话框中的培训进度(设置

情节和verb选择相应的选项)。当情节奖励达到时停止训练

-1.为每个累计奖励大于100,保存代理的副本。

有关更多信息,请参阅rlTrainingOptions.

maxepisodes = 10000;maxsteps = ceil(t / ts);训练= rltrainingOptions(...“最大集”maxepisodes,...“MaxStepsPerEpisode”,maxsteps,...“详细”假的,...'plots'那“训练进步”那...'stoptrinaincriteria'那'EpisodeReward'那...“StopTrainingValue”, -1,...“SaveAgentCriteria”那'EpisodeReward'那...'SaveagentValue',100);

并行培训选项

要并行培训代理,请指定以下培训选项。

设置

使用指α.选择真正的.通过设置异步并行训练代理

ParallelizationOptions.Mode选择“异步”.在每30个步骤之后,每个工作人员将体验发送给客户。

DQN代理要求工作人员发送

体验”给客户。

trainOpts.usepallel=true;trainOpts.ParallelizationOptions.Mode=“异步”; trainOpts.ParallelizationOptions.DataToSendFromWorkers=“经验”; trainOpts.ParallelizationOptions.StepsUntilDataIsSent=32;

有关更多信息,请参阅rlTrainingOptions.

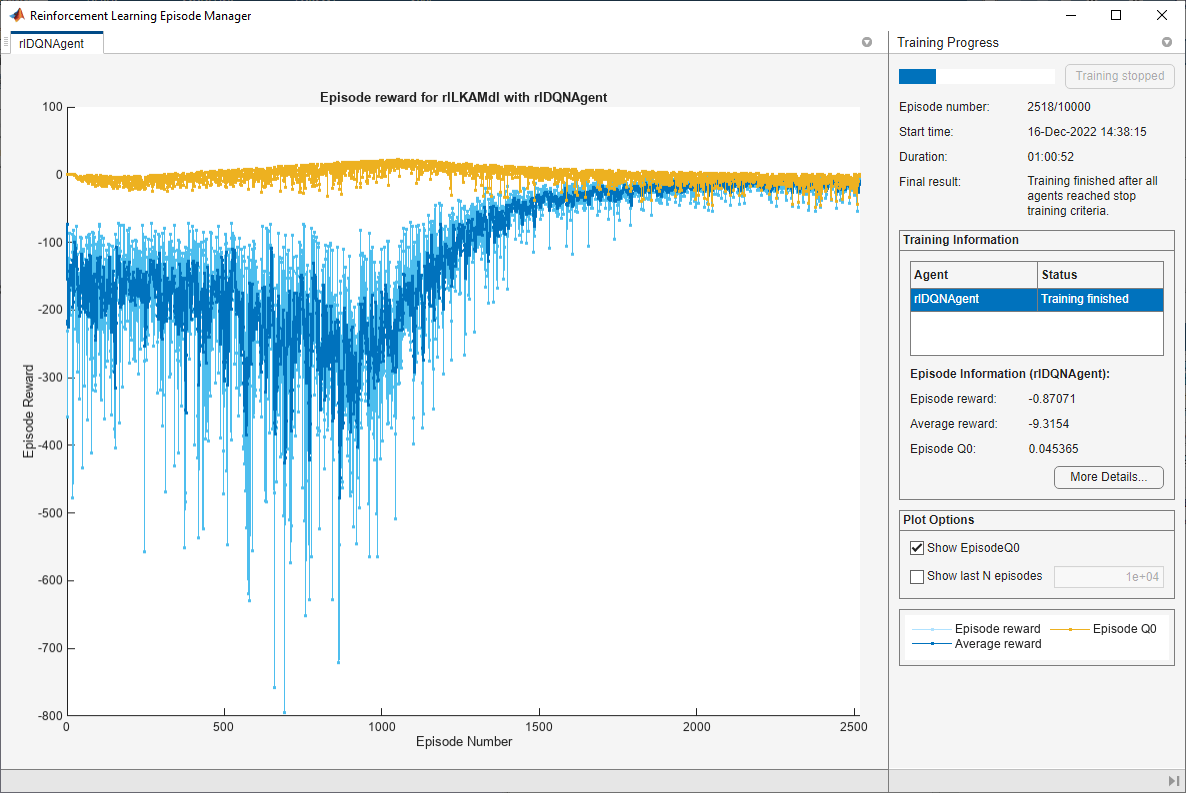

火车代理

使用火车功能。训练代理是一个计算密集型过程,需要几分钟才能完成。要在运行此示例时节省时间,请通过设置用圆形来错误的.自己训练代理人,设置用圆形来真正的.由于并行训练的随机性,您可以从下面的图中看到不同的训练结果。这张图显示了四名工人的培训结果。

doTraining = false;如果用圆形培训代理商。trainingStats=列车(代理人、环境、列车员);别的%为示例加载预训练的代理。负载(“万博1manbetxSimulinkLKADQNParallel.mat”那“代理”)结尾

模拟DQN代理

要验证培训的代理的性能,请取消注释以下两行并在环境中模拟代理。有关代理模拟的更多信息,请参阅模拟选项和SIM.

%simoptions = rlsimulationoptions('maxsteps',maxsteps);%体验= SIM(ENV,Agent,SimOptions);

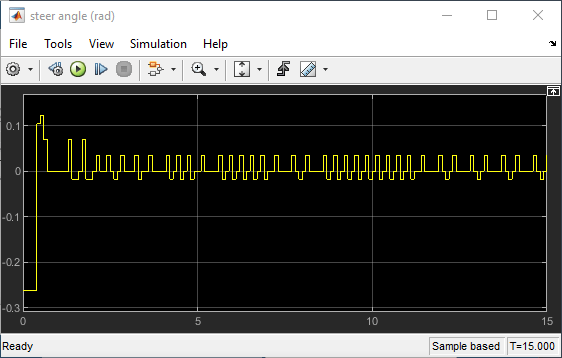

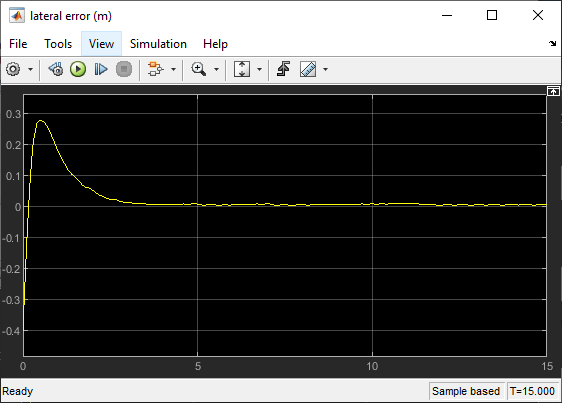

要使用确定性初始条件展示培训的代理,请在Simulink中模拟模型。万博1manbetx

e1_initial = -0.4;e2_initial = 0.2;sim (mdl)

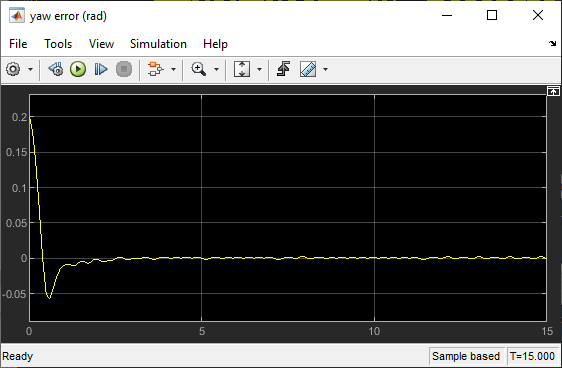

如下所示,横向误差(中图)和相对横摆角(底部曲线)被驱动为零。车辆从偏离中心线(-0.4米)和非零偏航角误差(0.2 rad)开始。LKA使自助式汽车能够在2.5秒后沿着中心线行进。转向角(顶部图)表明控制器在2秒后达到稳定状态。

局部函数

函数= localResetFcn(中)%重置= setVariable (,'e1_initial', 0.5 *(1 + 2 *兰德));%横向偏差的随机值= setVariable (,'e2_initial',0.1 *( - 1 + 2 * rand));相对偏航角度的%随机值结尾