dlnetwork

用于定制训练循环的深度学习网络

描述

一个dlnetwork对象支持使用自动区分自定义训练万博1manbetx循环。

提示

对于大多数深度学习任务,你可以使用预先训练好的网络,并使其适应你自己的数据。有关演示如何使用迁移学习重新训练卷积神经网络来对一组新图像进行分类的示例,请参见训练深度学习网络对新图像进行分类.或者,您可以从头创建和训练网络layerGraph对象具有trainNetwork而且trainingOptions功能。

如果trainingOptions函数没有为您的任务提供所需的训练选项,那么您可以使用自动区分创建自定义训练循环。要了解更多信息,请参见为自定义训练循环定义深度学习网络.

创建

语法

描述

网= dlnetwork (层)层初始化dlnetwork对象,表示用于自定义训练循环的深度神经网络。层可以是LayerGraph对象或层数组中。层必须包含输入层。

一个初始化dlnetwork对象已准备好进行训练。的可学习参数和状态值网根据网络输入层定义的输入大小初始化训练。

网= dlnetwork (___、“OutputNames”名称)OutputNames属性。的OutputNames属性指定返回网络输出的层。要设置输出名称,必须初始化网络。

网= dlnetwork (prunableNet)prunableNet并返回压缩后的dlnetwork具有较少可学习参数且尺寸较小的对象。

要修剪一个深度神经网络,你需要深度学习工具箱™模型量化库万博1manbetx支持包。此支持包是万博1manbetx一个免费的附加组件,您可以使用附加组件资源管理器下载。另外,看到深度学习工具箱模型量化库.

输入参数

层- - - - - -网络层

LayerGraph对象|层数组

网络层,指定为aLayerGraph对象或作为层数组中。

如果层是一个层数组,然后dlnetwork函数将层串联起来。

网络层不能包含输出层。训练网络时,单独计算损失。

控件支持的层列表万博1manbetxdlnetwork,请参阅万博1manbetx支持层.

X1,…,Xn- - - - - -示例网络输入或数据布局

格式化dlarray对象|格式化networkDataLayout对象

示例网络输入或数据布局,指定为格式化dlarray对象或格式化的对象networkDataLayout对象。软件传播X1,…Xn通过网络确定合适的大小和格式的可学习参数和状态参数dlnetwork.

当层是一个层数组中,以与需要输入的层出现在中的相同顺序提供示例输入层数组中。当层是一个LayerGraph对象中,以与需要输入的层出现的顺序相同的顺序提供示例输入层的属性LayerGraph.

时不支持示例输入万博1manbetx特遣部队是假的。

请注意

自动初始化只使用输入数据的大小和格式信息。对于依赖于输入数据的值的初始化,必须手动初始化可学习参数。

特遣部队- - - - - -返回初始化的标志dlnetwork

1(真正的)(默认)|0(假)

返回初始化的标志dlnetwork,指定为数字或逻辑1(真正的)或0(假)。

如果特遣部队是1的可学习参数和状态参数进行初始化网用初始值进行训练,根据网络输入层或示例输入提供。

如果特遣部队是0,则软件不初始化可学习参数和状态参数。在使用未初始化的网络之前,必须首先使用初始化函数。时不支持示例输入万博1manbetx特遣部队是假的。

prunableNet- - - - - -利用一阶泰勒近似进行网络剪枝

TaylorPrunableNetwork对象

通过使用一阶泰勒近似来修剪网络,指定为aTaylorPrunableNetwork对象。

属性

层- - - - - -网络层

层数组

此属性是只读的。

网络层,指定为a层数组中。

连接- - - - - -层连接

表格

此属性是只读的。

层连接,指定为具有两列的表。

每个表行表示层图中的一个连接。第一列,源,指定每个连接的源。第二列,目的地,指定每个连接的目的地。连接源和目的地要么是层名,要么具有表单“layerName / IOName”,在那里“IOName”层输入或输出的名称。

数据类型:表格

可学的- - - - - -网络可学习参数

表格

网络可学习参数,指定为一个有三列的表:

层-层名,指定为字符串标量。参数—参数名称,指定为字符串标量。价值-参数的值,用a表示dlarray对象。

网络可学习参数包含网络学习到的特征。例如,卷积和全连通层的权值。

数据类型:表格

InputNames- - - - - -网络输入层名称

字符向量的单元格数组

此属性是只读的。

网络输入层名称,指定为字符向量的单元格数组。

数据类型:细胞

初始化- - - - - -初始化网络的标志

0(假)|1(真正的)

此属性是只读的。

初始化网络的标志,指定为0(虚假的)或1(真正的)。

如果初始化是0(false)表示网络未初始化。在使用网络之前,必须初始化网络。方法初始化网络初始化函数。

如果初始化是1(true),则网络被初始化,并可用于训练和推理。如果您更改了可学习参数的值(例如,在训练期间),则初始化仍然是1(真正的)。

数据类型:逻辑

对象的功能

预测 |

计算用于推理的深度学习网络输出 |

向前 |

计算用于训练的深度学习网络输出 |

初始化 |

初始化的可学习参数和状态参数dlnetwork |

layerGraph |

用于深度学习的网络层图 |

setL2Factor |

设置层可学习参数的L2正则化因子 |

setLearnRateFactor |

设置层可学习参数的学习速率因子 |

getLearnRateFactor |

得到层可学习参数的学习率因子 |

getL2Factor |

得到层可学习参数的L2正则化因子 |

resetState |

复位神经网络状态参数 |

情节 |

图神经网络结构 |

addInputLayer |

为网络添加输入层 |

addLayers |

在图层图或网络中添加图层 |

removeLayers |

从图层图或网络中删除图层 |

connectLayers |

在层图或网络中连接层 |

disconnectLayers |

断开层图或网络中的层 |

replaceLayer |

在层图或网络中替换层 |

总结 |

打印网络摘要 |

例子

将预训练网络转换为dlnetwork对象

要为网络实现自定义训练循环,首先将其转换为dlnetwork对象。中不包括输出层dlnetwork对象。相反,您必须在自定义训练循环中指定损失函数。

加载一个预先训练好的GoogLeNet模型googlenet函数。此功能需要深度学习工具箱™模型为GoogLeNet网络万博1manbetx支持包。如果没有安装此支万博1manbetx持包,则该函数将提供下载链接。

Net = googlenet;

将网络转换为层图,并删除用于分类使用的层removeLayers.

lgraph = layerGraph(net);lgraph = removeLayers(lgraph,[“概率”“输出”]);

将网络转换为adlnetwork对象。

Dlnet = dlnetwork(lgraph)

dlnet = dlnetwork with properties: Layers: [142x1 nnet.cnn.layer.Layer] Connections: [168x2 table] Learnables: [116x3 table] State: [0x3 table] InputNames: {'data'} OutputNames: {'loss3-classifier'} Initialized: 1查看summary with summary。

创建初始化dlnetwork输入不连接

使用网络数据布局对象创建多输入dlnetwork准备好训练了。该软件利用大小和格式信息来确定适当的大小和格式的可学习参数和状态参数dlnetwork.

定义网络架构。构造一个有两个分支的网络。网络有两个输入,每个分支有一个输入。使用附加层连接分支。

numFilters = 24;layersBranch1 = [convolution2dLayer(3,6*numFilters,Padding= .“相同”步= 2)groupNormalizationLayer (“所有渠道”) reluLayer卷积2dlayer (3,numFilters,填充=“相同”) groupNormalizationLayer (“channel-wise”) additionLayer (Name =“添加”reluLayer fullyConnectedLayer(10) softmaxLayer];layersBranch2 = [convolution2dLayer(1,numFilters)“所有渠道”、名称=“gnBranch2”));lgraph = layerGraph(layersBranch1);lgraph = addLayers(lgraph,layersBranch2);lgraph = connectLayers(“gnBranch2”,“添加/ in2”);

创建表示典型网络输入的大小和格式的网络数据布局对象。对于这两个输入,使用32的批处理大小。在第一个分支的卷积层中使用大小为64 × 64的带有三个通道的输入。在第二个分支的卷积层中使用大小为64 × 64的18个通道的输入。

X1 = dlarray(rand([64 64 3 32]),“SSCB”);X2 = dlarray(rand([32 32 18 32]),“SSCB”);

创建dlnetwork.类中未连接层出现的相同顺序提供输入层的属性lgraph.

net = dlnetwork(lgraph,X1,X2);

检查网络是否已初始化,并为训练做好准备初始化网络属性。

网初始化

ans =逻辑1

使用自定义训练循环训练网络

这个例子展示了如何训练一个使用自定义学习率计划分类手写数字的网络。

可以训练大多数类型的神经网络trainNetwork而且trainingOptions功能。如果trainingOptions函数没有提供您需要的选项(例如,自定义学习速率计划),那么您可以使用dlarray而且dlnetwork对象用于自动区分。的例子,展示如何重新训练一个预训练的深度学习网络trainNetwork功能,请参阅使用预训练网络的迁移学习.

训练深度神经网络是一项优化任务。把神经网络看成一个函数 ,在那里 是网络输入,和 是否设置了可学习的参数,可以进行优化 这样就可以最小化一些基于训练数据的损失值。例如,优化可学习参数 对于给定的输入 有相应的目标 ,他们将预测之间的误差最小化 而且 .

所使用的损失函数取决于任务的类型。例如:

对于分类任务,您可以最小化预测和目标之间的交叉熵误差。

对于回归任务,您可以最小化预测和目标之间的均方误差。

你可以使用梯度下降来优化目标:最小化损失 通过迭代更新可学习参数 通过使用与可学习参数相关的损失梯度,采取步骤达到最小值。梯度下降算法通常通过使用这种形式的更新步骤的变体来更新可学习参数 ,在那里 是迭代数, 是学习率,和 表示梯度(损失相对于可学习参数的导数)。

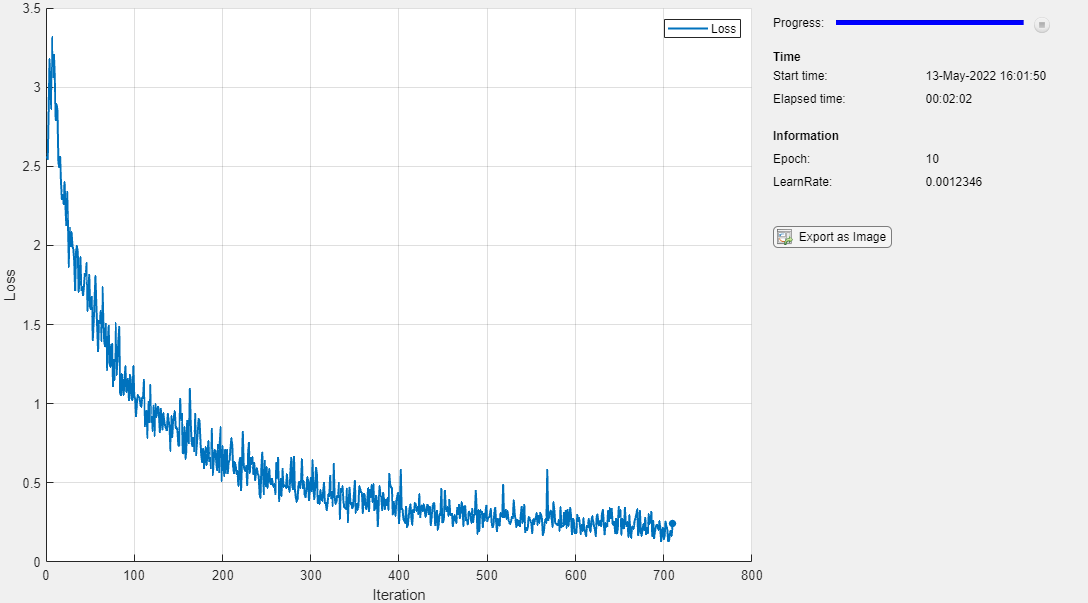

此示例训练网络对手写数字进行分类基于时间的衰减学习率计划:对于每次迭代,求解器使用 ,在那里t是迭代数, 初始学习率,和k就是衰变。

负荷训练数据

方法将数字数据加载为图像数据存储imageDatastore函数并指定包含图像数据的文件夹。

dataFolder = fullfile(toolboxdir(“nnet”),“nndemos”,“nndatasets”,“DigitDataset”);imds = imageDatastore(数据文件夹,...IncludeSubfolders = true,....LabelSource =“foldernames”);

将数据划分为训练集和验证集。方法留出10%的数据用于验证splitEachLabel函数。

[imdsTrain,imdsValidation] = splitEachLabel(imds,0.9,“随机”);

本例中使用的网络需要大小为28 × 28 × 1的输入图像。要自动调整训练图像的大小,请使用增强图像数据存储。指定要对训练图像执行的附加增强操作:在水平轴和垂直轴上随机将图像平移到5个像素。数据增强有助于防止网络过度拟合和记忆训练图像的确切细节。

inputSize = [28 28 1];pixelRange = [-5 5];imageAugmenter = imageDataAugmenter(...RandXTranslation = pixelRange,...RandYTranslation = pixelRange);augimdsTrain = augmentedImageDatastore(inputSize(1:2),imdsTrain,DataAugmentation=imageAugmenter);

若要自动调整验证图像的大小,而不执行进一步的数据增强,请使用增强图像数据存储,而不指定任何额外的预处理操作。

augimdsValidation = augmentedImageDatastore(inputSize(1:2),imdsValidation);

确定训练数据中的类数。

classes = categories(imdsTrain.Labels);numClasses = nummel(类);

定义网络

定义图像分类的网络。

对于图像输入,指定输入大小与训练数据匹配的图像输入层。

不归一化的图像输入,设置

归一化选项的输入层“没有”.指定三个卷积-batchnorm- relu块。

将输入填充到卷积层中,使输出具有相同的大小

填充选项“相同”.对于第一个卷积层,指定20个大小为5的滤波器。对于剩余的卷积层,指定20个大小为3的滤波器。

对于分类,指定一个大小与类数量匹配的全连接层

为了将输出映射到概率,需要包含一个softmax层。

当使用自定义训练循环训练网络时,不要包含输出层。

layers = [imageInputLayer(inputSize,归一化=“没有”) convolution2dLayer(5、20、填充=“相同”) batchNormalizationLayer relullayer卷积2dlayer(3,20,填充=“相同”) batchNormalizationLayer relullayer卷积2dlayer(3,20,填充=“相同”) batchNormalizationLayer reluLayer fullyConnectedLayer(numClasses) softmaxLayer];

创建一个dlnetwork对象。

Net = dlnetwork(layers)

net = dlnetwork with properties: Layers: [12×1 nnet.cnn.layer.Layer] Connections: [11×2 table] Learnables: [14×3 table] State: [6×3 table] InputNames: {'imageinput'} OutputNames: {'softmax'} Initialized: 1使用summary查看summary。

定义模型损失函数

训练深度神经网络是一项优化任务。把神经网络看成一个函数 ,在那里 是网络输入,和 是否设置了可学习的参数,可以进行优化 这样就可以最小化一些基于训练数据的损失值。例如,优化可学习参数 对于给定的输入 有相应的目标 ,他们将预测之间的误差最小化 而且 .

创建函数modelLoss,列于模型损失函数部分的示例,将其作为输入dlnetwork对象,带有相应目标的小批输入数据,并返回损失、损失相对于可学习参数的梯度以及网络状态。

指定培训项目

用128个小批量训练10个epoch。

numEpochs = 10;miniBatchSize = 128;

指定用于SGDM优化的选项。指定初始学习速率为0.01,衰减为0.01,动量为0.9。

initialLearnRate = 0.01;衰减= 0.01;动量= 0.9;

火车模型

创建一个minibatchqueue对象,该对象在训练期间处理和管理小批量图像。对于每个小批量:

使用自定义小批量预处理功能

preprocessMiniBatch(在本例结束时定义)将标签转换为单热编码变量。用尺寸标签格式化图像数据

“SSCB”(空间,空间,通道,批次)。默认情况下,minibatchqueue对象将数据转换为dlarray具有基础类型的对象单.不要格式化类标签。如果有GPU,可以在GPU上进行训练。默认情况下,

minibatchqueue对象将每个输出转换为gpuArray如果GPU可用。使用GPU需要并行计算工具箱™和受支持的GPU设备。万博1manbetx有关受支持设备的信息,请参见万博1manbetxGPU计算要求(并行计算工具箱).

mbq = minibatchqueue(augimdsTrain,...MiniBatchSize = MiniBatchSize,...MiniBatchFcn = @preprocessMiniBatch,...MiniBatchFormat = [“SSCB”""]);

初始化SGDM求解器的速度参数。

速度= [];

计算训练进度监控器的总迭代次数。

numObservationsTrain = numel(imdsTrain.Files);numIterationsPerEpoch = ceil(numObservationsTrain / miniBatchSize);numIterations = nummepochs * numIterationsPerEpoch;

初始化TrainingProgressMonitor对象。因为计时器在创建监视器对象时开始,所以请确保创建的对象接近训练循环。

monitor = trainingProgressMonitor(指标=“损失”信息= (“时代”,“LearnRate”),包含=“迭代”);

使用自定义训练循环训练网络。对于每个纪元,洗牌数据并在小批量数据上循环。对于每个小批量:

方法评估模型损失、梯度和状态

dlfeval而且modelLoss函数并更新网络状态。确定基于时间的衰减学习率计划的学习率。

方法更新网络参数

sgdmupdate函数。更新训练进度监视器中的损失、学习率和epoch值。

如果Stop属性为真,则停止。属性的Stop属性值

TrainingProgressMonitor对象在单击停止按钮时更改为true。

Epoch = 0;迭代= 0;%遍历epoch。而epoch < numEpochs && ~monitor。停止epoch = epoch + 1;% Shuffle数据。洗牌(兆贝可);在小批上循环。而Hasdata (mbq) && ~monitor。停止迭代=迭代+ 1;读取小批数据。[X,T] = next(mbq);使用dlfeval和% modelLoss函数并更新网络状态。[loss,gradients,state] = dlfeval(@modelLoss,net,X,T);网状态=状态;确定基于时间的衰减学习率计划的学习率。learnRate = initialLearnRate/(1 +衰减*迭代);使用SGDM优化器更新网络参数。[net,velocity] = sgdmupdate(net,gradients,velocity,learnRate,momentum);更新培训进度监视器。recordMetrics(监控、迭代损失=损失);updateInfo(监控、时代=时代LearnRate = LearnRate);班长。进度= 100 * iteration/numIterations;结束结束

测试模型

通过将验证集上的预测结果与真实标签进行比较,检验模型的分类精度。

经过训练后,对新数据进行预测不需要标签。创建minibatchqueue对象,只包含测试数据的预测器:

为了忽略标签进行测试,将迷你批处理队列的输出数量设置为1。

指定用于训练的相同的小批大小。

属性预处理预测器

preprocessMiniBatchPredictors函数,在示例末尾列出。对于数据存储的单个输出,指定迷你批处理格式

“SSCB”(空间,空间,通道,批次)。

numOutputs = 1;mbqTest = minibatchqueue(augimdsValidation,numOutputs,...MiniBatchSize = MiniBatchSize,...MiniBatchFcn = @preprocessMiniBatchPredictors,...MiniBatchFormat =“SSCB”);

循环小批和分类图像使用modelPredictions函数,在示例末尾列出。

YTest = modelforecasts (net,mbqTest,classes);

评估分类准确率。

TTest = imdsValidation.Labels;精度=平均值(TTest == YTest)

准确度= 0.9750

在困惑图表中可视化预测。

次图confusionchart (tt)

对角线上的大值表示对相应类别的准确预测。非对角线上的大值表示对应类之间有很强的混淆。

万博1manbetx支持功能

模型损失函数

的modelLoss函数的参数为dlnetwork对象网,一小批输入数据X有相应的目标T并返回损失,关于可学习参数的损失梯度网,表示网络状态。要自动计算梯度,请使用dlgradient函数。

函数[loss,gradients,state] = modelLoss(net,X,T)通过网络转发数据。[Y,状态]= forward(net,X);计算交叉熵损失。损失=交叉熵(Y,T);计算相对于可学习参数的损失梯度。gradients = dlgradient(loss,net.Learnables);结束

模型预测函数

的modelPredictions函数的参数为dlnetwork对象网,一个minibatchqueue输入数据的兆贝可和网络类,并通过迭代中所有数据来计算模型预测minibatchqueue对象。函数使用onehotdecode函数来查找得分最高的预测班级。

函数Y = modelforecasts (net,mbq,classes) Y = [];在小批上循环。而hasdata(mbq) X = next(mbq);做预测。分数=预测(净,X);解码标签并附加到输出。标签= onehotdecode(分数,类,1)';Y = [Y;标签);结束结束

迷你批量预处理功能

的preprocessMiniBatch函数使用以下步骤预处理一小批预测器和标签:

对图像进行预处理

preprocessMiniBatchPredictors函数。从传入的单元格数组中提取标签数据,并沿着第二次维度连接到分类数组中。

One-hot将分类标签编码为数字数组。编码到第一个维度会产生一个与网络输出形状匹配的编码数组。

函数[X,T] = preprocessMiniBatch(dataX,dataT)预处理预测器。X = preprocessMiniBatchPredictors(dataX);从单元格和级联中提取标签数据。T = cat(2,dataT{1:end});单热编码标签。T = onehotencode(T,1);结束

小批量预测预处理函数

的preprocessMiniBatchPredictors函数通过从输入单元格数组中提取图像数据并将其连接到数值数组来预处理一小批预测器。对于灰度输入,在第四个维度上的连接将为每个图像添加第三个维度,以用作单个通道维度。

函数X = preprocessMiniBatchPredictors(dataX)%连接。X = cat(4,dataX{1:end});结束

的可学习参数dlnetwork对象

加载一个预先训练好的网络。

网=挤压网;

将网络转换为层图,删除输出层,并将其转换为dlnetwork对象。

lgraph = layerGraph(net);lgraph = removeLayers(“ClassificationLayer_predictions”);Dlnet = dlnetwork(lgraph);

的可学的的属性dlnetwork对象是一个包含网络可学习参数的表。该表在单独的行中包含嵌套层的参数。查看learnables表的前几行。

learnables = dlnet.Learnables;头(可学的)

层参数值__________________ _________ ___________________ "conv1" "Weights" {3x3x3x64 dlarray} "conv1" "Bias" {1x1x64 dlarray} "fire2-squeeze1x1" "Weights" {1x1x16 dlarray} "fire2-expand1x1" "Weights" {1x1x64 dlarray} "fire2-expand3x3" "Weights" {3x3x16x64 dlarray} "fire2-expand3x3" Bias" {1x1x64 dlarray} "fire2-expand3x3" "Bias" {1x1x64 dlarray}

要冻结网络的可学习参数,可以遍历可学习参数,并使用setLearnRateFactor函数。

因子= 0;numLearnables = size(learnables,1);为i = 1:numLearnables layerName = learnables.Layer(i);parameterName = learnables.Parameter(i);dlnet = setLearnRateFactor(dlnet,layerName,parameterName,factor);结束

要在训练时使用更新的学习率因子,必须将dlnetwork对象传递给自定义训练循环中的更新函数。例如,使用命令

[dlnet,velocity] = sgdmupdate(dlnet,gradients,velocity);

创建未初始化dlnetwork

创建一个未初始化dlnetwork没有输入层的对象。创建一个未初始化的dlnetwork当您还不知道网络输入的大小和格式时,例如dlnetwork嵌套在自定义层内。

定义网络层。该网络只有一个输入,没有连接到输入层。

layers = [convolution2dLayer(5,20) batchNormalizationLayer reluLayer fullyConnectedLayer(10) softmaxLayer];

创建一个未初始化dlnetwork.设置初始化选项假.

Dlnet = dlnetwork(图层,“初始化”、假);

检查网络是否未初始化。

dlnet。初始化

ans =逻辑0

该网络的可学习参数和状态参数没有进行初始化训练。要初始化网络,请使用初始化函数。

如果你想用的话dlnet方法,然后可以对其进行初始化初始化函数并提供示例输入。

如果你想用的话dlnet在自定义层中,您可以利用自动初始化。如果你使用自定义层内dlnetwork,然后dlnet初始化时父dlnetwork被构造(或者当父网络被初始化时,如果它被构造为未初始化的?dlnetwork).类训练的网络中使用自定义层trainNetwork函数,那么dlnet在训练时自动初始化。有关更多信息,请参见深度学习网络组成.

更多关于

万博1manbetx支持层

的dlnetwork函数支持下面列出的万博1manbetx层和自定义层,没有向前函数返回非空内存值。

| 层 | 描述 |

|---|---|

| 图像输入层将2-D图像输入到网络并应用数据规范化。 | |

| 三维图像输入层将三维图像或卷输入网络并进行数据规范化。 | |

| 序列输入层向网络输入序列数据。 | |

| 特征输入层将特征数据输入网络并进行数据规范化。当您拥有表示特征的数值标量数据集(没有空间或时间维度的数据)时,请使用此层。 |

| 层 | 描述 |

|---|---|

| 1-D卷积层对1-D输入应用滑动卷积滤波器。 | |

| 二维卷积层对二维输入应用滑动卷积滤波器。 | |

| 三维卷积层对三维输入应用滑动立方卷积滤波器。 | |

| 二维分组卷积层将输入通道分成组,并应用滑动卷积滤波器。使用分组卷积层进行通道可分离(也称为深度可分离)卷积。 | |

| 转置二维卷积层向上采样二维特征图。 | |

| 转置的三维卷积层向上采样三维特征图。 | |

| 全连接层将输入乘以权重矩阵,然后添加偏置向量。 |

| 层 | 描述 |

|---|---|

| 序列输入层向网络输入序列数据。 | |

| LSTM层学习时间序列和序列数据中时间步长之间的长期依赖关系。 | |

| LSTM投影层使用投影可学习权重学习时间序列和序列数据中时间步长之间的长期依赖关系。 | |

| 双向LSTM (BiLSTM)层学习时间序列或序列数据的时间步长之间的双向长期依赖关系。当您希望网络在每个时间步骤中都能从完整的时间序列中学习时,这些依赖关系非常有用。 | |

| GRU层学习时间序列和序列数据中时间步长之间的依赖关系。 | |

| 平坦层将输入的空间维度折叠为通道维度。 |

为lstmLayer,bilstmLayer,gruLayer对象,dlnetwork对象支持具有默认万博1manbetx值的层StateActivationFunction而且GateActivationFunction属性。

| 层 | 描述 |

|---|---|

| ReLU层对输入的每个元素执行阈值操作,其中任何小于零的值都被设置为零。 | |

| 泄漏的ReLU层执行阈值操作,其中任何小于零的输入值都乘以一个固定的标量。 | |

| 剪切的ReLU层执行阈值操作,其中任何小于零的输入值都被设置为零,任何高于零的输入值都被设置为零剪裁天花板被设定在那个裁剪的天花板上。 | |

| ELU激活层对正输入执行恒等运算,对负输入执行指数非线性。 | |

| 高斯误差线性单元(GELU)层根据输入在高斯分布下的概率对输入进行加权。 | |

| swish激活层对层输入应用swish函数。 | |

| 双曲正切(tanh)激活层对层输入应用tanh函数。 | |

| softmax层对输入应用一个softmax函数。 | |

| sigmoid层对输入应用sigmoid函数,使输出以(0,1)区间为界。 | |

| 函数层对层输入应用指定的函数。 |

| 层 | 描述 |

|---|---|

| 批处理归一层对每个通道的所有观测数据分别进行小批处理。为了加快卷积神经网络的训练并降低对网络初始化的敏感性,在卷积层和非线性层之间使用批量归一化层,如ReLU层。 | |

| 分组归一层对每个观测数据在分组的通道子集上单独归一小批数据。为了加快卷积神经网络的训练并降低对网络初始化的敏感性,在卷积层和非线性层之间使用组归一化层,如ReLU层。 | |

| 层归一化层对每个观测数据单独地在所有通道上归一小批数据。为了加快循环和多层感知器神经网络的训练,降低网络初始化的敏感性,在可学习层之后使用层归一化层,如LSTM和全连接层。 | |

| 信道局部响应(跨信道)归一层执行信道归一化。 |

| 层 | 描述 |

|---|---|

| dropout层以给定的概率随机地将输入元素设置为零。 | |

| 2-D作物层对输入应用2-D作物。 | |

|

STFT层计算输入的短时傅里叶变换。 |

|

CWT层计算输入的CWT。 |

|

MODWT层计算输入的MODWT和MODWT多分辨率分析(MRA)。 |

| 层 | 描述 |

|---|---|

| 1-D平均池化层通过将输入划分为1-D池化区域来执行下采样,然后计算每个区域的平均值。 | |

| 二维平均池化层通过将输入划分为矩形池化区域,然后计算每个区域的平均值来进行下采样。 | |

| 三维平均池化层通过将三维输入划分为立方池化区域进行下采样,然后计算每个区域的平均值。 | |

| 1-D全局平均池化层通过输出输入的时间或空间维度的平均值来执行下采样。 | |

| 2-D全局平均池化层通过计算输入的高度和宽度维度的平均值来执行下采样。 | |

| 三维全局平均池化层通过计算输入的高度、宽度和深度维度的平均值来执行下采样。 | |

| 1-D最大池化层通过将输入划分为1-D池化区域,然后计算每个区域的最大值来进行下采样。 | |

| 二维最大池化层通过将输入划分为矩形池化区域,然后计算每个区域的最大值来进行下采样。 | |

| 三维最大池化层通过将三维输入划分为立方池化区域,然后计算每个区域的最大值来进行下采样。 | |

| 1-D全局最大池化层通过输出输入的时间或空间维度的最大值来执行下采样。 | |

| 2-D全局最大池化层通过计算输入的高度和宽度维度的最大值来执行下采样。 | |

| 3-D全局最大池化层通过计算输入的高度、宽度和深度维度的最大值来执行下采样。 | |

| 2-D最大池化层将2-D最大池化层的输出解池。 |

| 层 | 描述 |

|---|---|

| 添加层按元素添加来自多个神经网络层的输入。 | |

| 乘法层将来自多个神经网络层的输入按元素进行乘法。 | |

| 深度连接层接受具有相同高度和宽度的输入,并沿着第三维(通道维)将它们连接起来。 | |

| 连接层接受输入并按照指定的维度连接它们。除了连接维度外,所有维度的输入都必须具有相同的大小。 |

扩展功能

C/ c++代码生成

使用MATLAB®Coder™生成C和c++代码。

使用注意事项和限制:

代码生成仅支持万博1manbetx

InputNames而且OutputNames属性。的

初始化的属性dlnetwork对象必须设置为true。您可以为

dlnetwork有矢量或图像序列输入。的手臂®计算,dlnetwork可以有序列和非序列输入层。对于英特尔®MKL-DNN,输入层必须是所有序列输入层。代码生成支持包括:万博1manbetxdlarray包含向量序列“CT”或“认知行为治疗”数据格式。dlarray包含的图像序列“SSCT”或“SSCBT”数据格式。多输入

dlnetwork使用异构输入层。对于RNN网络,不支持多输入。万博1manbetx

代码生成仅支持万博1manbetx

预测对象的功能。的dlarray输入预测方法必须为单数据类型。代码生成支持MIMO万博1manbetx

dlnetworks.要创建

dlnetwork对象进行代码生成,请参见为代码生成加载预训练的网络(MATLAB编码器).

GPU代码生成

使用GPU Coder™为NVIDIA®GPU生成CUDA®代码。

使用注意事项和限制:

代码生成仅支持万博1manbetx

InputNames而且OutputNames属性。的

初始化的属性dlnetwork对象必须设置为true。您可以为

dlnetwork有矢量和图像序列输入。代码生成支持包括:万博1manbetxdlarray包含向量序列“CT”或“认知行为治疗”数据格式。dlarray包含的图像序列“SSCT”或“SSCBT”数据格式。多输入

dlnetwork使用异构输入层。对于RNN网络,不支持多输入。万博1manbetx

代码生成仅支持万博1manbetx

预测对象的功能。的dlarray输入预测方法必须为单数据类型。代码生成支持万博1manbetx

dlnetwork用于cuDNN和TensorRT目标。不支持代码生成万博1manbetxdlnetwork为ARM马里目标。当目标TensorRT与

INT8精度,网络的最后一层(s)必须是asoftmaxLayer层。代码生成支持MIMO万博1manbetx

dlnetworks.要创建

dlnetwork对象进行代码生成,请参见为代码生成加载预训练的网络(GPU编码器).

版本历史

R2019b引入R2021a:dlnetwork状态值为dlarray对象

的状态的dlnetwork对象是一个包含网络中每一层的状态参数名称和值的表。

从R2021a开始,状态值为dlarray对象。此更改可以在使用时提供更好的支持万博1manbetxAcceleratedFunction对象。为了加速具有频繁变化输入值的深度学习函数,例如包含网络状态的输入,必须将频繁变化的值指定为dlarray对象。

在以前的版本中,状态值是数值数组。

在大多数情况下,您不需要更新您的代码。方法从状态值中手动提取数据,如果代码要求状态值为数值数组,则要再现前面的行为extractdata函数与dlupdate函数。

state = dlupdate(@extractdata,net.State);

Abrir比如

Tiene una versión modificada de este ejemplo。¿Desea abrir este ejemplo con sus modificaciones?

MATLAB突击队

Ha hecho clic en unenlace que对应一个este commando de MATLAB:

弹射突击队introduciéndolo en la ventana de commandos de MATLAB。Los navegadores web no permission comandos de MATLAB。

您也可以从以下列表中选择一个网站:

如何获得最佳的网站性能

选择中国站点(中文或英文)以获得最佳站点性能。其他MathWorks国家站点没有针对您所在位置的访问进行优化。