设计和实现控制技术来满足系统的目标

最优控制是一个动态系统的条件,满足设计目标。最优控制是通过控制法律,执行以下定义的最优标准。一些广泛使用的最优控制技术:

线性二次调节器(等)/线性二次高斯(LQG)控制

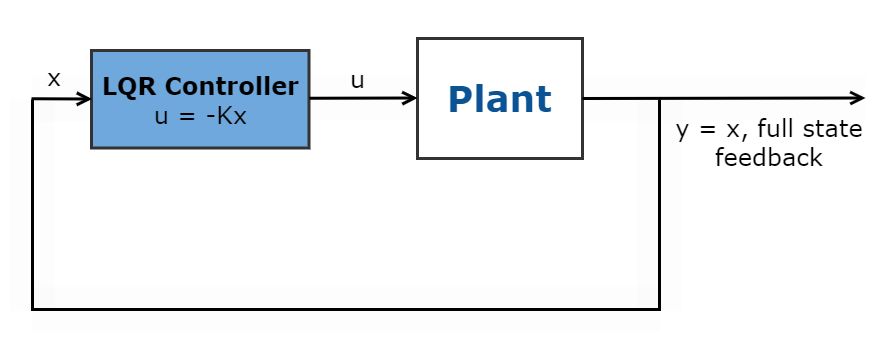

线性二次调节器(等)是一个完整的状态反馈最优控制律,\ (u = kx \),减少二次成本函数调节控制系统。

这个成本函数依赖于系统状态\ ((x) \)和控制输入\ ((u) \),如下所示。

$ $ J (u) = \ int_ {0} ^ {\ infty} (x ^ T Qx + u ^ T俄文+ 2 x ^ Tν)dt $ $

基于性能规格,权重因子Q, R, N设置为这个最优控制律来定义系统状态之间的适当平衡的监管和控制驱动的成本。

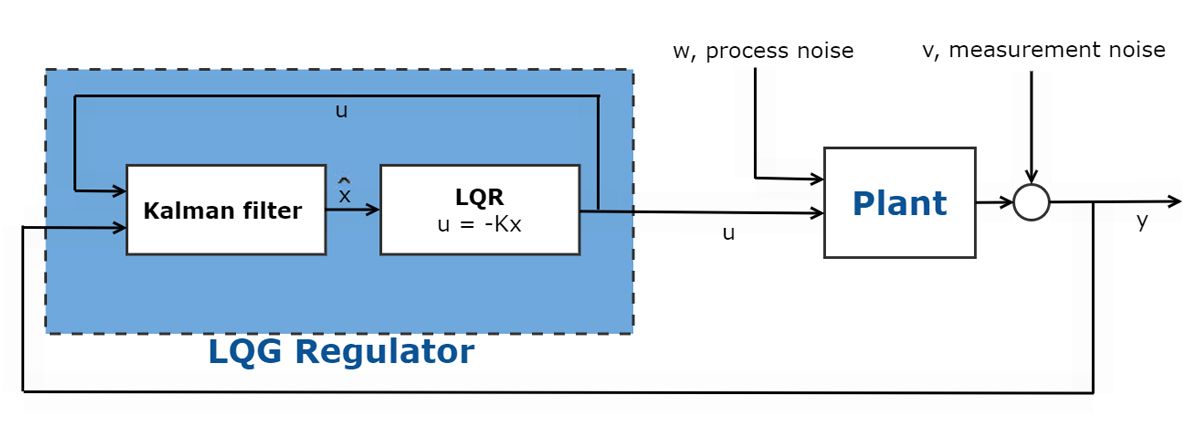

并非所有可访问状态测量在许多最优控制问题。在这些情况下,必须使用一个观察者估计。这通常是通过使用一个观察者如卡尔曼滤波器。一个卡尔曼滤波器结合等控制器构成一个线性二次高斯(LQG)控制器。

为了了解更多,看看这个MATLAB技术讨论等控制。

模型预测控制

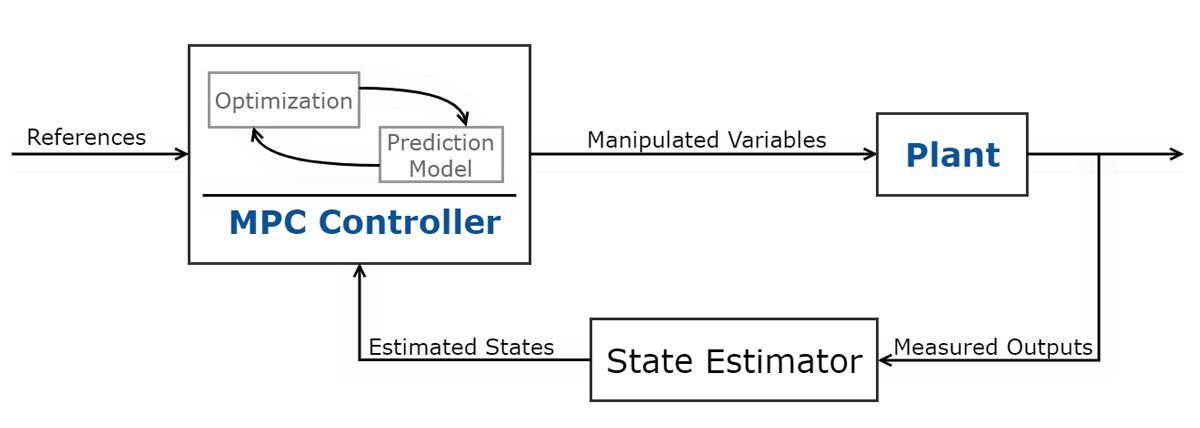

模型预测控制(MPC)是用来最小化代价函数的多输入多输出(MIMO)系统,输入和输出约束。这种最优控制技术使用一个系统模型来预测未来输出。使用预测植物输出,控制器解决了在线优化问题,即二次程序,以确定最优调整一个可以操作的变量驱动的预测输出参考。MPC变体包括适应性、gain-scheduled和非线性MPC控制器。MPC控制器使用的类型取决于预测模型(线性或非线性),约束(线性或非线性),成本函数(二次/ nonquadratic),吞吐量和样品时间。要了解更多,请查看这个MATLAB技术讨论对MPC变体。

微处理器技术的进步和高效算法增加了采用最优控制方法在应用,如自动驾驶、最佳地形跟踪在航空航天应用程序等。

要了解更多,请查看这个MATLAB技术系列在模型预测控制。

强化学习

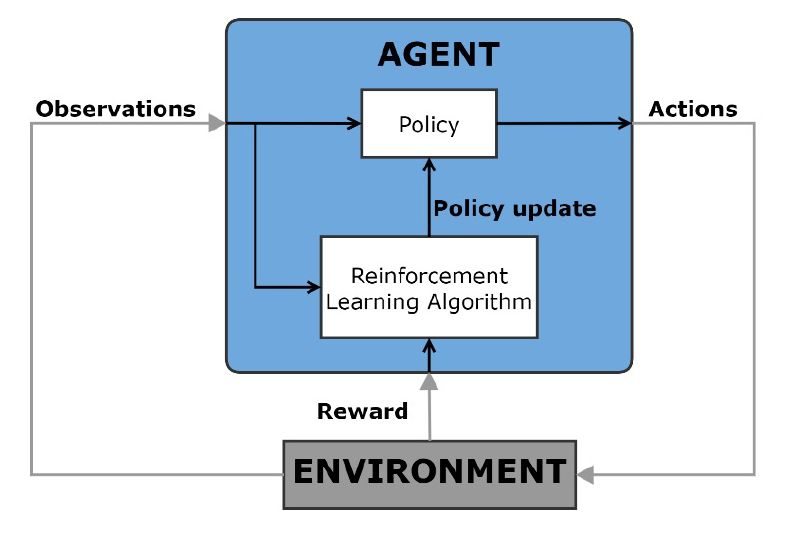

强化学习是机器学习技术在计算机代理通过反复试错学习最优行为与动态的交互环境。代理使用观察从环境中执行的一系列动作,目的是最大化代理的累积奖励指标任务。这个过程往往没有人工干预,也没有明确的规划。

这个最优控制方法可用于决策问题和非线性控制应用程序的替代使用传统的控制方法,如自动驾驶,机器人技术,调度问题,动态校准系统。

要了解更多,请查看这个MATLAB技术系列强化学习。

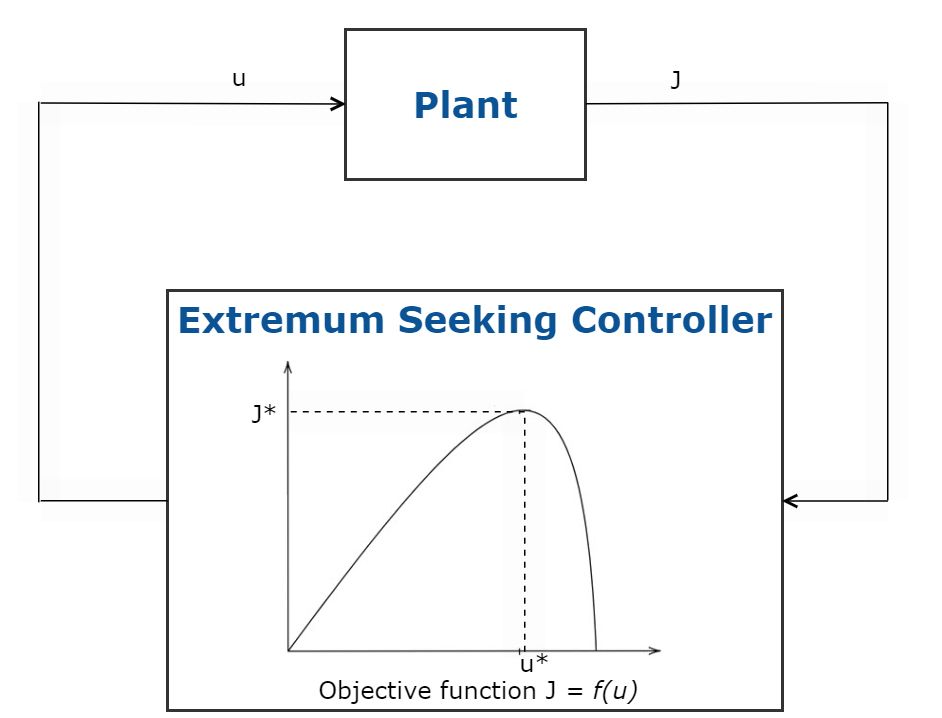

极值寻求控制

极值寻找是一种最优控制技术,自动调整控制系统参数使用模范自由实时优化一个目标函数最大化。这种方法不需要系统模型,可用于系统参数和扰动慢慢随时间变化。这种最优控制技术适用于稳定的系统能够容忍噪声控制,只有一小部分控制系统参数需要调整。

极值的应用寻求控制包括自适应巡航控制,最大功率点跟踪翻译(MPPT)太阳能阵列和防抱死制动系统(ABS)。

图5所示。极值寻求控制的示意图。

摘要针对合成

摘要合成是一个最优控制工具/技术设计对于单变量或分布式天线的输出反馈控制器实现健壮的性能和稳定性。相对于经典控制技术,如循环形成预示或PID调优,h∞更适合需要渠道之间的交叉耦合的多变量控制系统。

与h∞控制目标制定的标准化的闭环增益。摘要合成自动计算控制器通过最小化这个获得优化性能。这是有用的,因为许多控制目标可以表达的减少收益。这包括抗干扰性等目标,对噪声敏感,跟踪、循环形成,回路解耦和鲁棒稳定性。摘要合成的变化可以用于处理固定结构或全阶控制器。

为了了解更多,看看这个MATLAB技术讨论摘要针对合成。

下表比较了上述最优控制方法:

| 最优控制方法 | 是在运行时进行优化?(是/否) | 优化过程是如何工作的这个最优控制过程? | 它可以处理硬约束的?*(是/否) | 它使用基于模型的技术吗?(是/否) | 吞吐量是多少?(高/低) |

|---|---|---|---|---|---|

| 等/ LQG | 没有 | 使用封闭的解与已知的线性定常系统 | 没有 | 是的 | 高 |

| 隐式MPC(是的) | 使用一个预测模型,解决了一个在线优化问题计算最优控制行动 | 是的 | 是的 | 低(非线性MPC)、高(线性MPC) | |

| 明确的政策委员会(没有) | 解决方案优化问题为计算最优控制的行为离线计算 | 是的 | 是的 | 高 | |

| 强化学习 | 是的* * | 学习任务的最优行为最大化回报指标 | 没有* * * | 取决于训练算法 | 低(培训)、中(在推理) |

| 极值寻求控制 | 是的 | 扰乱和调整控制参数一个目标函数最大化 | 没有 | 没有 | 高 |

| 摘要针对合成 | 没有 | 自动计算一个控制器最小化规范化闭环增益 | 没有 | 是的 | 高 |

例子和如何

等/ LQG

模型预测控制

强化学习

极值寻求控制

摘要针对合成