このページの翻訳は最新ではありません。ここをクリックして,英語の最新版を参照してください。

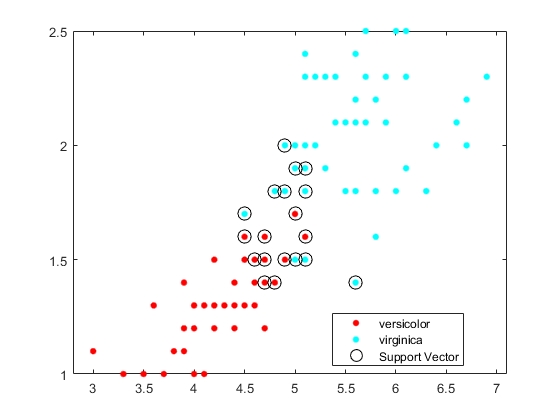

ClassificationSVM

1.クラスおよびバイナリ分類用のサポート ベクター マシン (支持向量机)

説明

ClassificationSVMは 1.クラスおよび 2.クラス学習用のサポートベクターマシン(SVM)分類器です。学習済みのClassificationSVM分類器には,学習データ,パラメーター値,事前確率,サポートベクターおよびアルゴリズムの実装情報が格納されます。これらの分類器を使用して,スコアから事後確率に変換する関数のあてはめ(fitPosteriorを参照)や新しいデータに対するラベルの予測(预测を参照) などのタスクを実行できます。

作成

ClassificationSVMオブジェクトの作成にはfitcsvmを使用します。

プロパティ

オブジェクト関数

紧凑的 |

機械学習モデルのサイズの縮小 |

compareHoldout |

新しいデータを使用して 2.つの分類モデルの精度を比較 |

crossval |

機械学習モデルの交差検証 |

丢弃支持向量万博1manbetx |

線形サポートベクターマシン(SVM)分類器のサポートベクターを破棄 |

边 |

サポート ベクター マシン (支持向量机)分類器の分類エッジを計算 |

fitPosterior |

サポートベクターマシン(SVM)分類器の事後確率のあてはめ |

incrementalLearner |

バイナリ分類サポート ベクター マシン (支持向量机)モデルのインクリメンタル学習器への変換 |

损失 |

サポートベクターマシン(SVM)分類器の分類誤差を計算 |

保证金 |

サポートベクターマシン(SVM)分類器の分類マージンを計算 |

partialDependence |

部分従属の計算 |

plotPartialDependence |

部分依存プロット(PDP)および個別条件付き期待値(ICE)プロットの作成 |

预测 |

サポートベクターマシン(SVM)分類器を使用して観測値を分類 |

resubEdge |

再代入分類エッジ |

石灰 |

本地可解释模型不可知解释(LIME) |

resubLoss |

再代入分類損失 |

resubMargin |

再代入分類マージン |

resubPredict |

学習済み分類器を使用した学習データの分類 |

的简历 |

サポートベクターマシン(SVM)分類器の学習を再開 |

沙普利 |

シャープレイ値 |

testckfold |

交差検証の反復により2つの分類モデルの精度を比較 |

例

詳細

アルゴリズム

SVMバイナリ分類アルゴリズムの数学的定式化については,バイナリ分類のサポートベクターマシンとサポートベクターマシンについてを参照してください。

南、<定义>、空の文字ベクトル ('')、空の 串(""),および< >失踪値は,欠損値を示します。fitcsvmは、欠損応答に対応するデータ行全体を削除します。fitcsvmは、重みの合計を計算するときに (以下の項目を参照)、欠損している予測子が 1.つ以上ある観測値に対応する重みを無視します。これにより、平衡なクラスの問題で不平衡な事前確率が発生する可能性があります。したがって、観測値のボックス制約がBoxConstraintに等しくならない可能性があります。fitcsvmは,重みまたは事前確率がゼロの観測値を削除します。2クラス学習でコスト行列 (

成本を参照)を指定した場合, で表されているペナルティを組み込むことにより、クラスの事前確率 p(之前を参照)がpcに更新されます。具体的には,

fitcsvmは以下のステップを完了します。を計算します。

更新された事前確率の合計が1になるようにpc*を正規化します。

Kはクラスの個数です。

コスト行列を既定値にリセットします。

事前確率がゼロのクラスに対応する観測値を学習データから削除します。

2クラス学習の場合,

fitcsvmは合計が 1.になるようにすべての観測値の重み (权重を参照) を正規化します。その後、観測値が属しているクラスの更新後の事前確率に重みの合計が等しくなるように、正規化された重みを再度正規化します。つまり、クラス Kの観測値 Jについて、重みの合計は次のようになります。ここで,wjは観測値jの正規化された重み,pc kはクラスkの更新された事前確率(前の項目を参照)です。

2クラス学習の場合,

fitcsvmは学習データの各観測値にボックス制約を割り当てます。観測値jのボックス制約の式は,次のようになります。ここでnは学習標本のサイズ,C0は初期のボックス制約 (名前と値のペアの引数

“BoxConstraint”を参照), は観測値jの重みの合計(前の項目を参照)です。“标准化”,没错と訛れと値のペアの引数“成本”、“之前”または“重量”を設定した場合,fitcsvmは対応する加重平均および加重標準偏差を使用して予測子を標準化します。つまり,fitcsvmは以下を使用して予測子 j(x)j)を標準化します。xjkは,予測子j(列)の観測値k(行)です。

pは学習データで予期される外れ値の比率であり,“离群分数”,pを設定したと仮定します。1クラス学習では,バイアス項の学習により,学習データの観測値のうち100

p% が負のスコアをもつようになります。2.クラス学習では"ロバスト学習"が行われます。この方式では,最適化アルゴリズムが収束すると,観測値のうち100

p%の削除が試行されます。削除された観測値は,勾配の大きいものに対応します。

予測子データにカテゴリカル変数が含まれている場合,一般にこれらの変数について完全なダミーエンコードが使用されます。各カテゴリカル変数の各レベルについて,1つずつダミー変数が作成されます。

PredictorNamesプロパティには、元の予測子変数名のそれぞれについて 1.つずつ要素が格納されます。たとえば、3.つの予測子があり、そのうちの 1.つは 3.つのレベルがあるカテゴリカル変数であるとします。この場合、PredictorNamesは元の予測子変数名が含まれている1行3列の文字ベクトルの细胞配列になります。ExpandedPredictorNamesプロパティには,ダミー変数を含む予測子変数のそれぞれについて1つずつ要素が格納されます。たとえば,3 つの予測子があり、そのうちの 1 つは 3 つのレベルがあるカテゴリカル変数であるとします。この場合、ExpandedPredictorNamesは予測子変数および新しいダミー変数の名前が含まれている 1.行 5.列の文字ベクトルの 单间牢房配列になります。同様に,

βプロパティには,ダミー変数を含む各予測子について1つずつベータ係数が格納されます。万博1manbetxSupportVectorsプロパティには,ダミー変数を含むサポートベクターの予測子の値が格納されます。たとえば,m 個のサポート ベクターと 3 つの予測子があり、そのうちの 1 つは 3 つのレベルがあるカテゴリカル変数であるとします。この場合、万博1manbetxSupportVectorsは N行 5.列の行列になります。Xプロパティには,はじめに入力されたときの状態で学習データが格納され,ダミー変数は含まれません。入力がテーブルの場合,Xには予測子として使用した列のみが格納されます。

テーブルで予測子を指定した場合,いずれかの変数に順序付きのカテゴリが含まれていると,これらの変数について順序付きエンコードが使用されます。

K個の順序付きレベルが変数に含まれている場合、k-1個のダミー変数が作成されます。j番目のダミー変数は、j までのレベルについては1、j + 1からkまでのレベルについては+1になります。

ExpandedPredictorNamesプロパティに格納されるダミー変数の名前は1番目のレベルを示し,値は+1になります。レベル 2,3,…,kの名前を含むk-1個の追加予測子名がダミー変数について格納されます。

どのソルバーも L1ソフト マージン最小化を実装します。

1クラス学習の場合,次の条件を満たすラグランジュ乗数α1,…,αnが推定されます。

参照

[1] 《统计学习的要素》,第二版。纽约:斯普林格,2008。

Scholkopf, B., J. C. Platt, J. C. shaw - taylor, A. J. Smola, R. C. Williamson。"估算高维分布的支持度"万博1manbetx神经第一版。,Vol. 13, Number 7, 2001, pp. 1443–1471.

克里斯汀尼尼,N。c。肖-泰勒。支持向量机和其他基于核的学习方法简介。万博1manbetx英国剑桥:剑桥大学出版社,2000年。

[4] Scholkopf, B.和A. Smola。核学习:支持向量机,正则化,优化和超越,自适应万博1manbetx计算和机器学习。麻省理工学院出版社,2002年。