이 번역 페이지는 최신 내용을 담고 있지 않습니다. 최신 내용을 영문으로 보려면 여기를 클릭하십시오.

모델링 및 예측

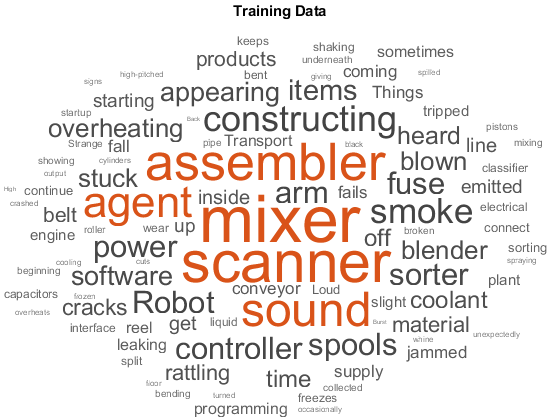

토픽모델단어을사용하여예측개발개발

LSA, LDA, 단어 임베딩 같은 머신러닝 기법과 모델을 사용하여 고차원 텍스트 데이터셋에서 군집을 찾고 특징을 추출할 수 있습니다. Text Analytics Toolbox™에서 생성한 특징은 다른 데이터 소스의 특징과 결합할 수 있습니다. 결합된 특징을 사용하여 텍스트, 숫자 등 다양한 유형의 데이터를 활용하는 머신러닝 모델을 빌드할 수 있습니다.

함수

도움말 항목

분류및모델링

- 단순 전처리 함수 만들기

이예제분석텍스트데이터를하고전처리함수만드는방법을보여줍니다줍니다。 - 분류를 위한 간단한 텍스트 모델 만들기

tog的words fords모델모델사용단어수로간단텍스트텍스트분류기를훈련시키는방법을보여줍니다줍니다줍니다줍니다。 - 다단어구문사용하여텍스트하기하기

n-gram빈도빈도빈도를사용텍스트를하는을보여줍니다줍니다。 - 토픽 모델을 사용하여 텍스트 데이터 분석하기

lda(잠재할당)토픽토픽모델하여데이터를하는방법을줍니다줍니다줍니다줍니다줍니다줍니다。 - LDA 모델의 토픽 수 선택하기

이 예제에서는 LDA(잠재 디리클레 할당) 모델에 적합한 토픽 수를 결정하는 방법을 보여줍니다. - 比较LDA求解器

此示例显示了如何通过比较拟合度的优点和适合模型所花费的时间来比较潜在的dirichlet分配(LDA)求解器。 - Visualize Document Clusters Using LDA Model

This example shows how to visualize the clustering of documents using a Latent Dirichlet Allocation (LDA) topic model and a t-SNE plot. - 可视化LDA主题相关性

此示例显示了如何在潜在的Dirichlet分配(LDA)主题模型中分析主题之间的相关性。 - 可视化LDA主题与文档标签之间的相关性

This example shows how to fit a Latent Dirichlet Allocation (LDA) topic model and visualize correlations between the LDA topics and document labels. - 동시발생 신경망 만들기

tog的words fords모델모델을동시신경망을방법을보여줍니다줍니다줍니다줍니다。

감성분석및추출

- 텍스트에 내포된 감성 분석하기

Vader(Valence Aware Away词典和情感推理者)알고리즘알고리즘을감성을하는방법보여줍니다줍니다줍니다줍니다줍니다줍니다 - 产生域特异性情感词典

此示例显示了如何使用10-K和10-Q财务报告生成词典来进行情感分析。 - 감성 분류기 훈련시키기

이예제주석있는긍정적적적적단어목록사전훈련훈련단어단어임베딩을을사용하여분류기분류기에게감성감성감성분석분석분석을을훈련훈련시키는방법을 - Extract Keywords from Text Data Using RAKE

This example shows how to extract keywords from text data using Rapid Automatic Keyword Extraction (RAKE). - 使用Textrank从文本数据中提取关键字

This example shows to extract keywords from text data using TextRank.

딥러닝

- 딥러닝을하여텍스트데이터하기하기

이예제딥러닝(LSTM)신경망신경망하여데이터를하는방법을보여줍니다줍니다줍니다。 - 使用卷积神经网络对文本数据进行分类

This example shows how to classify text data using a convolutional neural network. - 使用深度学习对失调的文本数据进行分类

此示例显示了如何使用转换后的数据存储使用深度学习网络将失调的文本数据分类。 - Sequence-to-Sequence Translation Using Attention

This example shows how to convert decimal strings to Roman numerals using a recurrent sequence-to-sequence encoder-decoder model with attention. - 使用深度学习的多标签文本分类

This example shows how to classify text data that has multiple independent labels. - 딥러닝을 사용하여 텍스트 생성하기(深度学习工具箱)

이예제텍스트생성(LSTM)신경망신경망을훈련훈련시키는방법줍니다줍니다줍니다。 - 오만과 편견 그리고 MATLAB

lastm신경망딥러닝딥러닝하도록하도록하여신경망신경망신경망신경망신경망신경망을훈련훈련시키는방법방법을보여보여줍니다줍니다。 - 使用深度学习的逐字文字生成

此示例显示了如何训练深度学习LSTM网络以生成单词的文字。 - 使用自定义培训循环对文本数据进行分类

This example shows how to classify text data using a deep learning bidirectional long short-term memory (BiLSTM) network with a custom training loop. - Generate Text Using Autoencoders

此示例显示了如何使用自动编码器生成文本数据。 - Define Text Encoder Model Function

This example shows how to define a text encoder model function. - 텍스트 디코더 모델 함수 정의하기

이 예제에서는 텍스트 디코더 모델 함수를 정의하는 방법을 보여줍니다. - 使用深度学习的语言翻译

此示例显示了如何使用重复的序列到序列编码器模型来训练德语到英语翻译器。

언어지원

- 언어고려사항

text Analytics工具箱text Analytics기능기능사용에정보정보정보정보。 - 일본어 지원

文本分析工具箱의의대한정보정보。 - 分析日本文本数据

This example shows how to import, prepare, and analyze Japanese text data using a topic model. - German Language Support

Information on German support in Text Analytics Toolbox. - 分析德语文本数据

This example shows how to import, prepare, and analyze German text data using a topic model.