基于深度学习的HRTF模型优化

今天的帖子来自Sunil Bharitkar,他在惠普实验室人工智能与新兴计算实验室(AIECL)领导音频/语音研究。他将讨论他的研究使用深度学习建模和合成头部相关传递函数(HRTF)使用MATLAB。这项工作已经发表在一篇IEEE论文中,链接在文章的底部。

今天我想讨论一下我的研究,这项研究的重点是一种新的方法来模拟如何使用深度学习从各个角度从任何方向合成声音。

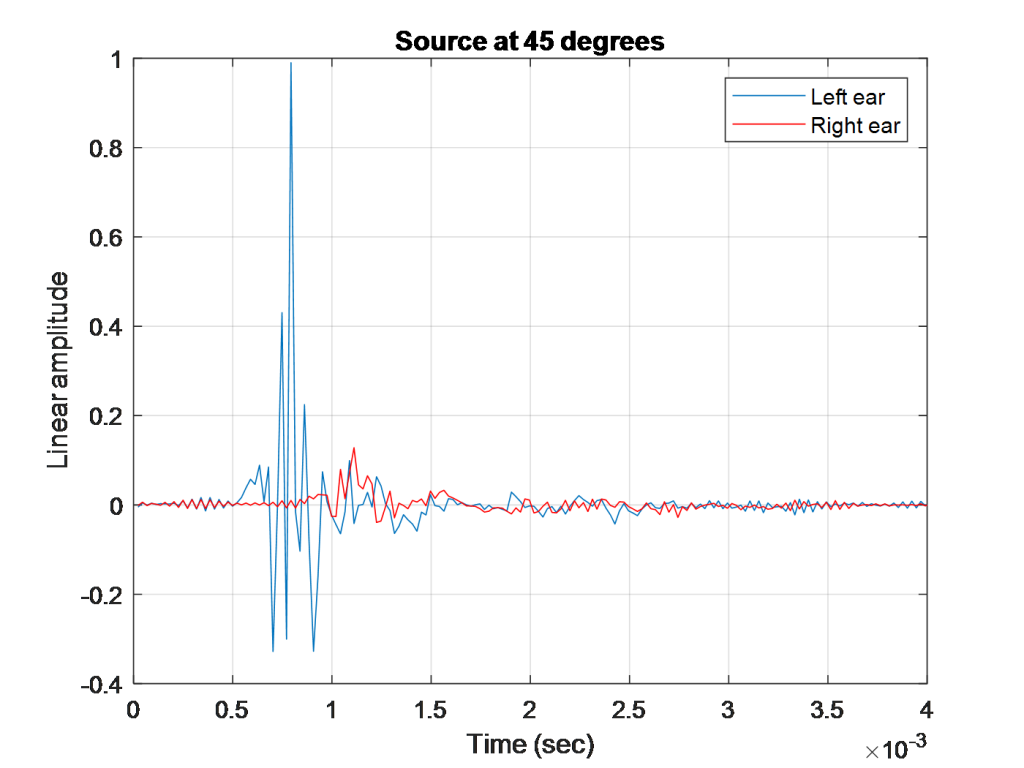

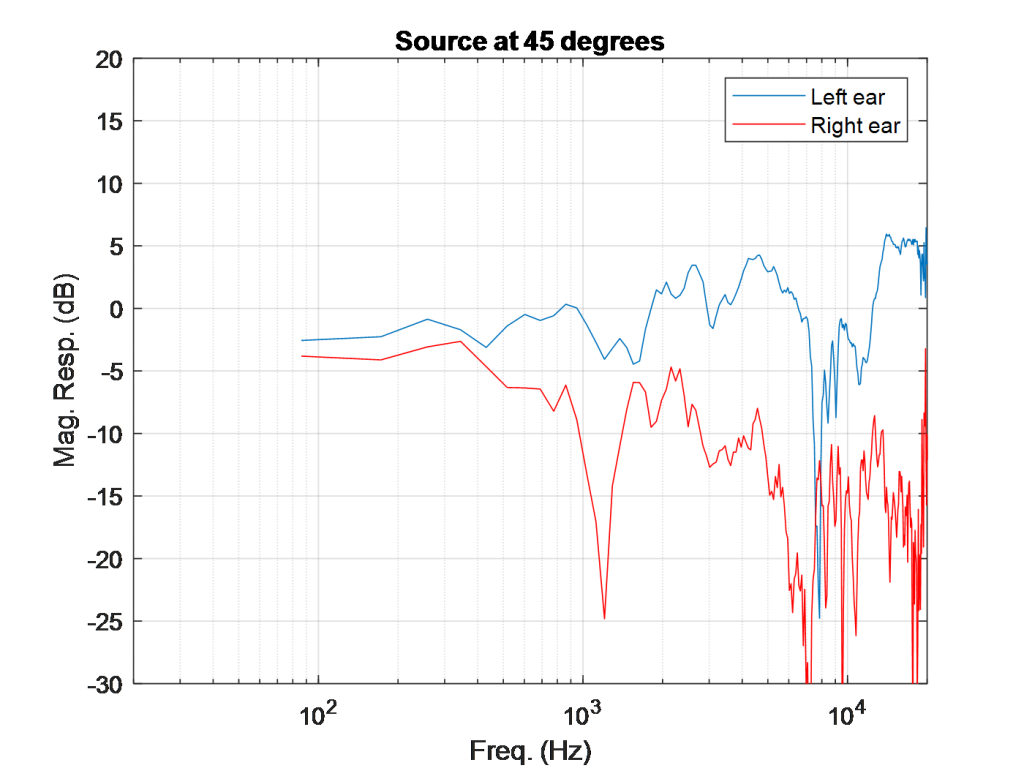

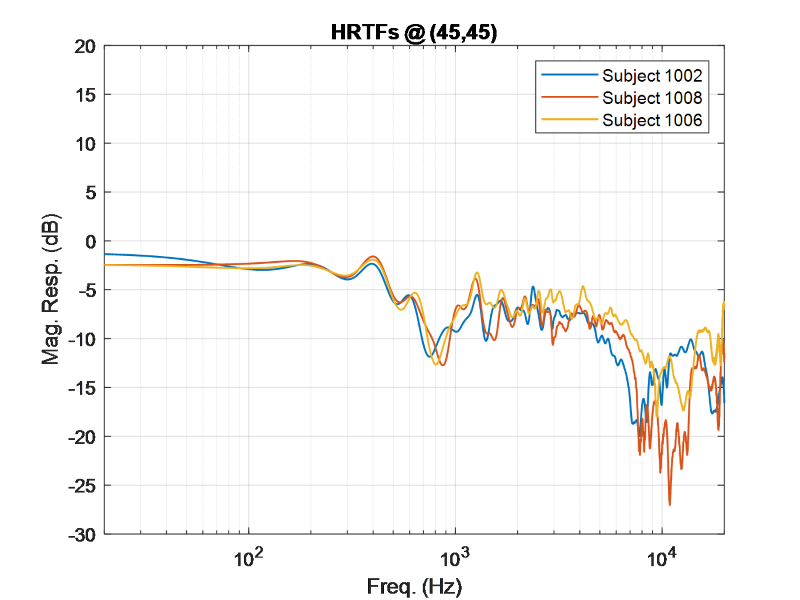

如果我们看这幅图,你可以看到,当一个声音从中心向45度的方向播放时,左耳的声音在这个角度的振幅比右耳的高。图中还嵌入了左右耳到达时间的差异,只有几毫秒的差异会对我们感知声音的位置产生重要影响。潜意识中,我们根据光谱和延迟的差异来解释声源的位置。将此与人类身后180度的声音进行比较:

在所有频率下,左右耳的频谱细节几乎相同,因为声源与双耳的距离基本相等。对于180度角的声源,到达时间的差异将无关紧要。这些差异(或缺乏差异)有助于我们确定声音来自何处。我们非常擅长在某些频率下定位声音,而在其他频率下则不太擅长*。这取决于声音的频率和位置。

*有趣的是,人类并不擅长确定声音是否在某些角度(例如,在混乱的圆锥体中)。如果我们感到困惑,我们能帮助定位的最好方法是移动我们的头,尝试优化左右耳之间的差异。我相信你现在很好奇,在家里非正式地尝试这个实验,并发出下一声火灾警报。

这项研究有许多应用,其中声音的定位是至关重要的。例如在电子游戏设计或虚拟现实中,声音必须与视频相匹配才能获得真正的沉浸式体验。为了让声音与视频匹配,我们必须在用户周围的期望位置匹配双耳的期望线索。这项研究的许多方面使其成为一个具有挑战性的问题:

我们的解剖结构和听觉是每个人都拥有的独特品质。要100%确信声音对人来说是完美的,唯一的办法就是在消声室中测量他们的个性化头部相关传递函数。这是非常不切实际的,因为我们的目标是为消费者提供最少的设置时间。这就引出了我研究的主要方面:

我们能否利用深度学习从各个角度近似HRTF,为大量听众提供真实体验?

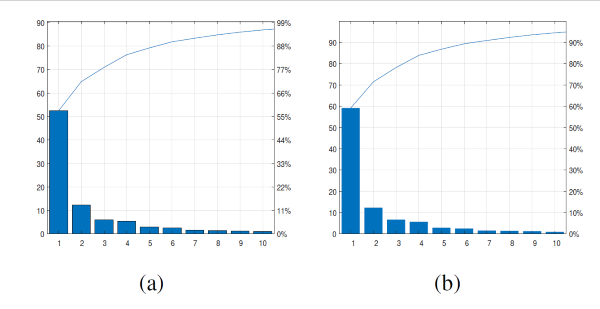

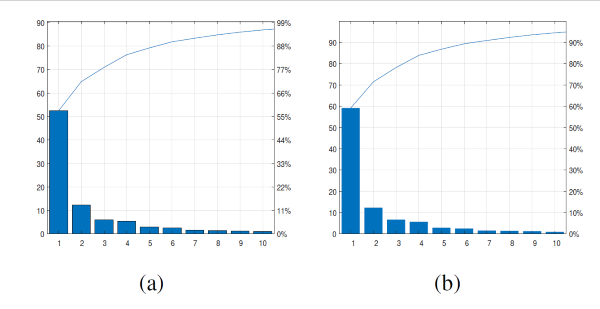

这个公式说的是,对于一个给定的用户,在一个给定的角度和特定的频率仓,比较实际振幅和网络的给定响应。对于PCA,我们发现10个PCs与我们的模型(如下图所示)是一个公平的比较,因为这使得这个大数据集的大部分能够被这个方法适当地覆盖。

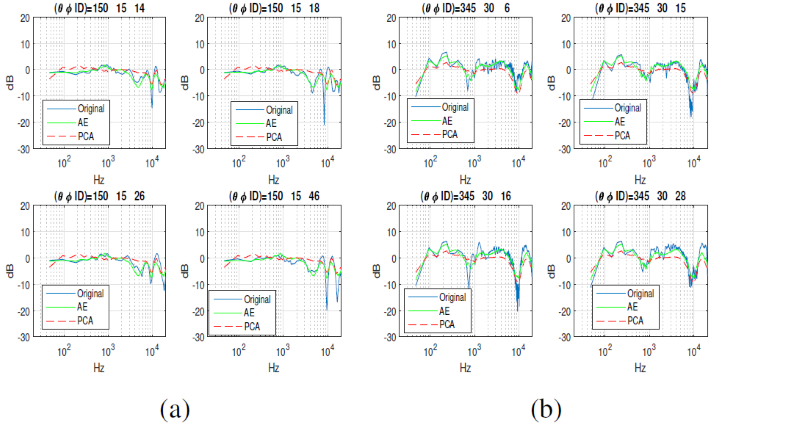

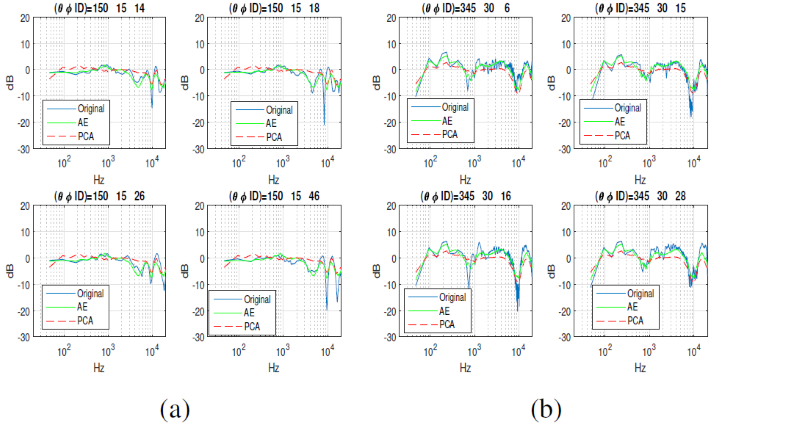

这是一个随机抽样的测试对象,为给定的角度,显示了AE方法与PCA之间的结果。你可以看到大部分情况下,你可以看到使用深度学习方法的显著改善。

这是一个随机抽样的测试对象,为给定的角度,显示了AE方法与PCA之间的结果。你可以看到大部分情况下,你可以看到使用深度学习方法的显著改善。

我创建的另一个很好的可视化效果清楚地显示了模型之间的差异:

我创建的另一个很好的可视化效果清楚地显示了模型之间的差异:

利用对数谱失真(dLS)对每个角度和每个用户进行了比较。绿框表示dLS低于PCA(越低越好)。蓝色部分表示基于PCA的方法优于自动编码器。正如您所看到的,在大多数情况下,AE编码器优于PCA。AE方法并不是100%的更好,但总体上肯定是一个更好的结果。

总之,我们展示了一种新的深度学习方法,与最先进的PCA方法相比,该方法表现出了巨大的主题库HRTFs的显著改进。我们正在继续对更大的数据集进行测试,并且我们在更大的数据集上继续看到可重复的结果,因此我们相信该方法能够产生一致的结果ts。如果你想了解更多关于这个主题的信息,请点击这里查看获得IEEE杰出论文奖的整篇论文的链接https://ieeexplore.ieee.org/document/8966196.

空间音频速成课程

这项研究的一个重要方面是声音的定位。这项研究在音频应用方面相当广泛,涉及到我们人类如何听到和理解声音来自何处。这一点因人而异,但通常与每个耳朵的延迟有关(低于~800 Hz)频率大于~800 Hz时,个体耳朵的频谱细节。这些主要是我们每天用来定位声音的线索(例如,参见鸡尾酒会效应).下图显示了头部相关脉冲响应在人体受试者两耳道入口处的消声室中测量(左图),以及傅里叶域表示,即。,与头部相关的传递函数(右图),该图显示了人类如何在可听频率中的特定位置(例如,向左和向前45度,仰角0度)通过双耳听到声音。 |

|

- 人类非常擅长识别声音的差异,这些差异会让用户觉得是虚假的,从而导致体验不真实。

- 不同的人在不同的角度,头部相关的传递函数是不同的。

- 每个HRTF取决于方向,并且对于任何给定的人,每个角度都会有所不同。

当前技术状态与我们的新方法

你可能会问"如果每个人都是不同的,为什么不取所有图的平均值并创建一个平均HRTF呢"对此,我说"如果取平均值,你就会得到一个平均值"深度学习能帮助我们提高平均水平吗?在我们的研究之前,进行这种分析的主要方法是对一组人进行HRTF建模的主成分分析。在过去,研究人员已经发现了5到6个组件,它们可以很好地概括大约20名受试者的小测试集([1][2][3]),但我们希望在更大的数据集和更多的角度上进行概括。我们将展示一种使用深度学习的新方法。我们将把它应用到一种自动编码器方法中,使用非线性函数学习HRTF的低维表示(潜在表示),然后使用另一个网络(本例中为广义回归神经网络)为了将角度映射到潜在表示。我们从1个隐藏层的自动编码器开始,然后通过使用验证度量(对数谱失真度量)进行贝叶斯优化,优化GRNN中隐藏层的数量和高斯RBF的扩展。下一节将详细介绍这种新方法。新方法

对于我们的方法,我们使用的是IRCAM数据集,该数据集由49个受试者组成,每个受试者有115个声音方向。我们将使用自动编码器模型,并将其与主成分分析模型进行比较(这是一个以PC数量为条件的线性最优解)我们将使用对数谱失真度量进行客观比较,以比较性能。数据设置

正如我提到的,数据集有49个主题,115个角度,每个HRTF都是通过计算1024个频率单元的FFT来创建的。问题陈述:我们能为每个角度找到一个HRTF表示,使该角度在所有主题上的拟合最大化吗?我们本质上是在所有主题上寻找最佳的泛化,例如e115个角中的每一个。- 我们还对深度学习模型使用了超参数调优(bayesopt)。

- 我们使用整个HRTF数据集(1024X5635)并训练自动编码器。隐藏层的输出为您提供了输入数据的紧凑表示。我们使用自动编码器,提取该表示,然后使用广义RNN将其映射回角度。我们还为每个角度和每个主题添加抖动或噪声。这将有助于网络推广ra而不是过度拟合,因为我们不是在寻找完美的答案(这不存在!),而是最适合所有测试对象的概括。

- 贝叶斯优化用于:

- 自动编码器网络的大小(层数)

- 抖动/噪声方差添加到每个角度

- GRNN的RBF扩散

后果

我们优化了对数谱失真以确定结果:

PCA顺序的选择(横坐标:PC编号,纵坐标:解释方差),(a)左耳(b)右耳)

使用ae模型(绿色)与真实HRTF(蓝色)进行左耳HRTF重建比较的例子。主成分分析模型被用作锚,用红色表示。

工具书类

[1] . D. Kistler,和F. Wightman,“基于主成分分析和最小相位重构的头部相关传递函数模型”,J. Acoust。Soc。阿米尔。,vol. 91(3), 1992, pp. 1637-1647.[2] W. Martens,“对感知方向的光谱线索的主成分分析和再合成”,《中国科学(d辑)》。广告样稿,亩。Conf., 1987, 274-281页。[3] J.Sodnik,A.Umek,R.Susnik,G.Bobojevic和S.Tomazic,“用主成分分析表示头部相关的传递函数”,声学,2004年11月。

|

克里夫角:克里夫·摩尔论数学与计算

克里夫角:克里夫·摩尔论数学与计算 罗兰关于MATLAB的艺术

罗兰关于MATLAB的艺术 用MATLAB进行图像处理

用MATLAB进行图像处理 Simulin万博1manbetxk上的家伙

Simulin万博1manbetxk上的家伙 深度学习

深度学习 开发区

开发区 斯图尔特的MATLAB视频

斯图尔特的MATLAB视频 标题背后

标题背后 本周文件交换精选

本周文件交换精选 物联网上的汉斯

物联网上的汉斯 赛马休息室

赛马休息室 创业公司、加速器和企业家

创业公司、加速器和企业家 MATLAB社区

MATLAB社区 MATLABユーザーコミュニティー

MATLABユーザーコミュニティー

评论

要留下评论,请点击在这里登录到您的MathWorks帐户或创建一个新帐户。