主要内容

随机表示

强化学习代理的随机参与者表示

描述

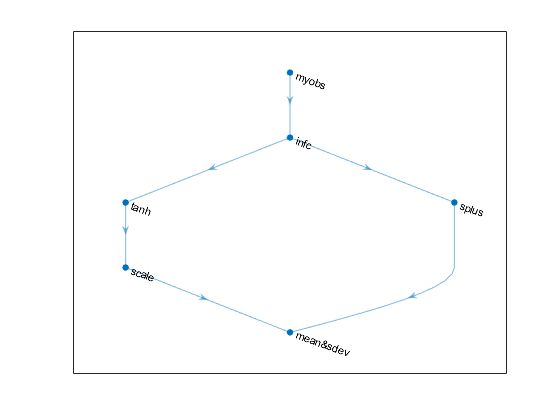

该对象实现了一个函数近似器,用于在强化学习代理内作为随机参与者。随机参与者将观察值作为输入,返回一个随机动作,从而实现具有特定概率分布的随机策略。在创建随机表示对象,使用它创建合适的代理,例如rlACAgent或rlPGAgent代理。有关创建表示的详细信息,请参阅创建策略和价值功能表示。

创建

句法

描述

离散动作空间随机演员

碟形演员= rlStochasticActorRepresentation (___那选择权)碟形演员使用附加设置选项选择权,这是一个rlRepresentationOptions此语法设置选项财产碟形演员到选择权输入参数。您可以将此语法与前面的任何输入参数组合一起使用。

连续作用空间高斯算子

接触= rlStochasticActorRepresentation (___那选择权)接触使用附加选择权选项集,它是一个rlRepresentationOptions此语法设置选项财产接触到选择权输入参数。您可以将此语法与前面的任何输入参数组合一起使用。

输入参数

属性

对象功能

rlACAgent |

演员,评论家强化学习代理 |

rlPGAgent |

策略梯度强化学习代理 |

rlPPOAgent |

近端政策优化强化学习代理 |

rlSACAgent |

软演员-评论家强化学习代理 |

getAction |

获得代理或演员表示给定的环境观测行动 |

例子

在R2020A中介绍