加载预定义的网格世界环境

强化学习工具箱™ 软件提供了几个预定义的网格世界环境,其中已定义了操作、观察、奖励和动态。您可以使用这些环境:

学习强化学习概念。

熟悉强化学习工具箱软件功能。

测试您自己的强化学习代理。

您可以加载以下预定义的MATLAB®使用rlPredefinedEnv作用

| 环境 | 代理任务 |

|---|---|

| 基本网格世界 | 通过从离散动作空间选择移动,在二维网格上从起始位置移动到目标位置{N,S,E,W}. |

| 瀑布网格世界 | 在具有未知确定性或随机动力学的较大二维网格上,从起始位置移动到目标位置。 |

有关网格世界环境属性的详细信息,请参见创建自定义网格世界环境.

您还可以加载预定义的MATLAB控制系统环境。有关更多信息,请参阅加载预定义的控制系统环境.

基本网格世界

基本网格世界环境是一个5乘5的二维网格,包含起始位置、终端位置和障碍物。该环境还包含从状态[2,4]到状态[4,4]的特殊跳跃。代理的目标是从起始位置移动到终端位置,同时避免障碍物并最大化总回报。

要创建基本的网格世界环境,请使用rlPredefinedEnv函数。此函数创建一个rlMDPEnv表示网格世界的对象。

env=rlPredefinedEnv(“基本世界”);

可以使用情节作用

代理位置是一个红色圆圈。默认情况下,代理在状态[1,1]下启动。

终点站的位置是一个蓝色的正方形。

障碍物是黑色的正方形。

地块(环境)

行动

代理可以向四个可能的方向之一移动(北、南、东或西)。

奖励

代理人收到以下奖励或处罚:

+10在[5,5]达到终点状态的奖励+5从州[2,4]跳到州[4,4]的奖励-1对每一其他行为的处罚

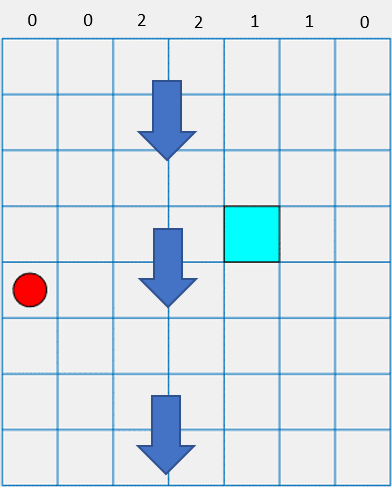

确定性瀑布网格世界

确定性瀑布网格世界环境是一个具有起始位置和终止位置的二维8×7网格。该环境包括一个瀑布,将代理推向网格底部。代理的目标是从起始位置移动到终端位置,同时最大化总报酬。

要创建确定性瀑布网格世界,请使用rlPredefinedEnv函数。此函数创建一个rlMDPEnv表示网格世界的对象。

env=rlPredefinedEnv(“水上世界”);

与基本网格世界一样,您可以可视化环境,其中代理是一个红色圆圈,终端位置是一个蓝色正方形。

地块(环境)

行动

代理可以向四个可能的方向之一移动(北、南、东或西)。

奖励

代理人收到以下奖励或处罚:

+10在[4,5]达到终点状态的奖励-1对每一其他行为的处罚

瀑布动力学

在这种环境中,瀑布将代理推向网格的底部。

瀑布的强度在不同的柱之间变化,如上图顶部所示。当代理移动到强度非零的柱中时,瀑布会将其向下推动指定的方块数。例如,如果代理从州[5,2]向东移动,则到达州[7,3]。

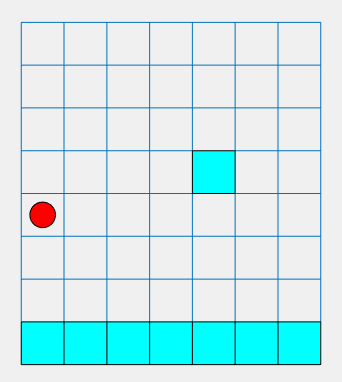

随机瀑布网格世界

随机瀑布网格世界环境是一个具有起始位置和终端位置的二维8×7网格。该环境包括一个瀑布,以随机强度将代理推向网格底部。代理的目标是在av时从起始位置移动到目标终端位置避免沿网格底部的惩罚终端状态,并最大化总奖励。

要创建随机瀑布网格世界,请使用rlPredefinedEnv函数。此函数创建一个rlMDPEnv表示网格世界的对象。

env=rlPredefinedEnv(“WaterwallGridWorld随机”);

与基本网格世界一样,您可以可视化环境,其中代理是一个红色圆圈,终端位置是一个蓝色正方形。

地块(环境)

行动

代理可以向四个可能的方向之一移动(北、南、东或西)。

奖励

代理人收到以下奖励或处罚:

+10在[4,5]达到终点状态的奖励-10到达网格底行中任何终端状态的惩罚-1对每一其他行为的处罚

瀑布动力学

在此环境中,瀑布以随机强度将代理推向网格底部。基线强度与确定性瀑布环境的强度相匹配。但是,在随机瀑布的情况下,代理体验指定强度的机会相等,比该强度高一级,或ne水平低于该强度。例如,如果代理从州[5,2]向东移动,则其到达州[6,3]、[7,3]或[8,3]的几率相等。