主要内容

rlMDPEnv

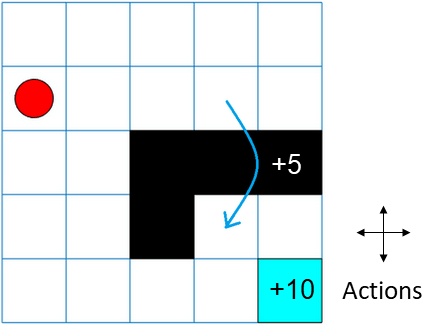

为强化学习创建马尔可夫决策过程环境

描述

马尔可夫决策过程(MDP)是一个离散时间随机控制过程。它提供了一个数学框架,用于在结果部分随机,部分受决策者控制的情况下建模决策。MDP对于研究使用强化学习解决的优化问题非常有用。使用rlMDPEnv在MATLAB中创建强化学习的Markov决策过程环境®.

性质

目标函数

getActionInfo |

从强化学习环境或代理获取行动数据规范 |

获取观测信息 |

从强化学习环境或代理获取观察数据规范 |

模拟 |

在指定环境中模拟经过培训的强化学习代理 |

火车 |

在特定环境中培训强化学习代理 |

验证环境 |

验证自定义强化学习环境 |

例子

在R2019a中引入