rlQValueRepresentation

强化学习主体的q值函数批判表示

描述

该对象实现了一个q值函数近似器,用于强化学习代理内的批评。q值函数是一个函数,它将观察-动作对映射到一个标量值,该标量值表示agent从给定的观察开始并执行给定的动作时所期望积累的总长期回报。因此,q值函数评论家需要观察和行动作为输入。在创建rlQValueRepresentation批评家,用它来创建一个依赖于q值函数批评家的代理,例如rlQAgent,rlDQNAgent,萨金特,rlDDPGAgent,或rlTD3Agent.有关创建表示的更多信息,请参阅创建策略和值函数表示.

创建

语法

描述

标量输出Q值批评家

评论家= rlQValueRepresentation (标签,observationInfo,actionInfo)评论家与离散的行动和观察空间从q值表标签.标签是A.rlTable对象,该对象包含一个表,该表包含尽可能多的行和尽可能多的列观测信息和行动信息特性评论家分别对应于输入observationInfo和actionInfo,必须是rlfinitesetspec.分别包含离散观测和动作空间规范的对象。

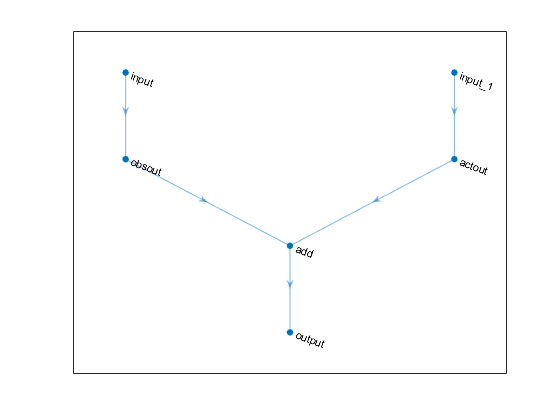

多输出离散动作空间Q值批评家

评论家= rlQValueRepresentation (网,observationInfo,actionInfo“观察”,obsName)评论家对于离散的动作空间.网是作为近似器使用的深度神经网络,必须只有观测值作为输入,而单个输出层具有尽可能多的可能离散动作的元素数量。该语法设置观测信息和行动信息特性评论家分别对应于输入observationInfo和actionInfo,包括观察和行动规范。在这里,actionInfo一定是一个rlfinitesetspec.包含离散动作空间规范的对象。观察名称obsName必须是的输入层的名称网.

选项

评论家= rlQValueRepresentation (___,选项)评论家使用附加选项集选项,这是一个rlRepresentationOptions此语法设置选项的属性评论家到选项输入参数。您可以将此语法与前面的任何输入参数组合一起使用。

输入参数

特性

对象的功能

rlDDPGAgent |

深度确定性策略梯度强化学习主体 |

rlTD3Agent |

双延迟深层确定性策略梯度强化学习agent |

rlDQNAgent |

深度q -网络强化学习代理 |

rlQAgent |

Q-learning强化学习代理 |

萨金特 |

SARSA强化学习代理 |

rlSACAgent |

软演员 - 评论家强化学习代理 |

GetValue. |

获得估计值函数表示 |

getMaxQValue |

通过离散动作空间获取Q值函数表示的最大状态值函数估计 |