resubLoss

通过resubstitution分类错误

语法

L = resubLoss(树)

L = resubLoss(树,名称,值)

L = resubLoss(树的子树,subtreevector)

(L, se) = resubLoss(树的子树,subtreevector)

[L, se, NLeaf] = resubLoss(树的子树,subtreevector)

[L, se, NLeaf bestlevel] = resubLoss(树的子树,subtreevector)

[L,...] = resubLoss(树,“子树”,subtreevector,名称,值)

描述

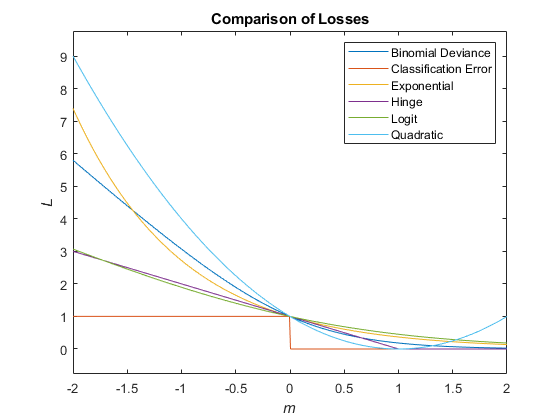

l= resubLoss(树)fitctree用于创建树。

l= resubLoss(树,名称,值)名称,值对参数。您可以按照任何顺序指定多个名称 - 值对参数Name1, Value1,…,的家。

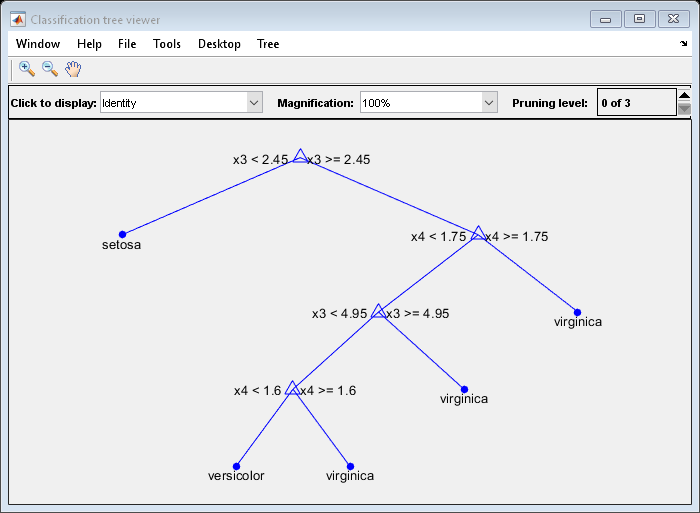

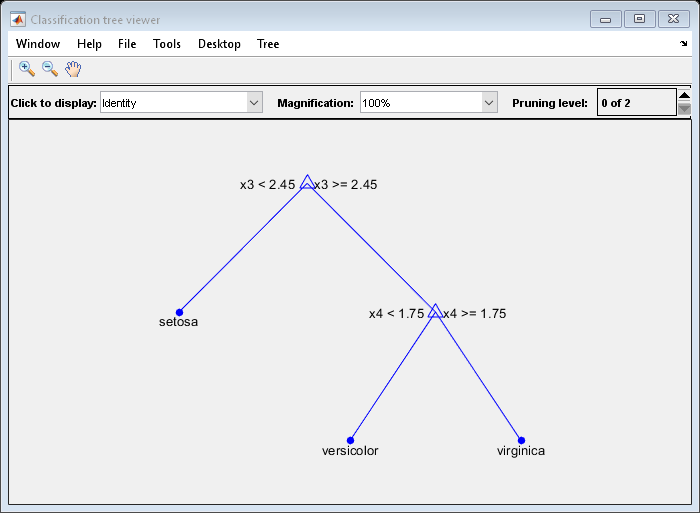

l= resubLoss(树,“子树”,subtreevector)subtreevector。

(返回分类错误的标准错误的向量。l,SE] = resubLoss(树,“子树”,subtreevector)

(返回修剪序列的树的叶节点的数的矢量。l,SE,NLeaf] = resubLoss(树,“子树”,subtreevector)

(属性中定义的最佳修剪级别l,SE,NLeaf,bestlevel] = resubLoss(树,“子树”,subtreevector)的TreeSize名称 - 值对。默认情况下,bestlevel是修剪水平,让损失降到最低的一个标准差之内的损失。

[L,...] = resubLoss(返回由一个或多个指定的附加选项的损失统计信息树,“子树”,subtreevector,名称,值)名称,值对参数。您可以按照任何顺序指定多个名称 - 值对参数Name1, Value1,…,的家。

输入参数

输出参数

|

分类损失中,矢量的长度 |

|

损失的标准误差,一个向量的长度 |

|

在修剪的子树的叶子(终端节点)的数量,一个向量的长度 |

|

其值依赖于的标量

|