kmeans

k聚类则

语法

描述

例子

训练k——聚类算法

集群的数据使用k-表示集群,然后绘制集群区域。

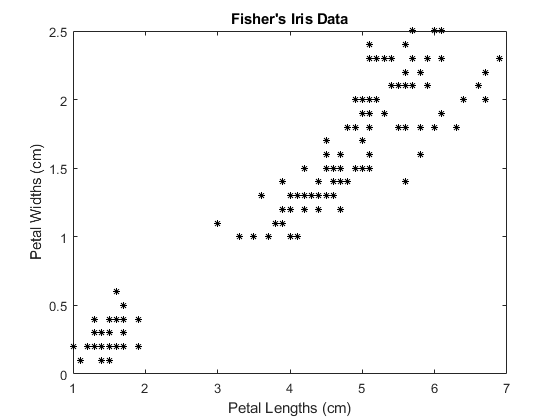

载入费雪的虹膜数据集。使用花瓣的长度和宽度作为预测因素。

负载fisheririsX =量(:,3:4);图;情节(X (: 1) X (:, 2),“k *’,“MarkerSize”5);标题“费舍尔的虹膜数据”;包含“花瓣长度(厘米)”;ylabel“花瓣宽度(cm)”;

较大的聚类似乎分成了一个低方差区域和一个高方差区域。这可能表明较大的星团是两个重叠的星团。

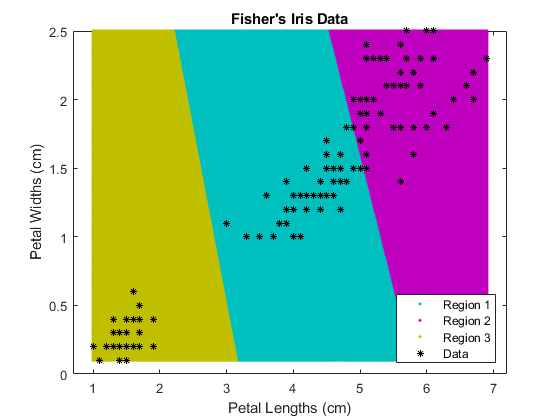

集群的数据。指定k= 3集群。

rng (1);%的再现性[idx C] = kmeans (X, 3);

kmeans使用k- mean++算法的质心初始化和平方欧几里得距离默认。通过设置值来搜索较低的局部最小值是一个很好的实践“复制”名称-值对的论点。

idx中预测的聚类指数向量是否与观测值相对应X.C是一个包含最终质心位置的3 × 2矩阵。

使用kmeans计算从每个质心到网格上各点的距离。要做到这一点,通过质心(C),并在网格上指向kmeans,并实现算法的一次迭代。

x1 = min (X(: 1)): 0.01:马克斯(X (: 1));x2 = min (X(:, 2)): 0.01:马克斯(X (:, 2));[x1G, x2G] = meshgrid (x1, x2);XGrid = [x1G (:), x2G (:));在plot上定义一个精细的网格idx2Region = kmeans (XGrid 3“麦克斯特”, 1“开始”C);

警告:在1次迭代中收敛失败。

%将网格中的每个节点分配到最近的质心

kmeans显示一个警告,说明算法没有收敛,这是您应该预料到的,因为软件只实现了一个迭代。

绘制集群区域。

图;gscatter (XGrid (: 1) XGrid (:, 2), idx2Region,...[0, 0.75, 0.75, 0.75, 0, 0.75, 0.75, 0.75, 0],“. .”);持有在;情节(X (: 1) X (:, 2),“k *’,“MarkerSize”5);标题“费舍尔的虹膜数据”;包含“花瓣长度(厘米)”;ylabel“花瓣宽度(cm)”;传奇(“地区1”,《区域2》,区域3的,“数据”,“位置”,“东南”);持有从;

将数据划分为两个集群

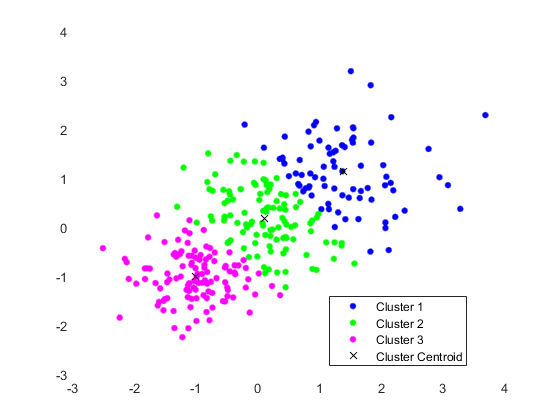

随机生成样本数据。

rng默认的;%的再现性X = [randn(100 2) * 0.75 +(100 2)的;randn(100 2) * 0.5的(100 2)];图;情节(X (: 1) X (:, 2),“。”);标题随机生成的数据的;

数据中似乎有两组。

将数据划分为两个集群,并在五个初始化中选择最佳的安排。显示最终输出。

选择= statset (“显示”,“最后一次”);[idx C] = kmeans (X, 2,“距离”,“cityblock”,...“复制”5,“选项”、选择);

重复1,3次迭代,总距离之和= 201.533。重复2,5次迭代,总距离之和= 201.533。重复3,3次迭代,总距离之和= 201.533。重复4,3次迭代,总距离之和= 201.533。重复5次,2次迭代,总距离之和= 201.533。距离的最佳总和= 201.533

默认情况下,软件将单独初始化复制k——+ +。

画出星团和星团中心。

图;情节(X (idx = = 1,1) X (idx = = 1、2),“r”。,“MarkerSize”, 12)在情节(X (idx = = 2, 1), X (idx = = 2, 2),“b”。,“MarkerSize”12)情节(C (: 1), C (:, 2),“kx”,...“MarkerSize”15岁的“线宽”3)传说(“集群1”,《集群2》,“重心”,...“位置”,“西北”)标题“集群分配和质心”持有从

您可以通过传递来确定集群的分离程度idx来轮廓.

使用并行计算的集群数据

聚集大型数据集可能需要时间,特别是在使用在线更新(默认设置)的情况下。如果您有一个并行计算工具箱™许可,并且设置了并行计算的选项,那么kmeans并行地运行每个集群任务(或复制)。而且,如果复制>1,则并行计算减少了收敛时间。

从高斯混合模型中随机生成一个大数据集。

μ= bsxfun (@times(20、30),(1:20)');%高斯混合均值rn30 = randn(30、30);σ= rn30 ' * rn30;%对称正定协方差Mdl = gmdistribution(μ、σ);定义高斯混合分布rng (1);%的再现性X =随机(Mdl, 10000);

Mdl是一个30-dimensionalgmdistribution模型有20个组件。X一个10000 × 30的数据矩阵是从哪里产生的Mdl.

指定并行计算的选项。

流= RandStream (“mlfg6331_64”);%随机数流选择= statset (“UseParallel”, 1“UseSubstreams”, 1...“流”、流);

输入参数“mlfg6331_64”的RandStream指定使用乘法滞后的斐波那契生成算法。选项是一个结构数组,其字段指定用于控制估计的选项。

使用以下方法聚类数据k——集群。指定有k=数据中20个簇,增加迭代次数。通常,目标函数包含局部最小值。指定10个复制以帮助查找更低的本地最小值。

抽搐;启动秒表计时器(sumd idx, C, D) = kmeans (X, 20,“选项”选项,“麦克斯特”, 10000,...“显示”,“最后一次”,“复制”10);

使用“local”配置文件启动并行池(parpool)…连接到6个工人。复制5,72次迭代,总距离之和= 7.73161e+06。重复1,64次迭代,总距离之和= 7.72988e+06。重复3,68次,总距离之和= 7.72576e+06。重复4,84次,总距离之和= 7.72696e+06。重复6,82次迭代,总距离之和= 7.73006e+06。重复7,40次迭代,总距离之和= 7.73451e+06。重复2,194次迭代,总距离之和= 7.72953e+06。重复9,105次迭代,总距离之和= 7.72064e+06。 Replicate 10, 125 iterations, total sum of distances = 7.72816e+06. Replicate 8, 70 iterations, total sum of distances = 7.73188e+06. Best total sum of distances = 7.72064e+06

toc终止秒表计时器

运行时间为61.915955秒。

命令窗口表示有6个工作人员可用。在您的系统中,工作人员的数量可能会有所不同。命令窗口显示每个复制的迭代次数和终端目标函数值。输出参数包含复制9的结果,因为它的距离总和最低。

将新数据分配给现有集群并生成C/ c++代码

kmeans执行k-表示聚类将数据划分为k集群。当您有一个新的数据集要集群时,您可以使用kmeans.的kmeans函数支持C/ c+万博1manbetx+代码生成,因此您可以生成接受训练数据并返回集群结果的代码,然后将代码部署到设备上。在这个工作流中,您必须通过训练数据,这些数据可能相当大。为了节省设备上的内存,您可以使用分离训练和预测kmeans和pdist2,分别。

使用kmeans在MATLAB®中创建集群并使用pdist2在生成的代码中将新数据分配给现有集群。对于代码生成,定义一个入口点函数,该函数接受集群质心位置和新的数据集,并返回最近的集群的索引。然后,生成入口点函数的代码。

生成C/ c++代码需要MATLAB®Coder™。

执行k聚类则

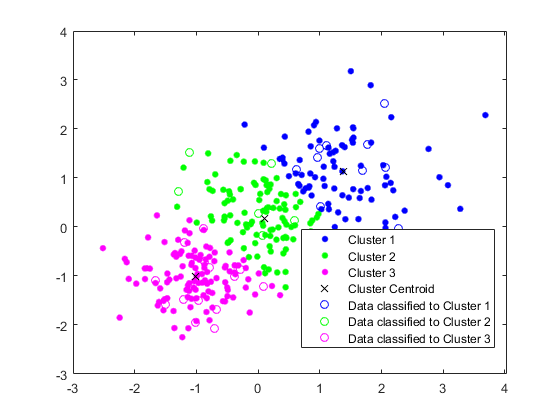

使用三个分布生成一个训练数据集。

rng (“默认”)%的再现性X = [randn(100 2) * 0.75 +(100 2)的;randn(100 2) * 0.5的(100 2);randn (100 2) * 0.75);

将训练数据分成三个聚类kmeans.

[idx C] = kmeans (X, 3);

画出星团和星团中心。

图gscatter (X (: 1), (:, 2), idx,“bgm”)举行在情节(C (: 1), C (:, 2),“kx”)传说(“集群1”,《集群2》,“集群3”,聚类质心的)

将新数据分配给现有集群

生成测试数据集。

Xtest = [randn(10, 2) * 0.75 +的(10,2);randn(10, 2) * 0.5的(10,2);randn (10, 2) * 0.75);

使用现有的集群对测试数据集进行分类。使用。找到每个测试数据点最近的质心pdist2.

[~, idx_test] = pdist2 (C Xtest“欧几里得”,“最小”1);

绘制测试数据并使用标记测试数据idx_test通过使用gscatter.

gscatter (Xtest (: 1) Xtest (:, 2), idx_test,“bgm”,“哦”)传说(“集群1”,《集群2》,“集群3”,聚类质心的,...“数据分类为第一组”,“数据分类为第二组”,...“数据分类为第3组”)

生成代码

生成C代码,将新数据分配给现有的集群。请注意,生成C/ c++代码需要MATLAB®Coder™。

定义一个入口点函数名为findNearestCentroid它接受质心位置和新数据,然后通过使用pdist2.

添加% # codegen编译器指令(或pragma)到函数签名后的入口点函数,以指示您打算为MATLAB算法生成代码。添加此指令将指示MATLAB代码分析器帮助您诊断和修复在代码生成期间可能导致错误的违规。

类型findNearestCentroid%显示findNearestCentroid.m的内容

函数idx = findNearestCentroid(C,X) %#codegen [~,idx] = pdist2(C,X,'欧几里得','最小',1);找到最近的质心

注意:如果你点击这个页面右上角的按钮,并在MATLAB®中打开这个示例,那么MATLAB®将打开示例文件夹。这个文件夹包括入口点函数文件。

使用以下命令生成代码codegen.因为C和c++都是静态类型语言,所以必须在编译时确定入口点函数中所有变量的属性。的输入的数据类型和数组大小findNearestCentroid,传递一个MATLAB表达式,该表达式表示具有特定数据类型和数组大小的值集,使用arg游戏选择。有关详细信息,请参见为代码生成指定可变大小参数.

codegenfindNearestCentroidarg游戏{C, Xtest}

codegen生成MEX函数findNearestCentroid_mex与平台相关的扩展。

验证生成的代码。

myIndx = findNearestCentroid (C, Xtest);myIndex_mex = findNearestCentroid_mex (C, Xtest);verifyMEX = isequal (idx_test myIndx myIndex_mex)

verifyMEX =逻辑1

isequal返回逻辑1 (真正的),这意味着所有的输入都是相等的。比较证实了pdist2函数,findNearestCentroid函数,而MEX函数返回相同的索引。

您还可以使用GPU编码器™生成优化的CUDA®代码。

cfg = coder.gpuConfig (墨西哥人的);codegen配置cfgfindNearestCentroidarg游戏{C, Xtest}

有关代码生成的更多信息,请参见通用代码生成工作流.有关GPU编码器的更多信息,请参见开始使用GPU编码器(GPU编码器)和万博1manbetx支持功能(GPU编码器)。

输入参数

X- - - - - -数据

数字矩阵

数据,指定为数字矩阵。的行X对应观察值,列对应变量。

如果X是数字向量吗kmeans把它当作n-by-1数据矩阵,不管它的方向。

该软件将南年代X删除丢失的数据并删除X至少包含一个南.删除行X减少样本量。的kmeans函数返回南获取输出参数中相应的值idx.

数据类型:单|双

k- - - - - -数量的集群

正整数

数据中的集群数量,指定为正整数。

数据类型:单|双

名称-值对的观点

指定可选的逗号分隔的对名称,值参数。的名字参数名和价值为对应值。的名字必须出现在引号内。可以以任意顺序指定多个名称和值对参数Name1, Value1,…,的家.

“距离”、“余弦”,“复制”,10日,“选项”,statset (UseParallel, 1)指定余弦距离,10以不同的起始值复制集群,并使用并行计算。

“显示”- - - - - -要显示的输出水平

“关闭”(默认)|“最后一次”|“通路”

要在命令窗口中显示的输出级别,指定为由逗号分隔的对组成“显示”以及下列选项之一:

“最后一次”—显示最后一次迭代的结果“通路”—显示每次迭代的结果“关闭”——显示什么

例子:“显示”、“最后”

“距离”- - - - - -距离度量

“sqeuclidean”(默认)|“cityblock”|的余弦|“相关”|“汉明”

距离度量,p维空间,用于最小化,指定为由逗号分隔的对组成“距离”和“sqeuclidean”,“cityblock”,的余弦,“相关”,或“汉明”.

kmeans为支持的距离度量以不同的方式计算质心集群。万博1manbetx该表总结了可用的距离度量。在公式,x是一种观察(即一排X),c为质心(行向量)。

| 距离度量 | 描述 | 公式 |

|---|---|---|

“sqeuclidean” |

欧几里得距离的平方(默认)。每个质心都是该簇中各点的均值。 |

|

“cityblock” |

绝对差的和,即l1的距离。每个质心是该集群中各点的分量中值。 |

|

的余弦 |

1减去点之间夹角的余弦值(作为向量)。每个质心是该聚类中的点的均值,将这些点归一化为单位欧几里得长度。 |

|

“相关” |

一减去点之间的样本相关性(作为值的序列处理)。每个质心是该聚类中各点的分量均值,对这些点进行中心和归一化,使其均值和单位标准差为零。 |

在哪里

|

“汉明” |

这个度量仅适用于二进制数据。 它是不同位的比例。每个质心是该集群中各点的分量中值。 |

在哪里我为指标函数。 |

例子:“距离”、“cityblock”

“麦克斯特”- - - - - -最大迭代次数

One hundred.(默认)|正整数

最大迭代次数,由逗号分隔对组成“麦克斯特”一个正整数。

例子:麦克斯特,1000年

数据类型:双|单

“OnlinePhase”- - - - - -在线更新标志

“关闭”(默认)|“上”

在线更新标志,指定为逗号分隔对,由“OnlinePhase”和“关闭”或“上”.

如果OnlinePhase是在,然后kmeans除批量更新阶段外,还执行在线更新阶段。对于大型数据集来说,在线阶段可能会很耗时,但可以保证解决方案是距离标准的局部最小值。换句话说,软件找到一个数据分区,在这个分区中,将任何一个单点移动到不同的集群中,都会增加距离的总和。

例子:“OnlinePhase”,“上”

“选项”- - - - - -为最小化拟合准则而控制迭代算法的选项

[](默认)|返回的结构数组statset

用于控制最小化拟合准则的迭代算法的选项,指定为由逗号分隔的对组成“选项”和返回的结构数组statset.万博1manbetx结构数组支持的字段指定控制迭代算法的选项。

该表总结了受支持的字段。万博1manbetx注意,受支持的字段需要Par万博1manbetxallel Computing Toolbox™。

| 场 | 描述 |

|---|---|

“流” |

一个

在本例中,使用与并行池相同大小的单元格数组。如果并行池未打开,则 |

“UseParallel” |

|

“UseSubstreams” |

设置为真正的并行计算以可复制的方式并行计算默认值是假.若要重复计算,请设置流到允许子流的类型:“mlfg6331_64”或“mrg32k3a”. |

为了确保更可预测的结果,使用parpool并在调用之前显式地创建并行池kmeans和设置“选项”,statset (UseParallel, 1).

例子:“选项”,statset (UseParallel, 1)

数据类型:结构体

“复制”- - - - - -使用新的初始群集质心位置重复群集的次数

1(默认)|正整数

使用新的初始集群质心位置重复集群的次数,指定为逗号分隔的对组成“复制”和一个整数。kmeans返回最低的解sumd.

你可以设置“复制”方法的值可以隐式地提供一个3-D数组“开始”名称-值对的论点。

例子:“复制”,5

数据类型:双|单

“开始”- - - - - -群集初始质心位置的选择方法

“+”(默认)|“集群”|“样本”|“统一”|数字矩阵|数字数组

选择初始群集质心位置的方法(或种子),指定为逗号分隔的对,由“开始”和“集群”,“+”,“样本”,“统一”,数字矩阵或数字数组。该表总结了选择种子的可用选项。

| 价值 | 描述 |

|---|---|

“集群” |

对随机的10%子样本执行初步聚类阶段 如果10%的随机子样本中的观测数小于 |

“+”(默认) |

选择k通过实现k——+ +算法用于集群中心初始化。 |

“样本” |

选择k观察从X在随机的。 |

“统一” |

选择k点的范围均匀地随机分布X.对汉明距离无效。 |

| 数字矩阵 | k——- - - - - -p质心起始位置矩阵。的行开始对应于种子。软件的推断k从第一个维度开始,所以你可以通过[]为k. |

| 数字数组 | k——- - - - - -p——- - - - - -r质心起始位置数组。每页的行对应种子。第三个维度调用集群例程的复制。页面j包含用于复制的种子集j.该软件推断复制的数量(由“复制”名称-值对参数)从第三维的大小。 |

例子:“开始”、“样本”

数据类型:字符|字符串|双|单

输出参数

更多关于

k聚类则

k - means聚类,或劳埃德算法[2],是一种迭代的数据分区算法n观察结果正好是k由质心定义的簇,其中k在算法开始之前选择。

算法进行如下:

k——+ +算法

的k——+ +算法用启发式方法寻找质心种子k——集群。根据亚瑟和瓦西里维茨基的说法[1],k-means++提高了Lloyd 's算法的运行时间,以及最终解决方案的质量。

的k-means++算法选择种子如下,假设集群数量为k.

从数据集中均匀随机选取一个观测值,X.所选择的观测是第一个质心,并表示c1.

计算从每个观测到的距离c1.表示距离cj和观察米作为 .

选择下一个质心,c2随机从X的概率

选择中心j:

计算从每个观测到每个质心的距离,并将每个观测分配到其最近的质心。

为米= 1,…,n和p= 1,…,j- 1,选择质心j随机从X的概率

在哪里Cp所有观测值的集合是否最接近质心cp和x米属于Cp.

也就是说,选择每个后续中心的概率与它自身到已经选择的最近中心的距离成正比。

重复步骤4直到k选上的重心。

亚瑟和Vassilvitskii[1]通过对几个集群方向的模拟研究来证明k-means++实现更快的收敛到一个更低的簇内,平方和点到簇心的距离比Lloyd的算法。

算法

kmeans采用两阶段迭代算法最小化点到质心距离的和,求和k集群。第一阶段使用批量更新,每次迭代包括将点全部重新分配到它们最近的簇心,然后重新计算簇心。这个阶段有时不收敛于局部最小解。也就是说,在数据的分区中,将任何一个点移动到不同的集群中,都会增加距离的总和。这对于小数据集来说更有可能。批处理阶段是快速的,但可能只近似于作为第二阶段起点的解决方案。

第二阶段使用在线更新,如果这样做可以减少距离的总和,那么将单独重新分配点,并且在每次重新分配后重新计算聚类质心。在此阶段的每个迭代包含一次遍历所有点。这个相位收敛到一个局部最小值,尽管可能有其他具有更小的总距离和的局部最小值。一般来说,寻找全局最小值是通过穷尽地选择起始点来解决的,但是使用几个随机起始点的重复通常会得到一个全局最小值的解。

如果您启用

UseParallel选项选项和复制> 1,然后每个工蜂并行选择种子和集群。

参考文献

亚瑟,大卫和塞吉·瓦西里维茨基。" K-means++:小心播种的好处"SODA ' 07:第十八届ACM-SIAM年度离散算法研讨会论文集.2007年,页1027 - 1035。

[2] Lloyd, Stuart P. < PCM中的最小二乘量化>IEEE信息理论汇刊.1982年第28卷,129-137页。

g.a. F. Seber多变量的观察.John Wiley & Sons, Inc., 1984。

[4] Spath, H。聚类剖析与分析:理论,FORTRAN程序,实例.J.戈德施密特(J. Goldschmidt)翻译。纽约:霍尔斯特德出版社,1985年。

扩展功能

高大的数组

使用具有大于内存容量的行数的数组进行计算。

使用注意事项及限制:

万博1manbetx支持的语法是:

idx = kmeans (X, k)[idx C] = kmeans (X, k)[idx C sumd] = kmeans (X, k)(___) = kmeans(___、名称、值)

万博1manbetx受支持的名称-值对参数及其区别如下:

“显示”—默认值为“通路”.“麦克斯特”“选项”—仅万博1manbetx支持“TolFun”创建的结构数组的字段statset.的默认值“TolFun”是1的军医.的kmeans函数使用的值“TolFun”为点到质心距离的簇内和的终止容差。例如,可以指定“选项”,statset (e-8 TolFun, 1).“复制”“开始”——万博1manbetx只支持“+”,“样本”,以及一个数字数组。

有关更多信息,请参见用于内存不足数据的高数组(MATLAB)。

C / c++代码生成

使用MATLAB®Coder™生成C和c++代码。

使用注意事项及限制:

如果

开始方法采用随机选择,初始质心簇位置可能与MATLAB不匹配®.如果行数

X是固定的,代码生成不删除行X包含一个南.簇心位置在

C可以有不同于MATLAB的顺序。在本例中,集群索引在idx有相应的差异。如果您提供

显示,它的价值必须是“关闭”.如果您提供

流,它必须是空的UseSubstreams必须假.当你设置

UseParallel选项真正的:有些计算可以并行执行,即使

复制是1.对于大数据集,当复制是1,考虑设置UseParallel选项真正的.kmeans使用parfor创建在受支持的共享内存多核平台上并行运行的循环。万博1manbetx并行运行的循环可能比在单个线程上运行的循环更快。如果您的编译器不支持开放多处理(OpenMP)应用程万博1manbetx序接口或禁用OpenMP库,MATLAB编码器™将parfor循环,为循环。要查找支持的编译万博1manbetx器,请参见万博1manbetx支持编译器.

为了在您部署生成代码的设备上节省内存,您可以使用

kmeans和pdist2,分别。使用kmeans在MATLAB中创建集群并使用pdist2在生成的代码中将新数据分配给现有集群。对于代码生成,定义一个入口点函数,该函数接受集群质心位置和新的数据集,并返回最近的集群的索引。然后,生成入口点函数的代码。例如,请参见将新数据分配给现有集群并生成C/ c++代码.从R2020a开始,

kmeans返回整数类型(int32)索引,而不是双精度索引,以生成独立的C/ c++代码。因此,当您使用单精度输入时,该函数允许更严格的单精度支持。万博1manbetx对于MEX代码生成,该函数仍然返回双精度索引以匹配MATLAB行为。

自动并行支持万博1manbetx

使用并行计算工具箱™自动并行运行计算,加速代码。

要并行运行,请设置“UseParallel”选项真正的.

设置“UseParallel”字段的选项结构真正的使用statset并指定“选项”调用此函数时的名称-值对参数。

例如:“选项”,statset (UseParallel,真的)

有关更多信息,请参见“选项”名称-值对的论点。

有关并行计算的更多通用信息,请参见运行MATLAB函数与自动并行支持万博1manbetx(并行计算工具箱)。

GPU数组

使用并行计算工具箱™在图形处理单元(GPU)上运行加速代码。

该功能完全支持GPU阵列。万博1manbetx有关更多信息,请参见在GPU上运行MATLAB函数(并行计算工具箱)。

之前介绍过的R2006a

MATLAB命令

你点击一个链接对应于这个MATLAB命令:

通过在MATLAB命令窗口中输入命令来运行命令。Web浏览器不支持MATLAB命令。万博1manbetx

你也可以从以下列表中选择一个网站:

如何获得最佳的网站性能

选择中国网站(中文或英文)以获得最佳网站性能。其他MathWorks国家站点没有针对您所在位置的访问进行优化。